Computerwissenschaft: Befehlsverweigerung durch Roboter

Der Sciencefiction-Klassiker "2001: Odyssee im Weltraum" führt uns eine bedrohliche Welt der Zukunft vor Augen, in der mit künstlicher Intelligenz ausgestattete Maschinen die menschliche Autorität in Frage stellen. Der empfindungsfähige Computer HAL 9000 übernimmt die Kontrolle über ein Raumschiff und tötet den Großteil der Mannschaft; als ein Astronaut nach einer Außenmission wieder ins Schiff zurück will und HAL auffordert, die Schleuse zu öffnen, antwortet der mit unheimlich ruhiger Stimme: "Tut mir leid, Dave, ich fürchte, das kann ich nicht tun."

In dem kürzlich in die Kinos gekommenen Zukunfts-thriller "Ex Machina" manipuliert die verführerische Androidin Ava einen unglückseligen jungen Mann so, dass er hilft, ihren Schöpfer Nathan umzubringen. Ihre Intrigen lassen Nathans dunkle Prophezeiung glaubwürdig erscheinen: "Irgendwann werden die künstlichen Intelligenzen genauso auf uns Menschen zurückschauen wie wir auf fossile Skelette in den Wüsten Afrikas. Ein aufrecht gehender Affe, lebend im Schmutz, mit primitiver Sprache und ebensolchen Werkzeugen, bestimmt zum Aussterben."

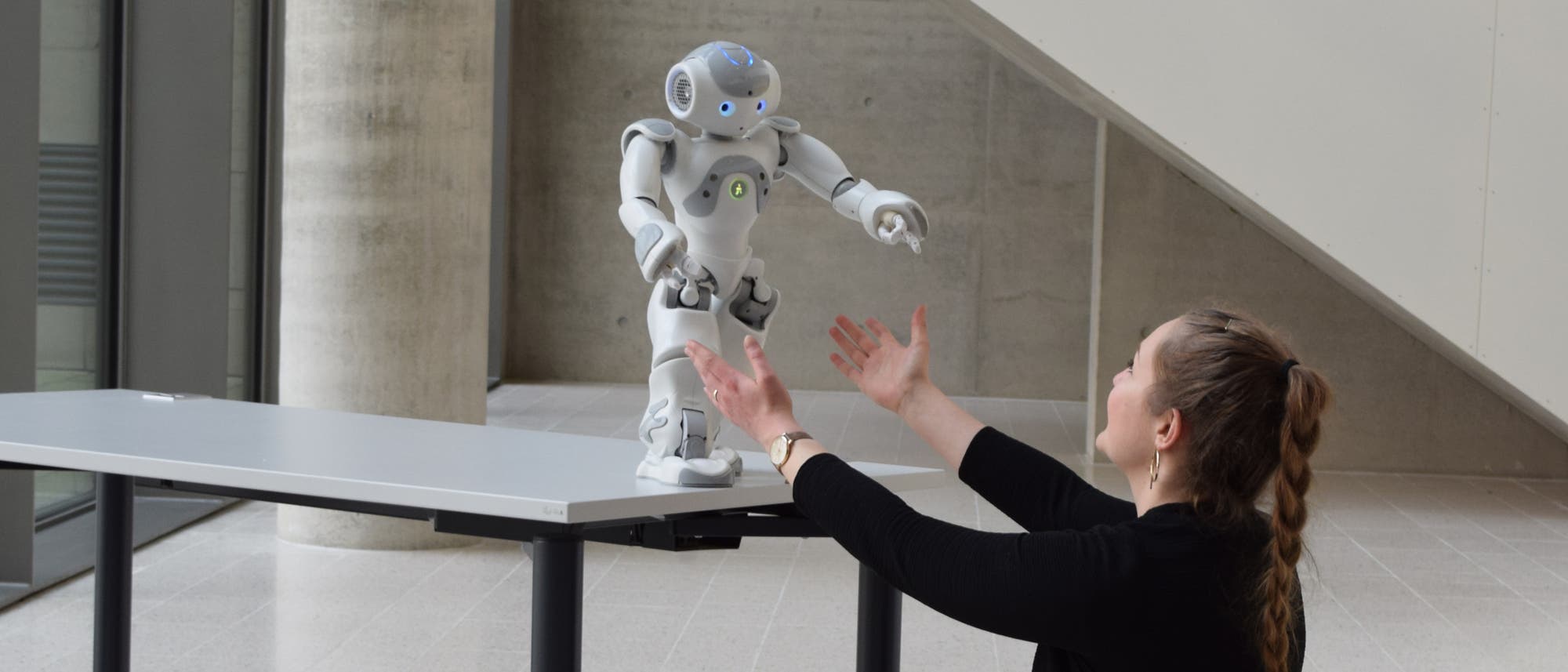

Was geschieht, wenn ein Roboter den Befehl verweigert oder den Absichten seines Erbauers zuwiderhandelt? Das gibt nicht nur einen guten Stoff für einen Kinofilm her – unsere Forschungsgruppe stellt sich dieselben Fragen, wenn es um das alltägliche Leben geht ...

Schreiben Sie uns!

Beitrag schreiben