Wissenschaftliches Publizieren: Die fatale Folge von Sensationsmeldungen

In den vergangenen Jahren verkündeten Wissenschaftler in der Astroteilchenphysik und Kosmologie eine Reihe von großen Entdeckungen. Die Liste umfasst überlichtschnelle Neutrinos, Gammastrahlen aus dem Zerfall von Teilchen der Dunklen Materie und sogar Spuren von Gravitationswellen in der kosmischen Hintergrundstrahlung – hervorgerufen durch eine Phase rascher Expansion des frühen Universums. Die meisten dieser Sensationsmeldungen stellten sich als falscher Alarm heraus; und so wie ich es sehe, dürfte es den übrigen ähnlich ergehen.

Es hat Folgen, scheinbar spektakuläre Resultate an Kollegen und die Öffentlichkeit auszuposaunen, bevor diese von unabhängigen Gutachtern überprüft sind; oder obwohl man wusste, dass schon bald bessere Daten verfügbar sein würden. Wissenschaftler, die Entwicklungen vor nicht allzu langer Zeit noch enthusiastisch verfolgt haben, schütteln nur noch die Köpfe und scherzen über "noch so einen Kandidaten für Dunkle Materie". Zu oft haben die Forscher auf diesem Gebiet falschen Alarm geschlagen, und nun haben sie an Glaubwürdigkeit eingebüßt. Ein Kollege erzählte mir, dass die Gutachtergremien immer zurückhaltender würden, die astrophysikalische Suche nach den Teilchen der Dunklen Materie zu fördern.

Ich befürchte zudem, dass nicht haltbare Sensationsmeldungen das Vertrauen der Öffentlichkeit in die Wissenschaft schwächen. Wenn kosmische Phänomene kommen und gehen – von den endlosen Spekulationen über hypothetische Konzepte wie parallele und holografische Universen ganz zu schweigen –, warum sollte man glauben, dass überhaupt irgendein wissenschaftliches Ergebnis belastbar ist?

Gleich mehrere Entwicklungen haben uns in diese Situation gebracht. Starker Wettbewerb, vermehrte Nutzung von öffentlichen Datensätzen und Internetveröffentlichungen von wissenschaftlichen Arbeiten ohne entsprechende Begutachtung durch Fachleute – all dies hat althergebrachte Standards ausgehöhlt, an die man sich früher noch zu halten pflegte, bevor man eine wirklich relevante Aussage tätigte.

Vor mehr als zwei Jahrzehnten hatte das Feld der Teilchen- und Astrophysik eine Vorreiterrolle eingenommen und begonnen, freien Zugang zu Daten und Veröffentlichungen zu gewähren; andere Disziplinen folgten diesem Beispiel. Jetzt aber muss die Wissenschaftsgemeinde die Fehlentwicklungen ins Visier nehmen, die sich im Lauf der Zeit eingeschlichen haben – und sicherstellen, dass nüchternere Darstellungen von echten wissenschaftlichen Durchbrüchen nicht von gut klingenden Berichten über nur vermeintliche Entdeckungen überschattet werden.

Neue Praktiken

Wie wissenschaftliche Studien durchgeführt werden und wie über sie berichtet wird, hat sich geändert. Auf dreierlei Weise erhöht sich dadurch die rasch zunehmende Zahl an unhaltbaren Ergebnissen. Zunächst: Zwar sinken insgesamt die statistischen Anforderungen – dennoch aber erfordern besondere Behauptungen weiter auch besondere Belege. In der Teilchenphysik liegt der übliche Schwellenwert bei "fünf Sigma": Das Signal ist fünfmal stärker als das durchschnittliche Rauschen durch andere Prozesse (eben dem "Sigma"). Werden "fünf Sigma" erreicht, so handelt es sich nur mit einer Wahrscheinlichkeit von etwa 1 zu 3,5 Millionen um einen zufälligen Effekt. Nun werden allerdings solche Fünf-Sigma-Funde immer seltener, weil Wissenschaftler anderen zuvorkommen wollen – mit spannenden, aber eben nur vorläufigen Ergebnissen. Der offiziellen Bekanntgabe der Entdeckung des Higgs-Bosons mit dem Large Hadron Collider am Forschungszentrum CERN nahe Genf im Juli 2012 gingen Pressemitteilungen von schwachen, aber dennoch viel versprechenden Hinweisen voraus – obwohl es keinen Wettstreit mit anderen Gruppen gab.

Zwar sprechen die Wissenschaftler in ihren Publikationen nicht mehr von einer "Entdeckung", sondern von "Hinweis" oder "Indiz". Doch hat das wenig Einfluss darauf, wie mit den Ergebnissen umgegangen wird. Am 8. März 2015 veröffentlichten Astronomen beispielsweise einen Vorabdruck ihrer Studie über Dunkle Materie auf dem Dokumentenserver arXiv, woraufhin die Pressestelle ihrer Universität eine Pressemitteilung dazu herausgab. Darin war zu lesen, dass man ein interessantes Signal aus einer kürzlich aufgespürten Zwerggalaxie entdeckt habe, die reich an Dunkler Materie sei. Die vom Large Area Telescope (LAT) an Bord des Weltraumteleskops Fermi nachgewiesene Gammastrahlung aus dieser Satellitengalaxie der Milchstraße schien mit jener hochenergetischen Strahlung übereinzustimmen, die bei der Annihilation von Teilchen der Dunklen Materie entstehen sollte. Allerdings räumten die Autoren ein, dass der Überschuss an Gammaphotonen nur drei- bis viermal stärker war als das Rauschsignal und damit keinen eindeutigen Schluss zulasse.

Ein weiterer, am selben Tag auf arXiv veröffentlichter Artikel rückt von der vermeintlichen Entdeckung ab. Eine erneute und umfassendere Analyse derselben Daten durch das Fermi-LAT-Team – mit einer um 30 bis 40 Prozent empfindlicheren Software – stellte abgesehen vom Rauschen kein Signal fest . Die Autoren des ersten Papers erwähnten sogar, dass ein Software-Upgrade unmittelbar bevorstand und ihre Behauptung bestätigen oder widerlegen würde. Darauf gewartet haben sie aber nicht.

Eine zufällige Schwankung im Untergrundsignal ist nichts Neues. In diesem Fall bestand aber die Möglichkeit, dass es sich bei dem "Fund" um Dunkle Materie handelt, und so wurde darüber in den Medien ausführlich berichtet. Dabei kann selbst eine ausgewogene Berichterstattung die Öffentlichkeit auf eine falsche Fährte führen. So erwähnte ein Bericht in der "New York Times" zwar explizit, dass es sich nicht um eine Entdeckung handle; die Begeisterung des Autors ist dennoch spürbar [1].

Ein weiterer Punkt: Der verstärkte Einsatz von frei zugänglichen Datensätzen erhöht das Risiko, dass Forscher nahe der Empfindlichkeitsgrenze eines Instruments vermeintliche Signale nachweisen. Zwar werden die Daten nun teils unabhängig von mehreren Wissenschaftlern durchsucht. Doch gestaltet sich die Analyse ohne Insiderwissen von denen, die das Instrument gebaut und kalibriert haben, schwierig.

Genau das traf beim vermeintlichen Nachweis von Dunkler Materie zu. Die veröffentlichten Fermi-LAT-Daten – verfügbar seit 2009 – sind das Resultat von komplizierten Algorithmen und Kalibrierungen, die die elektronischen Signale der Detektoren in Größen übersetzen, die jeder Physiker im Prinzip analysieren kann. Nur die Instrumentenbauer haben jedoch das Fachwissen, die Rauschgrenze herabzusetzen.

Je mehr Wissenschaftler einen Zugang zu den Daten haben, desto wahrscheinlicher ist auch, dass einer von ihnen eine fehlerhafte Analyse durchführt. Selbst die größten Kollaborationen können die mit ihren Daten gewonnenen Erkenntnisse durch Außenstehende nicht kontrollieren. Selbst wenn sie die Auswertung intern wiederholen, richtet ein einziges publiziertes falsches Ergebnis bereits Schaden an.

Dass immer mehr Paper auf Preprintservern wie arXiv (mit etwa 100 000 eingereichten Studien im Jahr 2014) veröffentlicht und Pressemitteilungen noch vor einer Begutachtung herausgegeben werden, ist ein dritter Grund. Der Wettbewerb um Positionen, Forschungsförderung, Kennzahlen für die Karriere eines Wissenschaftlers wie der h-Index sowie Preise bringt die Forscher dazu, ihre Ergebnisse vorzeitig zu veröffentlichen.

Fehlerhafte Studien auf arXiv lassen sich nicht einfach als irrelevante Ergebnisse verbuchen. Förderentscheidungen werden durch sie verzerrt; Theoretiker verschwenden viel Zeit damit, sich Erklärungen auszudenken; und die Öffentlichkeit wird durch Pressemeldungen in die Irre geführt.

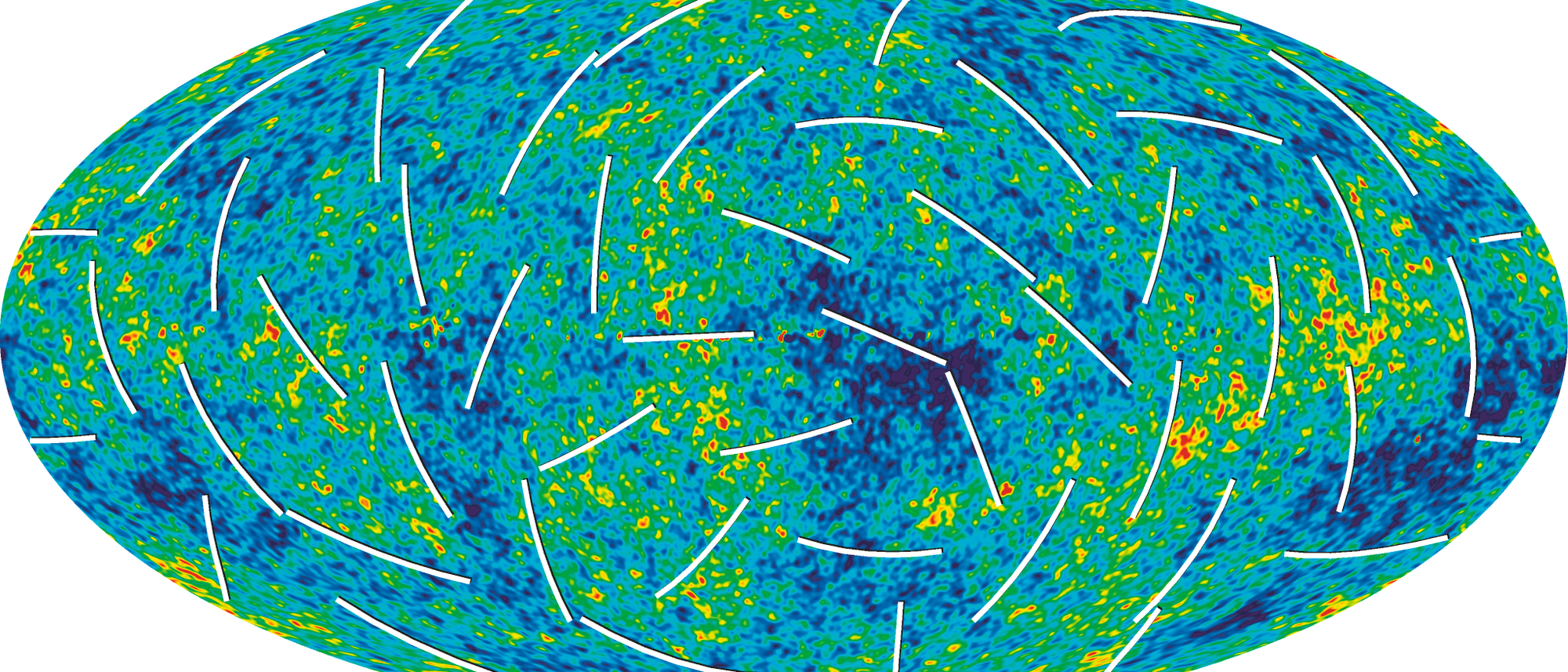

Ein Paradebeispiel für eine vorschnelle Behauptung, die man noch vor einer unabhängigen Begutachtung online veröffentlichte, war ein Bericht im vergangenen Jahr über Hinweise auf Gravitationswellen und die kosmische Inflation, die rasante Expansion des Universums unmittelbar nach dem Urknall, in Daten des BICEP2-Mikrowellenteleskops am Südpol. Der Nachweis eines verwirbelten Polarisationsmusters, B-Mode genannt, in der kosmischen Mikrowellenhintergrundstrahlung stand mit sieben Sigma außer Zweifel.

Doch der angeblich kosmische Ursprung des Signals erwies sich als Irrtum: Sechs Monate später zeigte sich mit Daten des Weltraumteleskops Planck von der Europäischen Weltraumorganisation, dass tatsächlich Staub im Milchstraßensystem verantwortlich war. Ich gehe auch hier davon aus, dass die Autoren der ursprünglichen Studie von der bevorstehenden Bekanntgabe der neuen Planck-Daten gewusst haben. Dennoch entschieden sie sich dafür, ihre Ergebnisse vor deren Bestätigung herauszuposaunen. Die Teams von BICEP2 und Planck arbeiteten schließlich zusammen, um ein belastbares Resultat zu erhalten – ein Ansatz, den man von Anfang an hätte in Betracht ziehen sollen.

Qualitätskontrolle

Um wissenschaftliche Standards und das Ansehen der Forscher nicht weiter zu gefährden, sollte man sich künftig an bewährte Methoden halten.

Die Fünf-Sigma-Hürde (oder etwas Vergleichbares) als Indikator für eine tragfähige Entdeckung zu beherzigen, wäre ein erster Schritt für Physiker. Zudem darf das Einstellen ins Internet eine wissenschaftliche Publikation nicht ersetzen. Und wenn die Öffentlichkeit genauso schnell von einer wichtigen Erkenntnis erfährt wie die wissenschaftlichen Kollegen, ist das einfach zu früh. Eine kritische Prüfung durch unabhängige Fachleute ist unerlässlich, nicht zuletzt, um Befangenheit zu vermeiden.

Solange das Onlinestellen eines Artikels mit der Veröffentlichung eingehend geprüfter Ergebnisse verwechselt wird, sollte die Qualitätssicherung der online verfügbaren Vorabdrucke verbessert werden. arXiv entwickelte bereits ein "Empfehlungssystem", bei dem Nutzer von anderen Nutzern empfohlen werden müssen, bevor sie ein Paper einstellen dürfen. Auf diese Weise soll sichergestellt werden, dass dort nur wissenschaftliche Beiträge erscheinen. Für sensationelle Forschungsergebnisse reicht das allerdings nicht aus. Im Fall von bahnbrechenden Entdeckungen könnten vorher benannte Gutachter die Leser und Autoren rückversichern – zudem wäre es eine Auszeichnung für die Gutachter. Fachjournals sollten von der Bezugnahme auf arXiv-Paper abraten.

Instrumentenkenner und Spezialisten, die die Ausgangsdaten aufgenommen haben, sollten besonders relevante und auf öffentlichen Datensätzen beruhende Ergebnisse überprüfen, sei es als Gutachter, Berater oder Teammitglied. Andere Gruppen, die eine Behauptung mit zusätzlichen Daten entkräften oder bestätigen können, sollten bei der Kontrolle spektakulärer Entdeckungen vor deren Veröffentlichung einbezogen werden. Dies erfordert ein faires Verhalten unter Konkurrenten – und das könnte, wie bereits erwähnt, durch die Benennung von Gutachtern für wegweisende Arbeiten gefördert werden.

Es muss ein Verfahren etabliert werden, in dem vorbildliche Vorgehensweisen belohnt werden. In Kollaborationen sollte man sicherstellen, dass ein Team für die Datenerhebung, das mit einem einzelnen Wissenschaftler zusammenarbeitet, weder wetteifernd die Veröffentlichung des Wissenschaftlers abwertet noch seine eigene Sichtbarkeit herabsetzt. Interne Kontrollen müssen der Bekanntgabe der wichtigsten Ergebnisse auf Konferenzen vorausgehen. Für Autorenlisten sollten Strategien entwickelt werden, um die jeweilige Leistung angemessen zu würdigen.

Fachzeitschriften und arXiv sollten einen Weg finden, die Anerkennung wissenschaftlicher Leistungen zwischen den leitenden Wissenschaftlern in solchen Kooperationen aufzuteilen. Das BICEP2-Team arbeitete später beispielsweise mit der Planck-Kollaboration zusammen; hätten diese ihre Stellung klarermachen können, hätten sie eine Pressekonferenz womöglich hinausgezögert.

Wenig überraschend, dass das erste BICEP2-Paper zehnmal öfter zitiert wird als das abschließende Ergebnis. Dieses Missverhältnis lässt sich häufig beobachten. Es gilt Kennzahlen auszuarbeiten, welche die Zitathäufigkeit solcher vermeintlichen Entdeckungen nicht gleichwertig einbeziehen. Damit wäre es nicht mehr vorteilhafter, ein Resultat zu veröffentlichen und wieder zurückziehen, als eine belastbare Aussage zu machen.

Physikalische Fachgesellschaften wie die American Physical Society und die International Union of Pure and Applied Physics sollten eine Bewegung anführen – ähnlich der Reproduzierbarkeits-Initiative in der Biologie. Wissenschaftler, Verleger und Vertreter von Förderinstitutionen müssen zusammenkommen, um über verbesserte Standards wie Kreuzgutachten, Kennzahlen, die Nutzung von Datenbanken, Qualitätssicherung und Verhaltensregeln zu diskutieren.

Der Artikel ist im Original "Reproducibility: Don't cry wolf" in "Nature" erschienen.

Schreiben Sie uns!

6 Beiträge anzeigen