Technik: Wie klein kann man einen Computer bauen?

Da haben wir nun eine Frage, die in den letzten Jahren so manchem Tüftler den Schlaf geraubt haben dürfte. Die kürzestmögliche Antwort darauf lautet wohl so: sehr, sehr, sehr klein. Bereits im Jahr 2013 gab es einen voll funktionsfähigen Computer, der nicht größer war als ein Sandkorn. Er ist dafür gedacht, direkt in den menschlichen Augapfel implantiert zu werden, um dort im Fall einer Erkrankung am grünen Star die Entwicklung des Glaukoms überwachen zu können. Der Name dieses Zwergcomputers – "Micro Mote" – ist eine pfiffige Anspielung auf den biblischen "Splitter" im Auge des Betrachters. "Micro Mote" kann Daten verarbeiten, speichern und sogar per Funk übertragen; die dazu benötigte Energie erzeugt eine Solarzelle aus dem Licht, das in das Auge einfällt.

Und das "Pico-Inside"-Projekt der Europäischen Union hat ein ganz simples Logikgatter zur Verarbeitung einfachster Signale hervorgebracht, das sogar noch um ein Vielfaches kleiner ist. Seine Rechenkapazität entspricht der Leistung von 14 Transistoren, dabei besteht es aus gerade einmal 30 Atomen. Das bedeutet, dass dieses Gerät nicht nur zu klein ist, um es unter einem Lichtmikroskop zu entdecken: Mit Ausnahme der besten und leistungsstärksten Rastertunnel- oder Atomkraftmikroskope versagen sämtliche Vergrößerungsgeräte, wenn sie diesen Winzling auf den Schirm bringen sollen. Im Gehäuse des "Micro Mote" könnte man ungefähr eine Trillion Exemplare der Pico-Inside-Schaltung unterbringen!

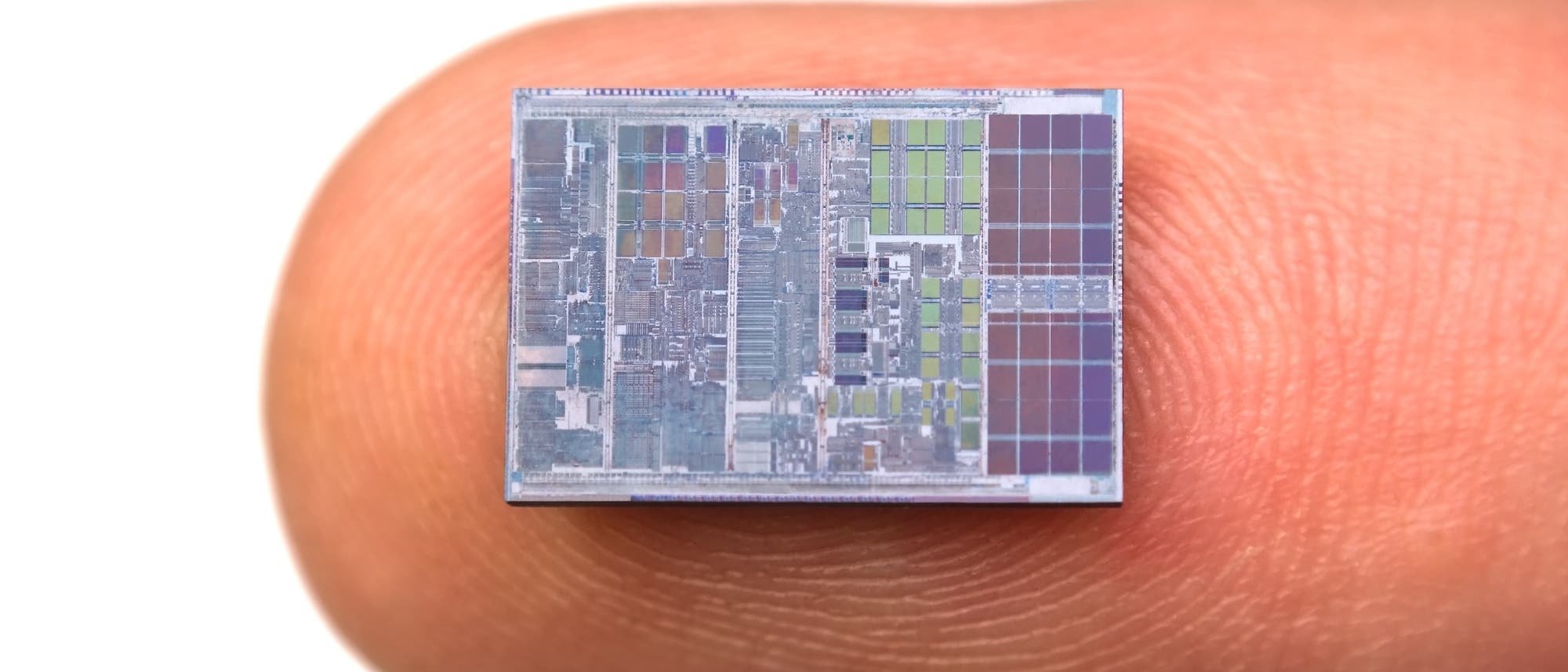

Ende der 1960er Jahre ist dem Computerpionier Gordon Moore, der etwa um dieselbe Zeit auch zu den Mitbegründern des Halbleiterherstellers Intel gehörte, etwas Erstaunliches aufgefallen. Im Jahr 1958 hatte man bei seiner früheren Firma Fairchild Semiconductor erstmals zwei Transistoren im Inneren eines Siliziumkristalls zu einem integrierten Schaltkreis zusammengeschlossen: Der erste Siliziumchip war geboren. Danach hatte sich, wie Moore nun bemerkte, die Anzahl der Transistoren, die auf einem Chip untergebracht werden konnten, mit jedem Jahr, das verstrich, ungefähr verdoppelt. Seither hat das "mooresche Gesetz" Jahr um Jahr seine Gültigkeit bewiesen: Die Grundbausteine der Elektronik sind immer weiter geschrumpft.

Zuletzt ist dieser Miniaturisierungsprozess ein wenig langsamer vorangekommen, und die Anzahl der Transistoren hat sich "nur noch" alle zwei Jahre verdoppelt. Dennoch verdanken wir der von Gordon Moore vorhergesagten Entwicklung all die "smarten" Geräte, die uns heutzutage zur Verfügung stehen: Tablets und Smartphones, deren Rechenleistung vor nicht allzu langer Zeit einem Supercomputer zur Ehre gereicht hätte, und so weiter. Aber jedes Mal, wenn irgendwer die Vermutung äußert, jetzt müsse es doch langsam einmal genug sein mit dieser ewigen Schrumpfung, scheinen sich die Computerentwickler einen Spaß daraus zu machen, ihre elektronischen Wunderwerke in immer noch kleinere Gehäuse zu packen.

Die Frage ist also eher: Wie viel kleiner kann man einen Computer denn noch bauen? Oder auch: Wozu sollte man einen noch kleineren Computer denn überhaupt brauchen?

An den Grenzen des Machbaren

Tatsächlich scheint es so, als gelangten wir auf dem Gebiet der herkömmlichen Transistortechnik langsam, aber sicher an die Grenzen des Machbaren. Bereits jetzt bewegt sich die Größe der Bauteile im Nanometerbereich – in einer Größenordnung von milliardstel Metern also, der Größe beispielsweise von Viren. Beim weiteren Fortschreiten in Richtung immer kleinerer Nanoelektronik dürfte es daher bald zu Problemen kommen. Das liegt daran, dass Transistoren als "Tore" oder "Schleusen" dienen, die so geschaltet werden können, dass sie den Fluss der Elektronen entweder in bestimmte Bahnen lenken oder aber ganz unterbrechen. Nähert sich nun die Dicke der "Schleusentore" der magischen Grenze von etwa einem Nanometer (nm) an, kommen Quanteneffekte ins Spiel, insbesondere der Quantentunneleffekt, bei dem ein Elektron die Barriere "durchtunnelt", als wäre sie überhaupt nicht da. (Eigentlich ist die Rede vom "Tunnel" aber irreführend: Das Elektron verschwindet schlicht auf der einen Seite und taucht auf der anderen wieder auf.) Wenn jedoch das Gatter die Elektronen auf Grund des Quantentunneleffekts nicht aufhalten kann, kann auch der Transistor als ganzer nicht funktionieren. Die kleinsten Transistoren messen mittlerweile gerade einmal 30 nm von einem Ende zum anderen; es ist also durchaus möglich, dass die Technik hier bald an ihre Grenzen stößt.

Der biblische "Splitter" im Auge des Betrachters

"Was siehst du aber den Splitter in deines Bruders Auge, und wirst nicht gewahr des Balkens in deinem Auge?" (Mt 7,3). In der Fassung der gängigsten englischen Bibelübersetzung, der King James Version von 1611, ist dieser "Splitter" ein "Staubkorn" (mote): And why beholdest thou the mote that is in thy brother's eye, but considerest not the beam that is in thine own eye?

Miteinander verschaltete Transistoren bilden die Logikgatter, auf denen die gesamte Computertechnik beruht: Sie sind die Jas oder Neins, die Unds und die Oders, die Nullen und die Einsen, aus denen die digitale Welt gemacht ist. Wenn die Transistortechnik nun aber nicht mehr weiter verfeinert werden kann – könnte man Logikgatter nicht auch auf andere Weise bauen, auf eine Weise, die die Beschränkungen der Quanteneffekte umgeht? Genau daran arbeiten die Wissenschaftler des Pico-Inside-Teams und ihre Fachkollegen weltweit. Anstatt immer mehr Rechenleistung auf immer kleinerem Raum unterbringen zu wollen, haben sie mit der Suche nach Lösungen noch einmal ganz von vorn angefangen und versuchen nun, einen Computer aus einzelnen Atomen zu bauen, um auf diese Weise die Effekte der Quantenphysik für sich arbeiten zu lassen, anstatt gegen sie anzukämpfen. Um solche Computer bauen zu können, muss man natürlich in der Lage sein, die einzelnen Atome herumzubugsieren; dazu verwendet man ein Atomkraftmikroskop, mit dem die Atome vorsichtig an ihre Stelle geschoben werden. Abgesehen von dem Logikgatter aus nur 30 Atomen ist es den Forscherteams bislang gelungen, winzig kleine Fahrzeuge, Schaltgetriebe, Räder und sogar Motoren zu basteln, die jeweils aus einem einzigen Molekül bestehen. Bis zu einem auch nur halbwegs funktionierenden Computer ist es selbstverständlich noch ein weiter Weg – aber die Möglichkeiten sind schon jetzt deutlich erkennbar.

Ein großes Problem mit solchen Nanocomputern betrifft nicht ihre Rechenleistung, sondern das "Drumherum": Woher sollen sie ihre Energie beziehen? Wie kann man sie ausreichend kühlen? Wie sie mit anderen Geräten Kontakt aufnehmen lassen? Es bringt ja nichts, einen Computer von der Größe eines einzelnen Moleküls zu bauen, wenn dieser dann einen Funkadapter benötigt, der eine Billion Mal so groß ist, oder eine Solarzelle, die sogar noch größer wäre! Davon, dass Solarzellen an dunklen Orten ziemlich nutzlos sind, einmal ganz abgesehen. Das alles sind Probleme, die erst einmal gelöst sein wollen, soll die Nanocomputer-Technologie alltagstauglich werden.

Quantencomputer

Noch viel dramatischer als der Nanocomputer könnte sich eine andere Technologie auswirken, für die das simple Logikgatter der Transistor-Ära überhaupt keine Rolle mehr spielt: Die Rede ist von Quantencomputern. Das Ziel ist nun nicht mehr die Entwicklung eines möglichst kleinen Computers auf Transistorbasis, sondern die Konstruktion eines Prozessors allein auf quantenphysikalischer Grundlage. Dieser soll dann Rechengeschwindigkeiten erreichen, die um ein Vielfaches über den Leistungen aktueller Computer liegen – was letztlich wohl zum selben Ergebnis führen dürfte, denn um einen Quantencomputer zu bauen, muss man die Bauteile ohnehin auf einen Maßstab verkleinern, der das Auftreten von Quanteneffekten überhaupt zulässt, und das heißt: auf den Maßstab einzelner Atome, Elektronen, ja sogar Photonen. Sollte ihre Konstruktion tatsächlich gelingen, werden die Prozessoren der Quantencomputer also – ganz wie die "herkömmlichen" Nanocomputer – aus einzelnen Atomen oder sogar subatomaren Teilchen zusammengesetzt sein.

Dahinter steckt die Idee, die "Bits" eines herkömmlichen Computers, die jeweils einen der beiden Werte 0 oder 1 annehmen können, durch "Quantenbits" oder "Qubits" zu ersetzen, deren Zustände durch Quanteneffekte beeinflusst werden und daher nicht nur 0 oder 1 sein können, sondern – durch Überlagerung der zwei Möglichkeiten – auch beides zugleich. Bei den heutigen Computern ist es so, dass die Bits im Zuge einer Rechenoperation ihre möglichen Zustände nacheinander durchlaufen müssen. Verwendet man Qubits, kann man diese einzelnen Schritte gleichzeitig vollziehen. In der Praxis bedeutet das, dass ein Quantencomputer dieselbe Rechenoperation mehrere Millionen Mal schneller ausführen könnte als sein konventionelles Pendant.

Jedes Mal, wenn irgendwer die Vermutung äußert, jetzt müsse es doch langsam einmal genug sein mit dieser ewigen Schrumpfung, scheinen sich die Computerentwickler einen Spaß daraus zu machen, ihre elektronischen Wunderwerke in immer noch kleinere Gehäuse zu packen

Im Jahr 2014 schaffte es die kanadische Firma D-Wave mit einer Meldung auf die Titelseite des Magazins "Time", der zufolge es ihren Ingenieuren gelungen war, den ersten kommerziell nutzbaren Quantencomputer zu entwickeln. Dieser heißt ebenfalls D-Wave, ist etwa so groß wie ein großer Kleiderschrank und funktioniert; aber ob es tatsächlich ein Quantencomputer ist, weiß keiner so recht. Auch ist bislang unklar, welchen Nutzen ein solcher Computer zurzeit brächte. Ein Vorschlag lautet, Banken einen solchen Quantencomputer doch nutzen zu lassen, um durch seine überragende Rechengeschwindigkeit die Finanzmarkt-Konkurrenz bei kritischen Transaktionen ganz einfach auszustechen; das wäre dann wohl eine Nutzanwendung, die tatsächlich eine ganze Menge Geld einbringen könnte. Der zu erwartende Nutzen der Quanteninformatik für Otto Normalverbraucher hingegen ist bislang alles andere als klar.

Wozu das alles?

Dieselbe Frage stellt sich mit Blick auf die Nanocomputer: Wozu das alles? Warum um alles in der Welt sollte man sich einen Computer von der Größe eines Sandkorns wünschen, wo man doch schon sein ultraschlankes Smartphone ständig irgendwo im Haus liegen lässt und nicht mehr wiederfindet? Auf diese Frage gibt es mindestens zwei gute Antworten.

Die erste wäre, dass man durch Nanocomputer selbst Geräten, die in etwa so groß bleiben würden wie bisher – Handys zum Beispiel –, zu einer drastisch erhöhten Rechenleistung verhelfen könnte – was diese Geräte vermutlich befähigen würde, allerhand fantastische Dinge anzustellen, von denen wir heute noch kaum zu träumen wagen. Nun wenden Kritiker ein, das sei ja wohl die völlig falsche Herangehensweise: Es bestehe überhaupt kein Grund, die Rechenleistung einzelner Computer zu erhöhen; stattdessen solle man lieber die Verknüpfung der bestehenden Computer optimieren, damit die kombinierte Rechenleistung aller so verbundenen Geräte gleichzeitig genutzt werden könne – etwa durch das so genannte Cloud-Computing einer ganzen "Rechnerwolke". Auf diese Weise könnte die Leistung eines einzelnen Computers vergleichsweise gering bleiben, wiewohl über die "Cloud" ein riesiges Rechenpotenzial zur Verfügung stünde.

Wer hätte sich vor 60 Jahren schon träumen lassen, dass die Computer im Jahr 2016 so winzig sein würden, wie sie es nun tatsächlich sind?

Die zweite Antwort wäre wohl, dass Nanocomputer uns bei Arbeiten im Nanometerbereich zur Hand gehen könnten. Die aufregendsten Möglichkeiten in dieser Hinsicht eröffnen sich vermutlich mit Blick auf den menschlichen Körper. Den "Micro Mote", der im Inneren des menschlichen Auges zum Einsatz kommt, habe ich bereits erwähnt. Aber Nanocomputer könnten auch in den Blutkreislauf eingeschleust werden, um dort Durchblutung und Blutdruck zu überwachen, oder andere Diagnosen mit "Vor-Ort-Analysen" zu unterstützen. Ein einziger solcher Zwergcomputer allein mag wenig bringen, aber ganze Schwärme von Minirechnern, die mit einer einzigen Kapsel geschluckt werden könnten, wären dann vielleicht in der Lage, das Cholesterin im Blut aufzuspalten oder flugs die Nierensteine zu zerbröseln, die man andernfalls womöglich operativ entfernen müsste.

Andere Wissenschaftler sprechen davon, sich die Eigenschaften organischer Moleküle zu Nutze machen zu wollen, um auf diese Weise biologisch abbaubare Computer zu bauen, die im Inneren lebender Zellen eingesetzt werden könnten, zur Bekämpfung von Krebszellen oder zur zielgenauen Verabreichung bestimmter Wirkstoffe an bestimmte andere Zellen.

Die Vorstellung, unser Körper könnte in Zukunft durch Schwärme unvorstellbar kleiner, mit Prozessoren ausgestatteter Apparate von innen "repariert" oder sogar ständig gewartet werden, mag durchaus verlockend erscheinen, auch wenn sie natürlich etwas Verstörendes an sich hat. Sollte es jemals tatsächlich so weit kommen, hätten wir es womöglich mit dem größten Durchbruch in der Geschichte der medizinischen Forschung zu tun. Von der Medizin einmal ganz abgesehen, könnten Nanocomputer natürlich auf einer Vielzahl anderer Felder zum Einsatz kommen, von der Reinigung unzugänglicher Rohre bis zur Herstellung von Chemikalien Molekül für Molekül.

All das liegt wohl noch weit in der Zukunft, denn die Probleme beim Bau, der Energieversorgung und Steuerung der beschriebenen Gerätschaften sind momentan noch beträchtlich. Andererseits: Wer hätte sich vor 60 Jahren schon träumen lassen, dass die Computer im Jahr 2016 so winzig sein würden, wie sie es nun tatsächlich sind? Oder dass sie, noch dazu, so leistungsstark sein würden und mit ihrer Rechenkapazität allerlei kleine Wunder vollbringen können, die uns mittlerweile vielleicht schon selbstverständlich erscheinen? Ich denke hier beispielsweise an die Tatsache, dass man heute mit einem winzigen Mobiltelefon fast überall auf der Welt ins Internet gehen kann – ist das nichts?

Ich für meinen Teil könnte im Moment wohl keinen Computer bauen, der in Sachen Miniaturisierung oder Komplexität über das Niveau eines Abakus hinauskäme – dafür gibt es andere Leute, die das können. Stattdessen habe ich mir überlegt, dass ich auf andere Weise viel besser zu diesem Projekt beitragen könnte: Ich könnte an der Herstellung des besten Computers mitwirken, den die Welt je gesehen hat – ganz recht, ich meine das menschliche Gehirn. Selbst im ausgewachsenen Zustand ist das Gehirn des Menschen, bedenkt man sein Leistungsvermögen, unheimlich klein – der leistungsstärkste Computer, den es gibt. Was hältst du also davon, Schätzchen, wenn wir beide heute Nacht einen Supercomputer machen …?

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.