Quantenfehlerkorrektur: Google läutet eine neue Ära des Quantencomputings ein

Neue Wirkstoffe, Wundermaterialien und ein tieferes Verständnis der Quantenwelt: Das sind nur einige der beeindruckenden Versprechungen von Quantencomputern. Zwar wurden bereits Geräte mit 1000 Quantenrecheneinheiten, so genannten Qubits, realisiert, doch die Maschinen sind noch immer sehr fehleranfällig. Das liegt an der Fragilität der Qubits. Wenn sie mehrere Rechenschritte hintereinander ausführen, summieren sich die Fehler immer weiter auf – das Ergebnis wird wertlos. Daher steht und fällt der Erfolg von Quantencomputern mit so genannten Quantenfehlerkorrektur-Verfahren. Diese sollen Fehler schnell erkennen und ausbessern, um so zuverlässige Quantenberechnungen zu gewährleisten.

Ein viel versprechender Kandidat für ein solches Verfahren ist der 1998 von Alexei Kitaev und Sergey Bravyi entwickelte »Surface Code«, auf Deutsch auch »Oberflächencode« genannt. Die Quanteninformation wird in diesem Fall nicht von einem einzelnen Qubit, sondern von mehreren getragen. Diese vielen »physischen« Qubits codieren dann ein einzelnes »logisches« Qubit, das die eigentliche Recheneinheit darstellt. Generell gilt dabei die Regel: je mehr physische Qubits, desto kleiner die Fehlerrate des daraus bestehenden logischen Qubits. Doch das trifft nur dann zu, wenn die physischen Qubits selbst nicht allzu fehleranfällig sind – eine Hürde, die nie überwunden wurde. Bis jetzt.

Im August 2024 berichteten die Fachleute von Google Quantum AI erstmals davon, Quantenprozessoren mit ausreichender Qualität zu haben, um die Quantenfehlerkorrektur-Schwelle zu überwinden. Die logischen Qubits sind deutlich weniger fehleranfällig als die stabilsten einzelnen physischen Qubits – und es zeichnet sich ein eindeutiger Trend ab: »Jedes Mal, wenn wir die (physische Qubitzahl) verdoppeln, halbiert sich die logische Fehlerquote«, schreibt der Physiker Michael Newman von Google Quantum AI auf X. »Das zeigt die charakteristische Schwellenüberschreitung, die wir bereits in Millionen von Theorie-Papern gesehen haben – aber nun endlich auf einem echten Quantencomputer!« Das beeindruckt auch Quanteninformationsforscher wie Jens Eisert von der FU Berlin, der das Ergebnis als »sehr eindrucksvoll« beschreibt. Die Arbeit hat nun auch den Peer-Review-Prozess durchlaufen und ist in der Fachzeitschrift »Nature« erschienen.

Von Festkörpern inspiriert

Der Oberflächencode wird bereits seit den 2000er Jahren intensiv erforscht, da er eine viel versprechende Methode zur Fehlerkorrektur in Quantencomputern darstellt. Das Problem mit Qubits ist nämlich, dass sich ihre Quanteninformation nicht kopieren lässt. Herkömmliche Fehlerkorrekturmechanismen, die auf gewöhnlichen Rechnern laufen, fußen aber gerade auf Redundanz. Indem man Informationen geschickt dupliziert, stellt man sicher, dass Fehler bemerkt und korrigiert werden können. Damit das mit Quantencomputern gelingt, muss man ausgeklügelte Verfahren entwickeln.

Wegweisend waren dabei die Arbeiten des Physikers Alexei Kitaev vom California Institute of Technology. Dieser hatte die bahnbrechende Idee, mehrere Qubits wie die Atome eines Kristalls in einem Gitter anzuordnen und deren Eigenschaften zu untersuchen. Kitaev wählte den Aufbau des Systems so, dass der Grundzustand (also der mit der niedrigsten Energie) der Situation entspricht, bei der die Qubits fehlerfrei ihre Berechnungen durchführen. Sobald ein Fehler auftaucht, wird dieser automatisch bemerkt (denn er führt zu einer spürbaren Anregung im System) und lässt sich korrigieren.

»Das Verfahren funktioniert nur, wenn die Fehlerrate unter dem Schwellenwert liegt. Sonst macht die Korrektur alles nur noch schlimmer«Jens Eisert, Physiker

Auch wenn das Prinzip schon seit mehr als 20 Jahren bekannt ist, konnte es bisher aus technischen Gründen nicht sinnvoll umgesetzt werden. »Das dichte Gitter des Oberflächencodes, bei dem jedes physische Qubit mit vier weiteren verbunden ist, ruft häufig neue Fehler hervor«, schrieb die Physikerin Zaira Nazario von IBM in einem Artikel, der 2022 bei »Spektrum der Wissenschaft« erschien. Und das führt zu Problemen, wie Eisert erklärt: »Das Verfahren funktioniert nur, wenn die Fehlerrate unter dem Schwellenwert liegt. Sonst macht die Korrektur alles nur noch schlimmer.«

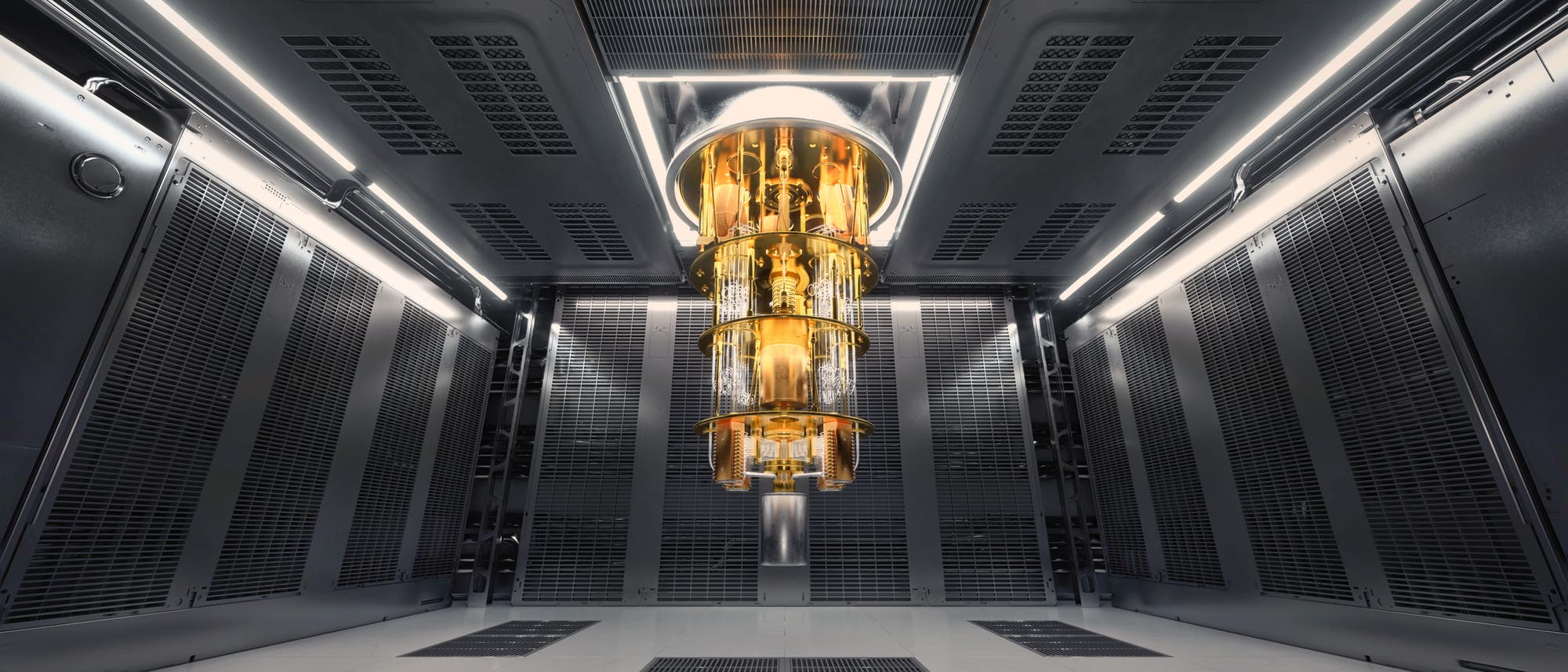

Nun ist es dem Team von Google Quantum AI erstmals gelungen, die Fehlerrate mit seinen Quantenprozessoren zu unterschreiten. Die Fachleute verwenden supraleitende Schaltkreise als Qubit-Plattform, deren Fabrikationstechniken sie in den vergangenen Jahren immer weiter optimiert haben. Das hat zu deutlich längeren Dekohärenzzeiten der Qubits geführt – diese beschreiben die maximale Dauer, in denen Qubits in überlagerten oder verschränkten Zuständen verharren können. Damit sind die Recheneinheiten wesentlich stabiler, denn die Dekohärenz ist eine der bedeutendsten Fehlerquellen in Quantencomputern.

Das ermöglichte den Forschenden, verschiedene Versionen des Oberflächencodes umzusetzen: einen »Distanz-7«-Code, bei dem 97 physische Qubits ein logisches Qubit codieren, sowie einen »Distanz-5«-Code, der 49 Qubits zu einem logischen verbindet. Ersteren ließen sie auf einem 105-Qubit-Quantenprozessor laufen, den zweiten auf einem 72-Qubit-Prozessor. Die Distanz zwischen den Qubits gibt an, wie weit verschiedene »Codewörter« (Darstellungen der Quanteninformation) voneinander entfernt sind – je größer die Distanz, desto stärker müssen die Störungen sein, damit ein Fehler unbemerkt bleibt. Aus theoretischer Sicht ist bekannt, dass größere Distanzen die Fehlerrate unterdrücken sollten. Das konnten die Fachleute nun zum ersten Mal mit realen Quantenprozessoren nachweisen.

»Interessant ist aber vor allem auch, dass ein volles Schema vorgestellt wird. Also nicht nur die Hardwareplattform, sondern auch ein Echtzeitdecodierer, der die eigentliche Korrektur betreibt«, sagt Eisert. Tatsächlich haben die Forschenden gezielt Fehler in ihren Qubits hervorgerufen und diese in Echtzeit korrigieren lassen. Beim Distanz-5-Code benötigte der Decodierer dafür lediglich 63 Mikrosekunden.

»Vor einem Jahr hätte ich gedacht, dass solche Ergebnisse noch in ferner Zukunft liegen«Jens Eisert, Physiker

Damit markiert die Arbeit der Fachleute einen Durchbruch. Es wird wahrscheinlich nicht lange dauern, bis die Konkurrenz nachzieht, vermutet Eisert. Er sieht großes Potenzial in den Systemen von IBM, die ebenfalls mit supraleitenden Schaltkreisen arbeiten, sowie bei Quantencomputern, die mit ultrakalten Atomen (unter anderem auch erfolgreich in Deutschland) betrieben werden. Und sogar bei dem noch als Nische angesehenen Bereich der photonischen Quantencomputer könnte es bald spannende Ergebnisse geben: »Ich denke nicht, dass PsiQuantum eine Milliarde Australische Dollar von Australien bekommen hätte, wenn sie keine Ideen zur praktischen Fehlerkorrektur hätten«, sagt Eisert.

Allerdings ist noch viel Arbeit nötig, bis wirklich fehlertolerante Quantencomputer verfügbar sind. Die jetzt vorgestellten Ergebnisse sehen zwischen 50 und 100 physische Qubits zur Codierung einer einzelnen logischen Informationseinheit vor. Für komplexere Berechnungen sind allerdings zahlreiche logische Qubits nötig: hunderte oder gar tausende. »Aber es geht voran«, sagt Eisert. »Vor einem Jahr hätte ich gedacht, dass solche Ergebnisse noch in ferner Zukunft liegen.«

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.