Optische KI: Rechnen mit der Glasfaser

In der Datenübertragung hat sich Licht schon längst etabliert. Verschwindend geringe Energieverluste und die Möglichkeit, Informationen parallel - nämlich in Form von Pulsen verschiedener Farben - durch eine einzige Glasfaser zu schicken, lassen den alten Kupferleitungen keine Chance. Für ein Schweizer Forscherteam sind die Fasern jedoch mehr als bloße Datenkanäle. Sie wollen stattdessen mit der Glasfaser selbst die Daten verarbeiten.

Möglich machen es die komplexen Wechselwirkungen des Lichts mit dem Material der Glasfasern. Stellt man es geschickt an, können sie die verarbeiteten Daten genau so verändern, wie es sonst ein Computerchip tun müsste. Wie das funktioniert, hat die Forschergruppe im August vergangenen Jahres in der Fachzeitschrift »Nature Computational Science« vorgestellt. Ihr System namens SOLO (Scalable optical learning operator) gehört in den Bereich der künstlichen Intelligenz (KI). Und obwohl es sich noch um Grundlagenforschung handelt, gelang es SOLO bereits auf Porträtfotos das Alter der Abgebildeten zu schätzen oder Covid-19-Erkrankungen auf Röntgenbildern der Lunge zu erkennen - und das mit einem Bruchteil der sonst dafür benötigten Energie.

Ein gewöhnlicher Computerchip hat den Vorteil, dass er universell einsetzbar ist. Er kann ganz unterschiedliche Prozesse durchführen, je nachdem worauf man ihn programmiert. Müssen jedoch sehr viele Daten auf die gleiche Weise verarbeitet werden, wird das zum Nachteil - der Prozessor arbeitet die einzelnen Vorgänge nacheinander ab, das kostet Zeit verglichen mit einem System, das sie parallel verarbeitet. Besonders in der KI taucht dieses Problem auf. Die künstlichen neuronalen Netze, vor allem die »tiefen« Netze des so genannten Deep Learning, haben in den vergangenen Jahren verblüffende Leistungen gezeigt. Meist sind sie es, die hinter den Fortschritten bei der Bild- oder Spracherkennung stecken, sie machen es möglich, dass immer mehr Autos in immer mehr Situationen eigenständig fahren. Sie zwingen aber auch herkömmliche Hardware in die Knie, angesichts der schieren Masse an Daten, die insbesondere beim Lernvorgang verarbeitet werden müssen.

Wenn beispielsweise ein und dieselbe mathematische Funktion millionenfach hintereinander angewendet werden muss, werden normale Prozessoren zum Nadelöhr, optische Systeme aber spielen speziell in diesem Punkt ihre Stärken aus. Denn so wie verschiedenfarbige Lichtpulse Daten parallel in derselben Glasfaser übertragen, können auch optische Schaltungen mehrere Berechnungen gleichzeitig ausführen. Dass sich solche optischen Schaltkreise inzwischen in kompakte Chips übertragen lassen, tut sein Übriges, um Start-ups in aller Welt zum Bau erster kommerzieller Produkte zu motivieren.

Das Glasfasermaterial übernimmt die Rechenarbeit

Das Schweizer Forscherteam um Christophe Moser und Demetri Psaltis von der École Polytechnique Fédérale de Lausanne geht mit seiner Arbeit jedoch einen anderen, eher ungewöhnlichen Weg. Denn während aktuelle Ansätze für optische Computer zumeist darauf aufbauen, mit der Intensität von Lichtpulsen konkrete Zahlenwerte darzustellen und diese möglichst geschickt und vor allem gezielt zu verändern, nutzen die Schweizer die Materialeigenschaften der Glasfaser, um das Signal zu manipulieren. Auf eine Weise, die im Detail weitgehend unklar ist - und trotzdem funktioniert es. »Das ist so ähnlich wie in den Tiefen der künstlichen neuronalen Netze«, sagt Moser. »Da muss man auch oft akzeptieren, dass man das Zusammenspiel der Millionen von Neuronen nicht genau nachvollziehen kann.«

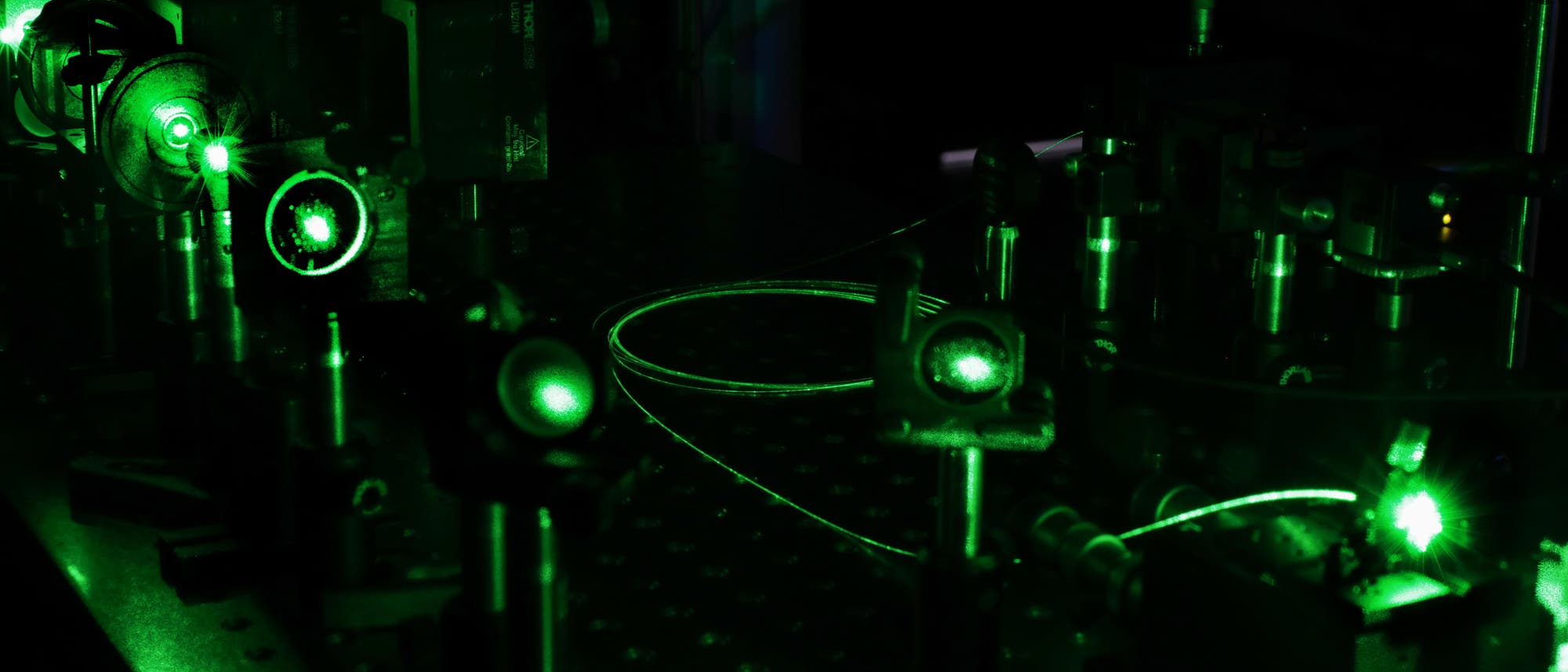

In einem klassischen Testfall für KI-Anwendungen soll das System entscheiden, ob auf einem Bild ein Hund oder eine Katze dargestellt ist. Der experimentelle Aufbau der Lausanner Forschergruppe ist recht überschaubar: Ein Laser beleuchtet einen passiven Bildschirm, der aus dem eingestrahlten Licht auf 600 mal 600 Pixeln dasjenige Bild erzeugt, das letztendlich klassifiziert werden soll. Anstatt, wie sonst im maschinellen Lernen üblich, jedes dieser Pixel einzeln in ein tiefes neuronales Netz zu leiten, bündelt eine Linse das gesamte Bild und koppelt es in die Glasfaser ein. In deren Inneren durchmischen sich die verschiedenen Bereiche des Bildes. Am anderen Ende wird das austretende Licht von einer Kamera erfasst.

Erst das Bild dieser Kamera wird dann in ein herkömmliches, aber sehr einfaches neuronales Netz gespeist, bei dem jeder einzelne Bildpixel durch sein eigenes Neuron repräsentiert ist. Jedes dieser Neurone wiederum ist mit den beiden Ausgabeneuronen »Hund« und »Katze« verbunden. Beim Training bekommt das Netz die von der Glasfaser veränderten Bilder gezeigt und lernt zu erkennen, welches ursprünglich einen Hund zeigte und welches eine Katze. Dazu passt es die Stärke der Verbindungen zwischen den Pixelneuronen und den Ausgabeneuronen so lange an, bis bei einem Hundebild das »Hund«-Neuron aktiviert wird und beim Bild einer Katze das Neuron »Katze«.

Würde man diesem simplen Netz die Hunde- und Katzenbilder einfach so, also unverarbeitet zum Training geben, hätte es keine Chance, den Unterschied zwischen den Tieren zu erlernen. Darum werden in herkömmlichen neuronalen Netzen zwischen den Eingangspixeln des Originalbildes und den Outputneuronen eine Vielzahl von Zwischenschichten mit Neuronen eingefügt. Daraus ergeben sich jene viele Millionen Parameter, die während des Trainings optimiert und in der späteren Anwendung auch alle durchlaufen werden müssen. Im neuen Modell übernimmt dagegen die Faser die Rolle dieser tiefen Schichten. »So benötigen wir nur ungefähr ein Hundertstel der Energie eines herkömmlichen neuronalen Netzes«, sagt Moser. »Allerdings sind wir bei der Verlässlichkeit der Klassifizierung noch um ein paar Prozent schlechter. Das klingt zwar nicht nach viel, ist aber ein Problem, das wir noch lösen müssen.«

Nichtlineare Effekte machen es möglich

Doch was geschieht mit dem Bild, während es durch die Faser läuft? Und wie kommt es, dass mit diesem doch recht simplen Trick die Millionen in einem aufwändigen Trainingsprozess optimierten Parameter eines neuronalen Netzes mehr oder weniger ersetzt werden können? Die Antwort sind nichtlineare Effekte. Sie sind auch bei den herkömmlichen neuronalen Netzen eine unverzichtbare Zutat. Nichtlinear ist im Grunde alles, was sich mathematisch betrachtet nicht durch eine Gerade darstellen lässt, also über eine Addition oder eine einfache Multiplikation mit einem konstanten Wert hinausgeht. Bei den künstlichen neuronalen Netzen tauchen nichtlineare Funktionen als eine Art Wächter auf, der in jedem einzelnen Neuron darüber entscheidet, ob die einlaufenden Signale an die nachfolgenden Knoten weitergereicht werden oder nicht. Nichtlineare »Aktivierungsfunktionen« sorgen hier dafür, dass die Ausgabe des Neurons nicht einfach proportional zu den Eingangssignalen ist, sondern bestimmte hohe Werte annimmt, selbst wenn die Schwelle zur Aktivierung nur leicht überschritten wird.

»Diese nichtlinearen Effekte sind entscheidend dafür, dass ein Netz lernen kann«, erklärt Moser. Auf optischen Chips sind sie aber in der Regel nur schwer nachzubilden. »Um so etwas in der Optik zu erzeugen, braucht man normalerweise sehr hohe Energien.« Da seine Gruppe das Licht aber gewissermaßen in die Glasfaser einsperrt, konnten sie die Effekte dort mit geringer Lichtintensität und damit auch mit geringen Energieverlusten erzielen. »Die Faser vermischt etwa jeden halben Millimeter vollständig die Informationen der Pixel«, sagt Moser. »Das ist vergleichbar mit dem Vorgang in einer einzigen Schicht eines tiefen neuronalen Netzes.« Mit fünf Meter Länge entspricht der aktuelle Aufbau so gesehen einem extrem tiefen Netzwerk.

Warum sich das von der Kamera am Ausgang der Faser eingefangene Ergebnis dann so einfach und mit einer einzigen weiteren neuronalen Schicht klassifizieren lässt, darüber rätseln die Forscher selbst noch. Jedenfalls gibt es Hinweise darauf, dass die Transformation noch nicht optimal ist. So hängt die Performance etwa von der genauen Form der Glasfaser ab. Sie ändert sich also, wenn sie zufällig verbogen oder anders aufgewickelt wird. Das bietet zwar die Möglichkeit, durch Ausprobieren weiter zu optimieren, gleichzeitig stellt diese Instabilität aber auch ein Problem dar. »Falls daraus jemals ein kommerzielles Produkt entstehen soll, muss das System stabil genug sein, um auch noch Monate und Jahre nach dem Training zuverlässige Ergebnisse zu liefern«, sagt Moser. Die derzeit noch lose Glasfaser müsste also fix in einen Chip integriert werden. Moser zufolge ist es heute schon möglich, einen ein Meter langen Lichtleiter in die Oberfläche eines Siliziumchips zu schreiben - und zwar in Form einer nur einen Quadratzentimeter großen Spirale.

Auch »herkömmlichere« optische Chips machen Fortschritte

»Optisches Rechnen ist besonders vielversprechend, wenn man es integriert auf Chips macht und dabei auf Elemente setzt, die man bereits gut im Griff hat«, sagt auch Cornelia Denz, die am Institut für Angewandte Physik der Universität Münster die Arbeitsgruppe für Nichtlineare Photonik leitet und letztes Jahr einen Übersichtsartikel in »Nature« zum Thema optisches Rechnen und künstliche Intelligenz mitverfasst hat. Solche auf Siliziumchips integrierten Systeme seien schon sehr weit fortgeschritten und werden zum Teil mit den gleichen Methoden hergestellt, die auch bei der Produktion herkömmlicher Elektronikchips zum Einsatz kommen - nur dass an Stelle von Transistoren eben Lichtleiter, Strahlteiler und andere optische Elemente in das Silizium geschrieben werden. So ließen sich die Vorteile des optischen Rechnens wie geringe Verluste, hohe Taktraten und die Möglichkeit zur parallelen Datenverarbeitung auf viel versprechende Weise zusammenpacken. »Deshalb ist anzunehmen, dass das bald auch in kommerzielle Produkte übergeht«, sagt Denz. »In den nächsten fünf bis zehn Jahren wird man davon wohl mehr hören. Die aktuellen Start-ups zeigen ja auch, dass das geht.«

Besonders weit fortgeschritten wirken etwa die Chips der beiden US-amerikanischen Start-ups Lightmatter und Lightelligence. Sie basieren auf ein und derselben wissenschaftlichen Arbeit, die 2017 von Forschern des Massachusetts Institute of Technology veröffentlicht wurde. Die beiden Hauptautoren sind nun Konkurrenten in einem spannenden Wettlauf um die neue Technologie. Rein finanziell betrachtet ist Lightmatter mit einer zusätzlichen Finanzspritze von 80 Millionen Dollar unter anderem von GV (früher Google Ventures) und Hewlett Packard 2021 in Führung gegangen. Doch auch Mitbewerber Lightelligence kann auf Mittel von insgesamt 100 Millionen Dollar verweisen. Eigenen Angaben zufolge stehen beide Start-ups unmittelbar davor, ihr jeweiliges Produkt auf den Markt zu bringen.

Im Vergleich zu SOLO orientieren sich Lightelligence und Lightmatter bei der Architektur ihres optischen Chips relativ nahe an den elektronischen Vorbildern, nur dass sie so genannte Mach-Zehnder-Interferometer als elementare Schaltelemente verwenden. Diese optischen Bauelemente spalten einen Lichtstrahl an ihrem Eingang zunächst in zwei Teile auf und führen sie am Ausgang wieder zusammen. Da sich die Geschwindigkeit, mit der sich das Licht entlang der beiden unterschiedlichen Wege ausbreitet, gezielt verändern lässt, kommt es bei der Wiedervereinigung der Strahlen zu einer Verzögerung. So können die Positionen von Wellenbergen und Wellentälern gegeneinander verschoben werden, wodurch sie bei der darauf folgenden Überlagerung entweder konstruktiv oder destruktiv interferieren. Das Bauteil ist also im Wesentlichen ein Modulator, der die Intensität eines Lichtstrahls verändert.

»Mit einem Netzwerk aus Mach-Zehnder-Interferometern lässt sich im Grunde jede beliebige mathematische Operation realisieren«, erklärt Rolf Drechsler, der den Forschungsbereich Cyber-Physical Systems am Deutschen Forschungszentrum für Künstliche Intelligenz und die Arbeitsgruppe für Rechnerarchitektur an der Universität Bremen leitet. In den vergangenen Jahren hat der Forscher gemeinsam mit seinem Team Anleitungen entwickelt, wie man optische Komponenten zu unterschiedlichsten Zwecken miteinander verschalten kann. Dabei haben sie auf die winzigen Interferometer gesetzt, weil die nach momentanem Stand der Technik am besten funktionieren und somit am vielversprechendsten für zukünftige Anwendungen sind. »Grundsätzlich wäre es sogar möglich, einen voll funktionsfähigen, optischen Computer herzustellen«, sagt Drechsler. Vieles ließe sich aber noch nicht in der gewünschten Robustheit und Qualität technisch umsetzen. Zudem muss eine technische Anwendung auch kompakt und kostengünstig sein, um sie kommerziell nutzen zu können.

Den endgültigen Beweis, dass sich die Optik zumindest in speziellen KI-Anwendungen gegen die über Jahrzehnte hinweg optimierte Siliziumelektronik durchsetzen kann, müssen auch die aktuellen Start-ups erst noch erbringen. Doch die Zeit scheint reif zu sein, der künstlichen Intelligenz mit ein bisschen Optik neuen Schwung zu verleihen.

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.