Teilchen: »Künstliche Intelligenz« sucht nach neuer Physik

Als im Juli 2012 am Europäischen Kernforschungszentrum CERN endlich der Nachweis des Higgs-Teilchens bekannt gegeben werden konnte, schien der Triumph für das Standardmodell der Elementarteilchen komplett. 1964 war das Teilchen in das Modell eingeführt worden, um das Verhalten der Materie auf subatomarer Ebene besser erklären zu können. Sein zugehöriges Higgs-Feld verleiht demnach den anderen Elementarteilchen ihre Masse. Der Teilchenbeschleuniger LHC, in dem pro Sekunde Milliarden Protonen zur Kollision gebracht und die dabei neu entstehenden Teilchen untersucht werden, hatte mit dem Nachweis eine große Hoffnung der beteiligten Forscher erfüllt.

Das Standardmodell der Elementarteilchen ist nicht erst seit dieser Entdeckung einer der wichtigsten Erfolge der theoretischen Physik. Aber es kann nicht alle Fragen beantworten. So fehlt darin eine Beschreibung der Gravitation. Außerdem kann es nicht zu einer Erhellung des Ursprungs und des Wesens der Dunklen Materie beitragen. Genauso wenig kann es erklären, wie es zum ungleichen Verhältnis von Antimaterie und Materie im Universum kommt. Und auch zu Masse und weiteren Eigenschaften von Neutrinos fehlen in diesem Modell Informationen.

Diverse Kandidaten konkurrieren darum, das Standardmodell zu erweitern, unter anderem Modelle, die mit so genannten Supersymmetrien oder Stringtheorien arbeiten. Um die Grenzen des Standardmodells zu vermessen und neue Hypothesen zu testen, werden Teilchenbeschleuniger wie der LHC in ihrer Leistungsfähigkeit weiter ausgebaut. Dabei entstehen immer größere und komplexere Datensätze.

Lernende Maschinen werden kreativ

Doch schon heute stoßen die Physiker bei der Analyse der Teilchenkollisionen an Grenzen. Alle entstehenden Daten zu sichern, um sie anschließend zu analysieren, ist unmöglich. Stattdessen kommen Filter zum Einsatz, die in Bruchteilen einer Sekunde entscheiden, welche Messungen zu speichern sich überhaupt lohnt. Um die riesigen Datenmengen zu bewältigen, setzen die Teilchenphysiker auch »künstliche Intelligenz« ein. Unter dieses Schlagwort fallen unter anderem Verfahren des maschinellen Lernens (englisch: machine learning). Diese sind in der Lage, große Mengen komplexer Daten extrem schnell automatisch nach bestimmten Mustern zu durchforsten.

»Im Unterschied zu traditionellen Computeralgorithmen, die wir für eine spezifische Analyse entwickeln, entwerfen wir ›Machine Learning‹-Algorithmen so, dass sie selbst herausfinden, wie man verschiedene Analysen durchführt, was uns potenziell unzählige Stunden an Design- und Analyseaufwand spart«, erklärt der Teilchenphysiker Alexander Radovic vom College of William & Mary im US-Bundesstaat Virginia im »Symmetry Magazine«. Eine Gruppe von Forschern um Radovic hat aktuelle Anwendungen und Zukunftsperspektiven des maschinellen Lernens in der Hochenergie- und Teilchenphysik in einem kürzlich in »Nature« veröffentlichten Papier zusammengefasst.

Ein einfaches Beispiel für maschinelles Lernen ist Software, die durch eine große Menge an Trainingsdaten aus Katzenfotos lernt, welche Merkmale eine Katze ausmachen und wie sich Fotos von Katzen am sichersten unter anderen Fotos identifizieren lassen. Statt für die Suche nach Katzen in Fotos verwenden die Teilchenphysiker diese Verfahren, um Higgs-Bosonen, Quarks, Neutrinos und Hinweise auf bisher unbekannte Teilchen in den Messdaten zu entdecken. Sie werden außerdem eingesetzt, um die Qualität der Detektoren zu prüfen, Daten effizienter zu speichern oder Experimente zu simulieren.

»Man hätte das Higgs zwar auch ohne die Hilfe von maschinellem Lernen gefunden, es hätte aber etwas länger gedauert«Markus Klute

»Im Grunde wird maschinelles Lernen schon seit 30 Jahren in der Teilchenphysik benutzt«, sagt Markus Klute vom Massachusetts Institute of Technology (MIT). »Das wurde nur früher nicht so genannt.« Der Deutsche ist am CMS, einem der vier großen Detektoren des LHC, für die Computersysteme zuständig. Er war auch am Nachweis des Higgs-Bosons beteiligt. »Man hätte das Higgs zwar auch ohne die Hilfe von maschinellem Lernen gefunden«, sagt Klute. »Es hätte aber etwas länger gedauert.«

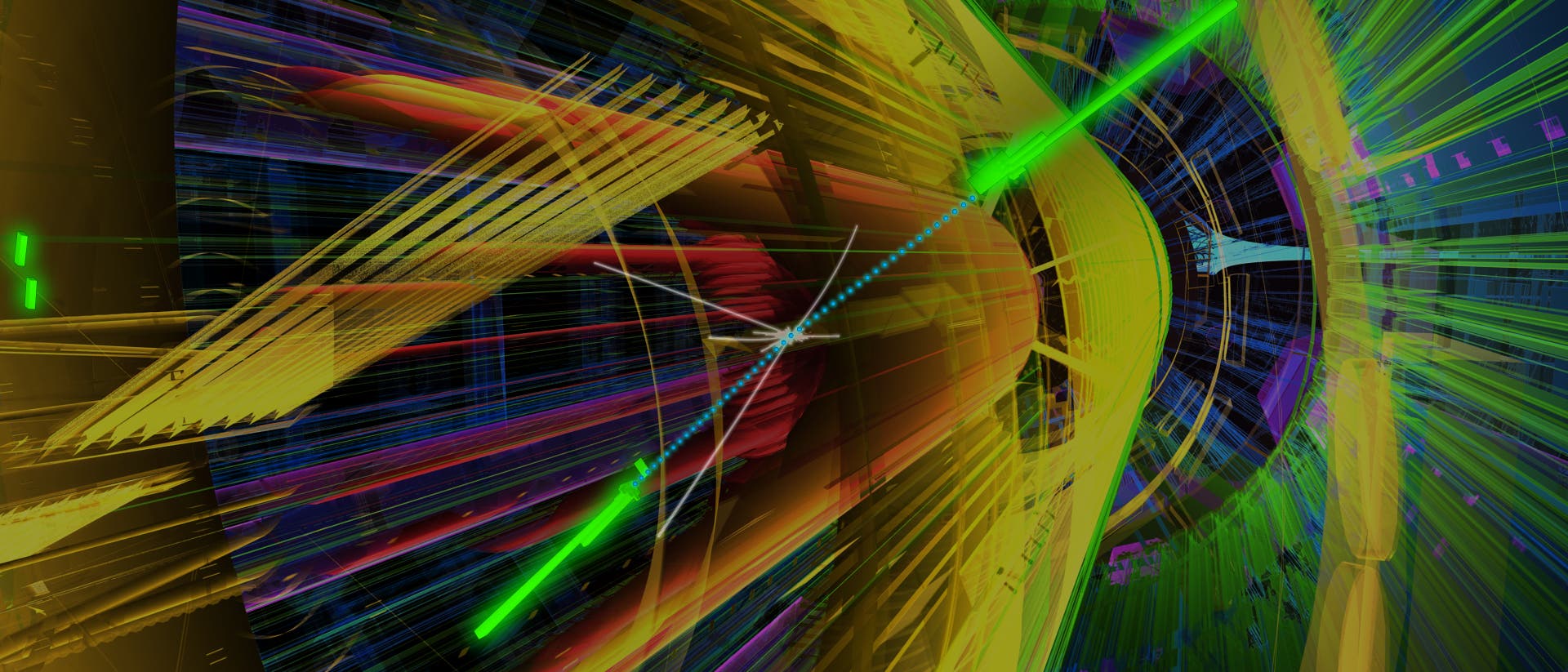

Wenn in der 27 Kilometer langen, runden Röhre des LHC die nahezu auf Lichtgeschwindigkeit beschleunigten Protonen in einem der vier Detektoren aufeinanderprallen, wird die in den Teilchen gespeicherte Energie auf äußerst wenig Raum und in extrem kurzer Zeit in neue Partikel umgewandelt. Ein Teil von ihnen trifft auf dem Weg nach außen auf die Detektoren, die die Röhre umschließen. Dann beginnt die Fährtenleserei. Aus der Kombination der Signale, die die im Zwiebelschalenprinzip gebauten Detektoren aufgezeichnet haben, gilt es, die Ereignisse der Kollisionen zu rekonstruieren.

Sieht man von Raumfahrtmissionen ab, handelt es sich wohl um das aufwändigste Experiment, das die Menschheit bislang konzipiert hat. Am LHC in Genf werden in kilometerlangen unterirdischen Anlagen winzige Teilchen auf enorme Geschwindigkeiten beschleunigt, um sie dann zerschellen zu lassen. In den Trümmern fahndeten tausende Wissenschaftler nach den Grundbausteinen unserer Materie.

Die Entdeckung des Higgs-Teilchens hat zwar Probleme gelöst, aber gleichzeitig weitere Fragen aufgeworfen. Beispielsweise ist das Teilchen leichter als erwartet. Ein bisher nicht entdecktes Partnerteilchen könnte dafür verantwortlich sein. Es bleiben also genügend Rätsel, die in zukünftigen, noch leistungsfähigeren Teilchenbeschleunigeranlagen erforscht werden können.

Wegen der zu Grunde liegenden quantenmechanischen Vorgänge haben es die Forscher dabei mit Prozessen zu tun, für die mehrere Variablen gleichzeitig statistisch untersucht werden müssen. Wichtige Variablen können etwa der Impuls und die Energie von Teilchen senkrecht zur Strahlrichtung, ihre elektrische Ladung sowie die Lage und Form der Spuren sein, welche die Teilchen im Detektor hinterlassen. Dabei kommen so genannte multivariate Analysen zum Einsatz. Teilchenphysiker verwenden traditionell beispielsweise so genannte Cuts, Filter, die alle Signale verwerfen, die für bestimmte Variablen und deren Kombination die vorgegebenen Werte über- oder unterschreiten.

Schon vor dem Speichern werden Daten aussortiert

Jedes Detektorsegment wird auf interessante Signale geprüft, die Ergebnisse laufen in einer globalen Entscheidungseinheit zusammen. Die Gesamtheit dieses Ereignisfilters bezeichnet man als »hardware trigger«. Dieser bestimmt, welche Daten zunächst behalten und welche verworfen werden. Er ist damit die erste Stufe bei der Datenreduktion am LHC. Anschließend wandern die Rohdaten der als interessant eingestuften Ereignisse zu einer Serverfarm, wo die Details der Messungen zu einem Gesamtbild des Ereignisses zusammengefügt werden. Dabei findet eine Kaskade von Analysen statt, während der weitere Daten ausgesiebt werden. Dieser Prozess nennt sich »software trigger«.

Dieses gesamte Geschehen läuft in »Pseudo«-Echtzeit ab, von der Kollision bis zur Entscheidung »Behalten/Verwerfen« vergehen nur einige hundert Millisekunden. Von den Milliarden Protonenkollisionen pro Sekunde bleiben ein paar hundert pro Sekunde übrig, die dauerhaft gespeichert und von den Forschern genauer unter die Lupe genommen werden. Beim LHCb, einem Detektor, der Aufschluss darüber geben könnte, warum es im Universum so viel mehr Materie als Antimaterie gibt, treffen Verfahren des maschinellen Lernens mindestens 70 Prozent dieser Auswahlentscheidungen, sagt Mike Williams vom MIT, der am LHCb forscht, gegenüber dem »Symmetry Magazine«. Er war ebenfalls an dem aktuellen »Nature«-Papier beteiligt.

Zu den seit Langem am LHC verwendeten Machine-Learning-Verfahren gehören so genannte Boosted Decision Trees (BDTs), Entscheidungsbäume, die mit Trainingsdaten gefüttert lernen, wie sich die vielen möglichen Ereignisse rund um die Protonenkollisionen eindeutig unterscheiden und bestimmten Prozessen zuordnen lassen. Beim Nachweis des Higgs am CMS-Detektor halfen BDTs einen Prozess genauer zu analysieren, bei dem ein Higgs zu zwei Photonen zerfällt. Durch den Einsatz von maschinellem Lernen stieg die Empfindlichkeit der Analyse so stark, als wären 50 Prozent mehr Daten erfasst und untersucht worden.

KI ist gut darin, Daten zu klassifizieren

Schon lange spielen außerdem »flache« künstliche neuronale Netze bei den Datenanalysen in der Teilchenphysik eine Rolle. Diese Softwarestrukturen bestehen aus Schichten miteinander vernetzter künstlicher Neuronen. Sie sind in gewisser Weise mit den Strukturen vergleichbar, die auch im menschlichen Gehirn fürs Lernen verantwortlich sind. Die künstlichen neuronalen Netze »erlernen« aus Trainingsdaten eine abstrakte mathematische Funktion, die dann unbekannte Daten sehr schnell und mit hoher Sicherheit klassifizieren kann.

Das Training basiert auf großen Mengen »gelabelter« Daten, also von Menschen annotierter Daten, die aus Simulationen des Standardmodells der Elementarteilchen oder anderen theoretischen Konzepte stammen, auch solchen mit »neuer Physik«. »Gelabelt« nennt man in diesem Zusammenhang Daten, für die man die physikalischen Details ihrer Entstehung kennt. Wenn man in Simulationen bestimmte Experimente im Computer nachstellt, gibt man diese Details vor und kennt sie so automatisch. Es gibt aber auch hybride Trainingsdatensätze, die aus echten Messungen beispielsweise für das Rauschen des Untergrunds und simulierten Daten zusammengesetzt werden, oder Trainingsdaten, die komplett aus Messungen stammen.

In den letzten Jahren haben im maschinellen Lernen Anwendungen von »Deep Learning« zu großen Fortschritten geführt, beispielsweise in Bereichen wie Gesichts-, Sprach- und Objekterkennung. »Deep Learning« basiert auf so genannten tiefen künstlichen neuronalen Netzen. Wo flache Netze nur eine oder höchstens wenige Schichten von Neuronen verbinden, können es bei tiefen Netzen tausende Schichten sein. Dadurch erweitert sich deren Leistungsfähigkeit enorm. »Noch um das Jahr 2012 gab es in jedem Meeting zu dem Thema Diskussionen um die Akzeptanz dieser Methoden«, sagt Markus Klute. »Heute hat die Community kapiert, dass das die Zukunft ist.« Klute glaubt, dass bei der Datenanalyse in der Teilchenphysik durch Deep Learning eine »langsame« Revolution im Gange ist.

Tiefe neuronale Netze finden Teilchen besser als klassische Verfahren

Während bei den bisherigen KI-Verfahren in der Teilchenphysik viele Vorgaben noch von menschlichen Experten quasi von Hand eingebracht werden mussten, suchen sich Deep-Learning-Verfahren weitgehend eigenständig die passenden Eigenschaften für die Analyse der Daten zusammen. So ist die Gefahr geringer, dass wichtige Informationen übersehen werden. 2014 konnten Forscher der University of California in Irvine einen Durchbruch erzielen. Sie konnten zeigen, dass diese Verfahren BDTs und flachen künstlichen neuronalen Netzwerken bei der Suche nach unbekannten Teilchen überlegen sind. Dazu verwendeten sie in zwei Experimenten simulierte Daten zu exotischen Higgs-Teilchen und supersymmetrischen Teilchen. Deep Learning ist gerade bei den künftigen, noch größeren Datenmengen potenziell viel schneller als die älteren KI-Methoden, bei denen sich eine gewisse Sättigung in der Leistungsfähigkeit eingestellt hat. Die Verfahren lassen sich auf Grund ihrer informatischen Struktur wesentlich einfacher parallelisiert auf Hochleistungsrechnern ausführen, die ihre Geschwindigkeit aus der Verwendung unzähliger Grafikprozessoren ziehen.

Auch Sascha Caron von der Radboud-Universität im niederländischen Nimwegen spricht von einer »Zeitenwende« in der Teilchenphysik durch Deep Learning. Der Deutsche forscht unter anderem am LHC-Detektor ATLAS. Gerade beim Aufstöbern von Besonderheiten in den Messdaten könne die Methode große Fortschritte bringen. »Bei der Suche nach neuer Physik werden datengetriebene Ansätze eine zentrale Rolle spielen«, sagt Caron. Bei Konzepten wie der Supersymmetrie sei nicht klar, wie die gesuchten Teilchen eigentlich aussehen. So genannte unüberwachte Lernverfahren könnten sogar helfen, statistische Auffälligkeiten zu finden, nach denen gar nicht gezielt gesucht wurde. »Die Art, wie wir Teilchenphysik betreiben, wird sich durch maschinelles Lernen grundlegend verändern«, sagt Caron, der auch außerhalb von Beschleunigern in astronomischen Messdaten nach interessanten Partikeln sucht.

»Wir konnten unser Experiment damit auf eine Art und Weise verbessern, die sonst nur durch die Erhebung von 30 Prozent mehr Daten erreicht werden könnte«Alexander Radovic

Die Fortschritte im Bereich Deep Learning werden durch die kommerziellen Anwendungen der Technologieriesen und die Datenexplosion, die sie in den letzten zwei Jahrzehnten ausgelöst haben, angetrieben. So verwendet das Neutrino-Experiment NOvA des Fermilab in den USA ein neuronales Netzwerk, das von der Architektur des Bilderkennungsalgorithmus GoogleNet inspiriert ist. »Wir konnten unser Experiment damit auf eine Art und Weise verbessern, die sonst nur durch die Erhebung von 30 Prozent mehr Daten erreicht werden könnte«, sagt Alexander Radovic, der an NOvA forscht.

Überhaupt lassen sich viele Probleme in der Teilchenphysik mit Deep-Learning-Verfahren zur Bilderkennung angehen. Ein Bereich, in dem dieser Ansatz sehr nützlich sein könnte, ist die Analyse von so genannten Jets, die am LHC in großer Zahl produziert werden. Jets sind dünne Strahlen von Partikeln, deren einzelne Spuren eine große Herausforderung bei der Trennung darstellen. Die automatische Bilderkennung kann helfen, Merkmale in solchen Jets geschickter zu identifizieren.

Deep Learning braucht Deep Thinking

Und auch bei der Erzeugung der in der Teilchenphysik so wichtigen simulierten Datensätze können tiefe neuronale Netze in Form so genannter »generative adversarial networks« (GANs) einen enormen Fortschritt bringen. Bei einem GAN stehen zwei neuronale Netze miteinander im Wettstreit. Das eine, der Generator, erzeugt simulierte Daten für ein bestimmtes Szenario, während das zweite, der Widersacher, prüft, wie gut die simulierten Daten solchen aus Messungen ähneln. Lassen sich die simulierten Daten von den gemessenen unterscheiden, wird der Generator bestraft und passt sein Konzept neu an. Auf diese Weise schwingen sich derartige Systeme zu immer besseren Leistungen auf.

Im Moment vermischen sich »Data Science« und Teilchenphysik immer stärker. Sascha Caron war Anfang 2018 an der Gründung von »Dark Machines« beteiligt, einer Gruppe von mehr als 100 Physikern und Datenexperten, die sich besonders für die Geheimnisse der Dunklen Materie interessieren und eine virtuelle Kooperationsplattform bilden. Und Markus Klute hat jetzt seinen ersten Master-Studenten, der aus der Informatik kommt und nicht aus der Physik. Doch diese Vermischung birgt auch ein Risiko: »Zu Deep Learning gehört auch ›Deep Thinking‹«, sagt Klute. »Man muss wissen, was man tut. Es ist sehr wichtig, dass junge Studenten auch in Zukunft verstehen, dass echte Physik hinter den Daten steckt!«

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.