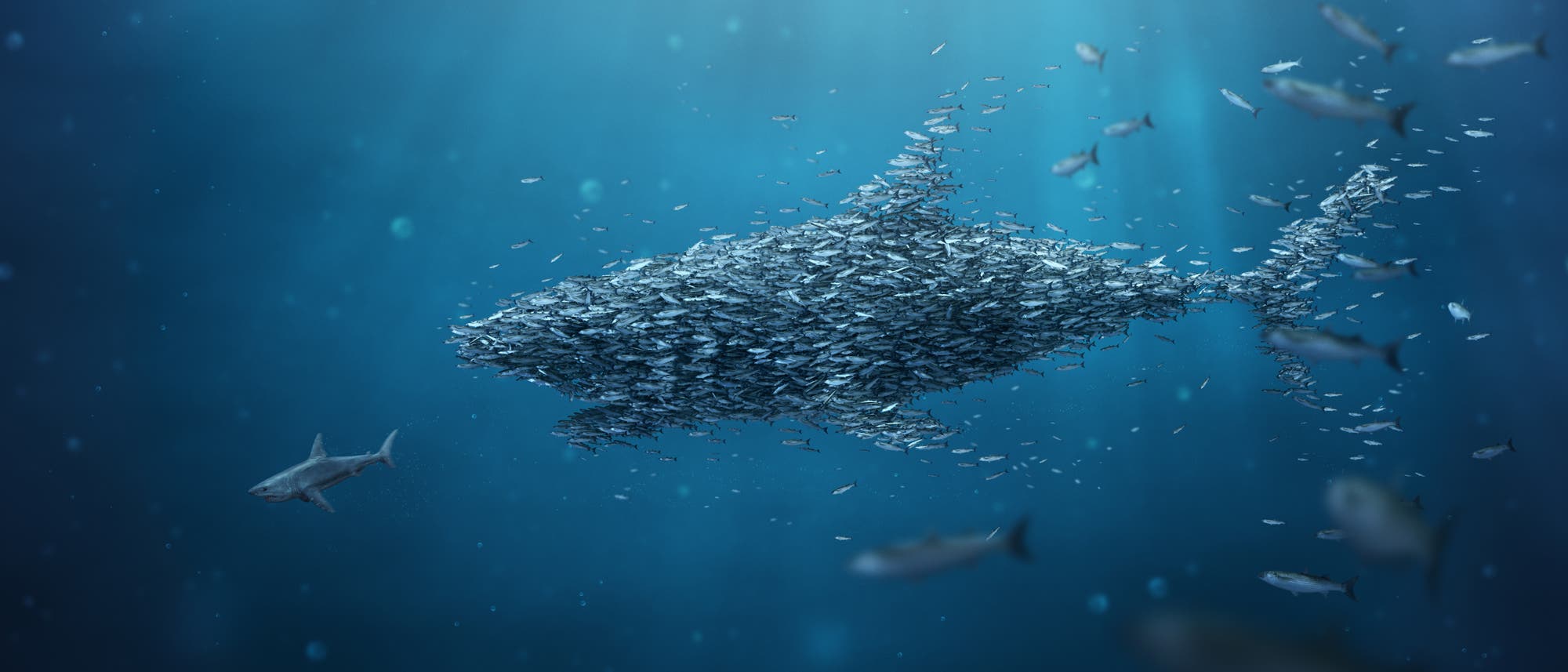

Maschinelles Lernen: Quantennetzwerke zeigen Schwarmintelligenz

Vögel und Fische tun es. Ebenso Bienen, Ameisen und Termiten. Sie bilden Schwärme und nutzen aus, dass sie in der Gruppe stärker, intelligenter und schneller sind. Aber lässt sich eine solche Schwarmintelligenz auch auf Quantennetzwerke übertragen? Das hat sich ein Team um Tanjung Krisnanda von der Nanyang Technological University in Singapur gefragt und herausgefunden: Ja, mehrere schlecht trainierte Quantennetzwerke sind zusammen leistungsfähiger als ein einzelnes gut trainiertes. Ihre Ergebnisse präsentiert es in der aktuellen Ausgabe der Fachzeitschrift »Physical Review Applied«.

Unter Schwarmintelligenz versteht man in den Sozialwissenschaften, dass eine von mehreren Menschen kollektiv getroffene Entscheidung oder ein gemeinsam erreichtes Ergebnis der Leistung eines einzelnen Experten überlegen ist. Das Prinzip wird angewendet bei Wirtschaftsprognosen, in der Entscheidungsfindung der öffentlichen Politik, der medizinischen Diagnostik und der wissenschaftlichen Beratung. Daran angelehnt ist das so genannte »ensemble learning« in der klassischen Informatik. Dabei geht es darum, dass eine Kombination von verschiedenen Lernalgorithmen besser sein kann als ein Algorithmus allein.

Wenn nun künstliche neuronale Netze Quantensysteme als Knotenpunkte enthalten, werden sie als neuronale Quantennetzwerke bezeichnet. In diesem Fall verwendeten die Forscher ein spezielles Quanten-Reservoir-Netz (QRN), das die nichtlineare Natur quantenmechanischer Wechselwirkungen ausnutzt. Jede Eingabe beeinflusst die nächste Reaktion.

Die Eingabe besteht aus zwei Qubits, die für eine gewisse Zeit mit dem QRN interagieren, so dass die Informationen über die Eingabe in den Zustand des QRN einfließen. Indem sie die QRN-Knoten auslesen und das Ergebnis mit Hilfe einer trainierten Ausgabeschicht verarbeiten, sind die Wissenschaftler in der Lage, den Eingangszustand vollständig zu rekonstruieren (Tomografie) oder zu erkennen, ob die Eingangsqubits verschränkt sind. »Unter der Annahme, dass die Summe der Trainingsdurchläufe in beiden Fällen gleich ist, zeigen wir, dass das kollektive Ergebnis des Schwarms die Eingangszustände besser schätzt als der Experte«, stellen die Autoren fest. Diese Schlussfolgerung gelte auch für die Aufgabe der Verschränkungserkennung.

Um Experten und Kollektiv vergleichen zu können, hatten sich die Wissenschaftler selbst auferlegt, dass die Anzahl der Trainingsdurchläufe in Summe für beide Systeme identisch sein muss. Lockere man jedoch diese Einschränkung, so schreiben sie, biete die Vergrößerung des Schwarms sogar die Möglichkeit, die Fehlerrate beliebig niedrig werden zu lassen. Das wiederum ist eine entscheidende Voraussetzung dafür, maschinelles Lernen in realen Anwendungen zuverlässig einsetzen zu können. »Wir gehen davon aus, dass sich unsere Ergebnisse auf viele typische Quantenarchitekturen und Aufgaben des maschinellen Lernens mit Quanten verallgemeinern lassen.«

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.