Ihre Beiträge sind uns willkommen! Schreiben Sie uns Ihre Fragen und Anregungen, Ihre Kritik oder Zustimmung. Wir veröffentlichen hier laufend Ihre aktuellen Zuschriften.

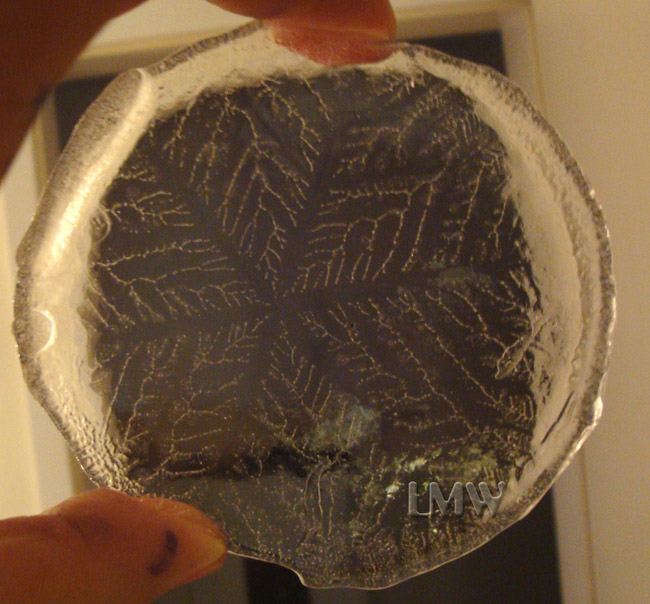

Als SDW-Leser seit über 30 Jahren bin ich einiges an Naturereignissen gewohnt - aber nicht einen so großen Eiskristall (wohl Monokristall?) von einer Größe von rund 80 Millimeter, den ich neulich auf meinem Balkon in einem herumstehenden Wasserglas fand. Bekannt sind mir Eiskristallgrößen zwischen 0,1 und 3 Millimeter.

Da auch wissenschaftlich beschlagene Leute in meinem Bekanntenkreis so etwas noch nie gesehen haben bzw. dieses Phänomen auch nicht erklären können, wende ich mich an Sie bzw. bitte ich Sie um eine Möglichkeit, eine Antwort zu finden, z.B. durch Prof. H. J. Schlichting?

Ich habe das Objekt (siehe Bilder) einmal gegen Licht und einmal gegen einen dunklen Hintergrund fotografiert.

Fotos: Lutz-Michael Weiß

Handelt es sich um einen Monokristall? Kommt so etwas oft vor bzw. ist das leicht in einer solchen Größe reproduzierbar? Sind die blattähnlichen ausgerichteten Adern oder Bläschen Lufteinschlüsse (in der dunklen Scheibe)?

Oder ist das alles kein Thema, sind beobachtete Größe und Form hinreichend bekannt, und kann ein solches Objekt auch schon mal einen Meter im Durchmesser haben?

Stellungnahme der Redaktion

Wir haben Herrn Prof. Schlichting um eine Antwort gebeten. Hier ist sie:

Vermutlich ist der Kristall von der Mitte her zum Rand gewachsen. Denn es wäre unwahrscheinlich, dass gerade sechs Eisbäumchen vom Rande her symmetrisch zur Mitte wachsen und sich dort treffen. Aufgrund der Struktur des Wassermoleküls bildet sich beim Gefrieren an einem Keim zunächst eine winzige hexagonale Platte, die dann von diesem Startpunkt ausgehend weiter wächst.

Da beim Gefrieren Kristallisationswärme entsteht, wird das weitere Wachstum besonders in der Nähe des bereits erstarrten und gerade erstarrenden Wassers gebremst. Dies gilt weniger für die in den kalten Bereich des Wassers hineinragenden Stellen des Kristalls, also den sechs Ecken.

Wenn keine Störungen vorliegen entwickeln sich daher der hexagonalen Symmetrie folgend Eisnadeln von der bereits bestehenden Eisstruktur weg in Richtung Gefäßrand. An den Seiten dieser Nadeln entstehen (im vorliegenden Fall offenbar weniger durch die hexagonale Grundstruktur bedingt als vielmehr durch Zufall) einzelne Ausstülpungen von Eis, von denen die größten und damit von der Nadel am weitesten entfernten (wieder wegen der anfallenden Kristallisationswärme) bevorzugt sind und als Eiszweige sowohl vom Zentrum als auch von der Eisnadel weg schräg nach außen treiben. Nach dem gleichen Prinzip verzweigen sich diese Zweige und so weiter. Insgesamt entstehen daher zwischen den sechs Eisnadeln baumartige Gebilde.

Bei den Verzweigungen hat sich (durch Verunreinigungen und andere Störungen bedingt) eine exakt hexagonale Struktur gegen die stets vorhandenen zufälligen Tendenzen nicht durchsetzen können. Es sind Fraktale entstanden, wie man sie von vielen Wachstumsprozessen kennt (von elektrolytischer Anlagerung über Einzugsbereiche von Flüssen bis zu realen Bäumen).

Sie sind in ihren Teilen nicht gleich sondern selbstähnlich und daher haben wir es hier nicht mit einem Monokristall zu tun. Denn dieser besteht per definitionem aus einem fehlerfreien Kristallgitter. Das schränkt aber die Schönheit und wohl auch Seltenheit des vorliegenden Exemplars in keiner Weise ein. Denn hier werden Zufall (ähnliche, aber nicht identische Zweige) und Notwendigkeit (die hexagonale Grundstruktur) in ästhetisch ansprechender Weise miteinander verknüpft.

Die blattartigen Strukturen sind demnach nicht auf Lufteinschlüsse zurückzuführen (auch wenn solche vorhanden sein mögen).

Ich selbst habe zwar Eisnadeln von bis zu einem Meter Länge auf einem Teich beobachten können, auch mehrere von einem Zentrum ausgehende, aber bislang keine, die eine so strenge hexagonale Grundstruktur aufwiesen.

Zwei Punkte fallen mir - abseits von der Relevanz der Meldung über Fortschritte beim künstlichem Fleisch - in diesem Artikel auf: 1) Das Argument des Tierleids steht an erster Stelle. Dabei ist es schwer zu erfassen und eine Anwendung emotionaler menschlicher Kategorien ist nicht sachlich. Leidet ein Tier wirklich unter der zur Fleischproduktion dienenden Haltung, wenn vermeidbares Leid wie lange Transporte, zu große Individuendichte etc. unterlassen werden? Das Argument der Sicherung der Welternährung scheint mir dabei das deutlich belastbarere: Die Zahl von einer Milliarde hungernder Menschen und die schwindende Weltanbaufläche sprechen viel klarer und eindeutiger für die Reduktion des Fleischkonsums. 2) Die Haltung der vegetarischen Bevölkerungsminderheit ist lobenswert (ungeachtet der Sachlichkeit ihrer Begründung), doch ihre Zahl wird sich so schnell nicht vervielfachen. Der Fokus sollte mehr der Reduktion des Fleischkonsums im Großteil der Bevölkerung liegen. Dies wäre deutlich effektiver als die Zuspitzung auf die Alternative "Vegetarier oder nicht". Es wird ja auch nicht mehr gefordert, das Auto abzuschaffen, sondern in erster Linie weniger zu fahren.

Grundsätzlich konnte ich dem Artikel einiges abgewinnen, allerdings bin ich über einen sachlichen Fehler gestolpert: "Die Fotosynthese wandelt CO2 in Sauerstoff um, während der aerobe Stoffwechsel das Gegenteil bewirkt." Das stimmt so nicht. Bei der Fotosynthese wird Wasser in Sauerstoff und Wasserstoff gespalten, wobei der Wasserstoff auf das Kohlendioxid übertragen wird (es entsteht Zucker) und der Sauerstoff als giftiges Abfallprodukt übrig bleibt. Bei der Atmung passiert genau das Gegenteil: Dem Zucker wird Wasserstoff entzogen und auf den Sauerstoff übertragen - es entsteht Wasser (kontrollierte Knallgasreaktion). Das Abfallprodukt ist hier neben dem Wasser natürlich Kohlendioxid.

Stellungnahme der Redaktion

Offensichtlich kann man ein und denselben Prozess – der seinerseits wieder eine komplizierte Abfolge chemischer Einzelreaktionen ist – sehr verschieden interpretieren, je nachdem, was man für das erwünschte Ziel der Reaktion und was man für Abfall hält. Peter Wards Interpretation konzentriert sich auf die atmosphärischen Gase Sauerstoff und Kohlendioxid und schweigt daher über die übrigen Beteiligten Glukose und Wasser. Unsereinen (wie alle Tiere) interessiert an dem ganzen aeroben Stoffwechsel vorrangig die Energie, die man daraus gewinnen kann; deswegen fällt es uns ja auch schwer, den Sauerstoff als Abfallprodukt (gar als giftiges) aufzufassen.

Christoph Pöppe, Redaktion

Replik von Wilhelm Richard Baier:

Es geht darum, dass der Sauerstoff eben nicht vom Kohlendioxid kommt, sondern aus der Zerlegung von Wasser. Außerdem ist Sauerstoff ein Zellgift. Daher hat die Anreicherung der Atmosphäre mit Sauerstoff durch Blaualgen die erste ökologische Katastrophe ausgelöst: ein globales Massensterben. Einige Bakterien (vermutlich ähnlich funktionierende Schwefelbakterien) haben es dann gelernt, den Sauerstoff zur Energiegewinnung zu nutzen. Eukaryonten (modernen Zellen) gelang dies nur durch Symbiose mit solchen Bakterien (das sind die heutigen "semiautonomen" Mitochondrien). Der Stoffwechsel der Eukaryonten ist so komplex, dass Sauerstoff jedenfalls ein Problem darstellt. Nur einigen einfacher gestrickten Bakterien ist es gelungen, mit dem Sauerstoff zurecht zu kommen. Daher waren die modernen Zellen auf diese Bakterien angewiesen, um in der neuen Umwelt überleben zu können.

Antwort auf: "... mehr als ein Jahrzehnt können wir bislang nicht ..."

Wir können jedenfalls weit genug in die Zukunft blicken, um zu wissen, dass unsere Energie- und sonstige Resourcenverschwendung zwangsläufig in einen irgendwann nicht mehr funktionsfähigen Zustand führt: Stetig wachsender "Bedarf" kann irgendwann nicht mehr bedient werden, das ist mit allem so (über den Zeitpunkt mögen sich Prognostiker streiten - am Sachverhalt ändert sich nichts).

Um hier wenigstens ein bisschen gegensteuern zu können, ohne den auf die "bad-word-list" gesetzten Begriff "Ökologie" zu benutzen, hat man sich den "Klimaschutz" einfallen lassen.

Natürlich muss man auch CO2-Emissionen herunterfahren, wenn der Verdacht besteht, dass CO2 das Klima beeinflusst - aber letzten Endes ist das nicht das größte ökologische Problem.

Für die Wissenschaft bringt Peter Ward seit den Gaia-Forschungen James Lovelocks nichts Neues. Wäre das Leben auf Selbsttötung angelegt, hätte es in der Tat schon mehrere Gelegenheiten dazu gehabt. Wollte „Medea“ das traurige „You can never win“-Spiel lediglich verlängern und das Leben sadistisch von einer Katastrophe zur nächsten treiben? Können wir aus Computer-Abstürzen schließen, dass die Entwickler ihr System auf Selbstsabotage programmiert haben? Die Umstände auf der Erde waren, wie sie waren, und das Leben hat in verschiedenartiger Form seine Chancen genutzt. Freilich wurden die Karten mehrfach gewaltsam neu gemischt. Doch blieb die langfristige Balance trotz oder vielleicht gerade wegen solcher Einbrüche aufrecht erhalten. Dass die Pflanzen CO2 verbrauchen müssen, ist ihnen ebenso wenig vorzuwerfen wie der Sonne, dass sie mit zunehmendem Alter mehr Wasserstoff verbrauchen muss und dadurch heißer wird. Auch ist fraglich, wieweit der Umfang der Biomasse in Milliarden Tonnen Kohlenstoff tatsächlich Ausschlag gebend ist für ein grundsätzliches, stabiles Funktionieren der Biosphäre zu einem bestimmten Zeitpunkt, so, wie es Peter Ward in seinem Buch „Medea Hypothesis“ auf einer gedanklichen Zeitreise auch für die nächsten 500 Millionen Jahre einräumt (s. Chapter 8, "Predicted Future Trends of Biomass"). Wir Menschen haben uns nun einmal nicht auf den blühenden Mikrobenmatten des Präkambriums entwickelt, die eine sehr viel höhere Biomasse enthielten als alle heutigen Reiche des Lebens (Prokaryoten, Eukaryoten, höhere Organismen). Trotz rückläufiger Biomasse und stagnierender Artenentwicklung hält unser Planet eine Vielzahl an Möglichkeiten, aber auch Gefahren und Handlungsnotwendigkeiten für uns bereit. Die Aufforderung, diese Möglichkeiten zu nutzen, ist der positive Schluss von Wards Buch. Ab hier stimme ich mit dem Autor überein. Gaia alias Medea würde es sicher auch tun.

Ich stimme Ihnen zu, dass Astronomie ein äußerst wichtiges Schulfach wäre, doch zuallererst sollte es auf freiwilliger Basis angeboten werden, was in meiner Schule in Hessen nicht der Fall ist. Ihrem Argument, dass Geographie eine viel höhere Stundenzahl am Ende der Mittelstufe hat, kann ich nicht zustimmen, da im letzten Mittelstufenjahr kein Erdkunde unterrichtet wird. Das Thema Globalisierung fällt in den Politik&Wirtschaft-Unterricht.

Ich denke auch, dass die meisten Schüler überhaupt keine Lust auf Astronomie haben, da dies zwei weitere Stunden in der Woche bedeuten würde. Bei G8 haben die Schüler in Klasse 9 schon 34 oder 35 Wochenstunden, und wenn dann noch zwei Stunden dazu kommen würden, müssten die Schüler, die teilweise erst 14 Jahre alt sind, vier mal Nachmittags in der Schule bleiben. Allerdings würden Astronomielehrer auch noch ein weiteres Fach lehren müssen, da man zur Lehrerausbildung zwei Fächer studieren muss.

Ja, gewiss ist der Formalismus der Quantenfeldtheorie mit den algebraischen Strukturen der relativistischen Transformationsprinzipien verträglich. Es scheinen mir jedoch einige Unschärfen und Missverständnisse im Hinblick auf den Gebrauch des Begriffs von „Kausalität“ sowie den axiomatischen Kanon der Theorien vorzuliegen.

Anzuführen wäre zunächst der rein logische Kausalitätsbegriff, der darauf zielt, dass aus Beobachtungen bzw. wahren Aussagen über einen Teil der Wirklichkeitsstrukturen weitergehende Schlüsse über nicht direkt beobachtete Gegebenheiten gezogen werden können. Diese Ebene von Kausalität ist nicht an die physikalische Zeitordnung gebunden - aus Kenntnis von Gegebenheiten der Gegenwart lassen sich solche der Vergangenheit ebenso wie welche der Zukunft entsprechend einschränken und näher bestimmen. Voraussetzung dafür ist, dass den separierbaren Ereignissen der Wirklichkeit eine implizite Ordnung systematischer wechselseitiger Korrelationsprinzipien zugrundeliegt, die einschlägige Deduktionen ermöglicht.

Davon zu unterscheiden wäre der physikalische Kausalitätsbegriff, der eng mit dem der Zeitordnung verbunden ist und darauf zielt, mit welchen Auswirkungen reale physikalische Veränderungen eines Teils der Wirklichkeit an anderen Stellen verbunden wären, und dieser allgemeinen Auffassung gemäß auch auf den Fall ungerichteter Korrelationsprinzipien ohne absolute Kriterien zur Unterscheidung von Ursache & Wirkung anwendbar wäre. Genauer zu spezifizieren wäre dabei der relativitätstheoretische Kausalitätsbegriff, der auf die strukturelle Einbettung der physikalischen Kausalitätszusammenhänge in Raum & Zeit zielt.

Was den betrifft, scheinen mir unterschiedliche Auffassungen darüber zu bestehen, was nun zu den unveräußerlichen axiomatischen Fundamenten der Relativitätstheorie oder unter die diskutablen Ergänzungsannahmen zu zählen wäre. Aus dem Formalismus der Quantenfeldtheorie ist so wenig wie aus dem der nichtrelativistischen Quantenmechanik zu ersehen, auf welchen Wegen der physikalischen Kausalitätsflüsse durch Raum & Zeit die zu beobachtenden nichtlokalen Korrelationsprinzipien verschränkter Quantensysteme zustandekommen sollten.

Allgemeiner Konsens dürfte darüber bestehen, dass die Relativitätstheorie verlangt, dass sich kein Quantum positiver Energie schneller als mit Lichtgeschwindigkeit ausbreiten kann. Was Informationsflussmöglichkeiten anbelangt, scheint gleichermaßen Einigkeit darüber zu bestehen, dass zumindest auf der Ebene des manifest Beobachtbaren überlichtschnelle Übertragungsvorgänge, die sich etwa für Kommunikationsanwendungen nutzen ließen, auszuschließen wären, aber im Hinblick auf etwaige darunterliegende und aus prinzipiellen Gründen nicht direkt beobachtbare Wirklichkeitsebenen scheiden sich offenbar die Geister, was die Relativitätstheorie nun wirklich zwingend fordert. Dem einen gilt diese bereits als befriedigend erfüllt, wenn nur die Transformationsregeln der Systembeschreibungsparameter das algebraische Kriterium einer gruppentheoretischen Darstellung der Lorentz-Transformationen erfüllen, andere verbinden damit höhere Ansprüche hinsichtlich der Einschränkungen möglicher Wirkungswege.

Wie immerhin durch Anwendung von Logik festzustellen ist, wären im relativistischen Modell überlichtschnell wirkende Kausalitätsvernetzungen zwangsläufig mit Paradoxien der zeitlichen Kausalitätsordnung verbunden, die heikle Fragen nach dem feststehend als Realität Gegebenen aufwerfen würden (vgl. dazu die Ausführungen in meinem vorangegangenen Leserbriefbeitrag zum selben Artikel).

Bei den komplexen Wahrscheinlichkeitsamplituden der Zustandsfunktionen und deren linearen Überlagerungsprinzipien sehe ich indes weit weniger Veranschaulichungs- und Nachvollziehbarkeitsprobleme: Ist es doch schon bei jeder einfachen mechanischen Schwingung so, dass die Energie dabei zwischen zwei Freiheitsgraden pendelt, welche der Auslenkungsamplitude bzw. der zeitlichen Änderung derselben entsprechen (etwas allgemeiner ausgedrückt, meine ich kanonisch verallgemeinerte Orts- und Impulsparameter). Sofern die Schwingung harmonisch ist, ist die Energie von den kanonischen Parametern in quadratischer Form abhängig. Und dass sich bei Überlagerung zweier Schwingungen diese Parameter jeweils separat addieren (Auslenkung zu Auslenkung & Bewegung zu Bewegung, und nicht etwa Geschwindigkeits- zur Positionskoordinate) und diese Summenwerte zu quadrieren sind, um die Gesamtenergiemenge des Vorgangs zu bestimmen, ist logisch einfach nachvollziehbar.

Nun ließe sich die quantenmechanische Beschreibung genausogut in Real- und Imaginärteile aufspalten, um beispielsweise den Realteil einer Zustandsfunktion als verallgemeinerten Ortsparameter und den Imaginärteil als Impulsparameter anzusetzen. Insofern ist es doch völlig natürlich und naheliegend, dass sich schwingende Systeme, als welche die Quantenzustandsfunktionen angesetzt sind, nach dem Muster zweidimensionaler Vektoren addieren und sich das formal elegant durch einen komplexen Phasendrehfaktor repräsentieren läßt. Und wenn die Quantenmechanik mit der klassischen kompatibel sein soll, kann´s gar nicht anders gehen, als dass der Beitrag zur Energie quadratisch von den zuvor separat addierten Beschreibungsparametern abhängt. Der einzige Unterschied zur klassischen Mechanik liegt darin, dass der Energiebeitrag in der Quantentheorie mit einem statistischen Gewichtsfaktor verbunden ist, diesen im Falle einer Messung tatsächlich beobachten zu können. Und dass der statistische Gewichtsfaktor eines Energiebeitrags gleich der Wahrscheinlichkeit des fraglichen energetischen Eigenzustandes sein sollte, ist ebenso unschwer einzusehen - und in umgekehter Richtung somit genauso.

Größere Schwierigkeiten habe ich wiederum damit, mir vorzustellen, wie sich die häufig postulierten physikalischen Feinauflösungsgrenzen von Raum & Zeit mit den fundamentalen Symmetrie- und Transformationsprinzipien der Relativitätstheorie oder mit einer unbegrenzten Extrapolation der Schrödinger-Gleichung auf Systeme größeren Energieinhalts vertragen sollen, geschweige denn mit einer auf ein unendliches Universum. Denn solche Grenzen sollten dadurch leicht zu unterschreiten sein, und universale Eigenzustände für Energiewerte scheint es nicht nur in Fällen von Unendlichkeit ohnehin gar nicht erst zu geben - die sollten nämlich stationär und bis auf einen globalen Phasenfaktor (mit welcher Frequenz im Falle von Unendlichkeit?) zeitlich unveränderlich sein, was aber gemäß allgemeiner Relativitätstheorie für ein Universum mit räumlicher Ausdehnung und Energiedichte nicht drin ist, außer vielleicht im Zustand einer kollabierten Singularität. Auch ein Indiz dafür, dass ein etwaiger universaler Hamilton-Operator unter Einbeziehung der Gravitation wohl wesentlich anders konzipiert sein müsste als einer für kleinere Systeme. Vielleicht kommt man mit der Vereinigung der großen Theorien nicht voran, weil man zu sehr darauf fixiert ist, unbedingt einen Operator konstruieren zu wollen, der eine Spektralzerlegung in energetische Eigenzustände ermöglicht, weil dies die mathematische Handhabung so schön vereinfacht.

Fast wäre mir die jüngste Spektrum aus der Hand gefallen, als ich die Überschrift „Lebensborn statt Todesbote“ las. Der Lebensborn e. V. war im Nationalsozialismus ein Verein unter der Ägide von „Reichsführer-SS“ Heinrich Himmler mit dem Ziel, den „arischen“ Nachwuchs zu fördern. Der Lebensborn e. V. unterhielt zahlreiche Mutter-Kind-Heime, in denen – im Sinne der NS-Rassenideologie – rassisch einwandfreie schwangere Frauen ihr uneheliches Kind zur Welt bringen konnten. Die Väter waren in der Regel ebenfalls „arisch“ reine SS-Angehörige. Außerdem wurden während des Zweiten Weltkrieges blonde und blauäugige Kinder auf Befehl Himmlers aus den besetzten Gebieten in die Lebensborn-Heime verschleppt und zur Adoption in deutsche Familien vermittelt.

Ich habe mich noch bemüht, eine weitere Bedeutung des Wortes Lebensborn zu finden, bin aber in allen Nachschlagewerken immer nur auf die NS-Einrichtung gestoßen. Ich unterstelle demjenigen, der die Überschrift getextet hat, nicht, absichtlich Nazijargon verwendet zu haben. Trotzdem vermisse ich sprachliche Sensibilität. Da „Born“ ein altes deutsches Wort für „Quelle“ ist, liegt die unverfängliche und sogar noch verständlichere sprachliche Alternative doch so nahe: „Lebensquell statt Todesbote“.

Es mag sich dramatisch anhören, dass Grönland rund 150 Gigatonnen Eis pro Jahr verliert, aber Grönland hat rund 2,5 Millionen Gigatonnen Eis. Folglich wird das Abschmelzen noch rund 16 000 Jahre dauern. Dies bestätigt auch eine Kontrollrechnung: Das Meer soll um sieben Meter steigen, wenn Grönlands Eis schmilzt. Doch im Augenblick steigt es um 0,5 Millimeter, also 0,0005 Meter - bis zum Sieben-Meter-Anstieg würde es also 14 000 Jahre dauern. Dummerweise haben wir aber alle 1000 Jahre eine kleine Eiszeit, die das Abschmelzen rückgängig macht. Dank der Panikmache bekommt England aber nun zehn neue Atomkraftwerke. Wer mag solche Studien wohl finanzieren?

Habe die Leserbriefe zum Artikel über Quantenverschränkung & Relativitätstheorie in SdW Bd. 9/09 mal durchgesehen und denke mir, zur Vertiefung der einen oder anderen Verständnisschwierigkeit mein Scherflein beitragen zu können.

Grundsätzlich geht es um Probleme eines konsistenten Vorstellungsbildes dessen, was an der funktionalen Basis an Wirklichkeitsstrukturen gegeben ist, das mit der Logik der formalen Prinzipien sowohl der Quantentheorie als auch der Relativitätstheorie zu vereinbaren wäre. Der Formalismus suggeriert, die quantenmechanischen Zustandsfunktionen wären direkte Repräsentationen konkreter Realitätsgegebenheiten. Im Sinne der Information (über Erwartungswerte und korrelative Vernetzungen der möglichen Messwerte), die in Form der Funktion kodiert ist, bedeuten diese auch tatsächlich Beschreibungen gegebener Strukturen der Realität, doch wäre es naiv, die formale Darstellung mit einer in allen Aspekten orignalgetreuen Abbildung der Wirklichkeit gleichzusetzen. Zwar ist diese unter informationstheoretischen Aspekten zweifellos originalgetreu genug, um damit korrekte Berechnungen anstellen und Vorhersagen treffen zu können, doch speziell der Ansatz einer Funktion mit prinzipiell wohlbestimmten Werten an ebenso wohlbestimmten Punkten in Raum & Zeit mag vielleicht mehr durch die Bedürfnisse des menschlichen Vorstellungsvermögens begründet sein als durch die eigentliche Natur der Sache. Ich würde davon ausgehen, dass die Natur ihre strukturellen Informationen nicht notwendig nach solchen Formprinzipien verkörpert, die sich mit den Mitteln menschlicher Vorstellungsmöglichkeiten, formaler Sprachen und Mathematik einfach beschreiben ließen, und die Zustandsfunktion für nicht mehr nehmen als eine konstruierte formale Kodierung von Information, die für die Statistik des Beobachtbaren von Relevanz ist.

Insbesondere betrifft die fragliche Information die Muster der Korrelation in den möglichen Ergebnissen von Messungen an verschiedenen Punkten in Raum & Zeit. Bereits bei der Repräsentation eines unverschränkten einzelnen Teilchens stellt sich das Problem der Interpretation des Umstandes, dass diesem eine beliebig großräumig ausgedehnte Zustandsfunktion entsprechen kann, die die Wahrscheinlichkeit beschreibt, das Teilchen an verschiedenen Orten vorzufinden, sofern man dort eine einschlägige Messung vornimmt, aber bei gleichzeitigen Messungen an auseinanderliegenden Orten ausgeschlossen ist, das Teilchen mehrfach nachweisen zu können. Im direkt genommenen Bild der formalen Repräsentation würde dies einen instantanen „Kollaps“ der Funktion ohne Beschränkung durch die Lichtgeschwindigkeitsgrenze erfordern, sobald für einen Ort ein positiver Nachweis vorliegt.

Der relativitätstheoretische Begriff von „Gleichzeitigkeit“ beruht auf der vorausgesetzten Konstanz der Lichtgeschwindigkeit in allen Inertialsystemen und demzufolge auch einer gleichen Laufzeit eines Lichtpulses für hin und zurück zwischen zwei kräftefrei treibenden Beobachtern mit ihren jeweiligen Bezugssystemen. Daraus leiten sich die bekannten Lorentz-Transformationen für die Raum- und Zeitkoordinaten ab, welche verschiedene Beobachter den gleichen Ereignissen zuzuordnen haben. Dies hat insbesondere zur Konsequenz, dass nicht für jeden Beobachter dasselbe „gleichzeitig“ ist, sondern dass sich die Ebene der Gleichzeitigkeit im Raum-Zeit-Diagramm für einen zweiten Beobachter, der sich gegenüber einem ersten Ruhesystem bewegt, entsprechend einer Spiegelung von dessen Weltlinie an der 45°-Linie (welche die Lichtgeschwindigkeit repräsentiert) verkippt, so dass das Vorher oder Nachher von Ereignissen im Bereich außerhalb des jeweiligen Lichtkegels eine relative Frage des Bezugssystems bedeutet, aus welchem man die Ereignisse betrachtet.

Unabhängig vom jeweiligen Bezugssystem und unter Lorentztransformationen invariant ist jedoch das Raum-Zeit-Abstandsmaß t2-x2, dessen Vorzeichen angibt, ob der Abstand zwischen zwei Punkten in Raum & Zeit ein raumartiger oder zeitartiger ist, d.h., ob sich die Punkte innerhalb des Lichtkegels des jeweils anderen befinden oder nicht. Kausale Abhängigkeiten zwischen den Ereignissen an den verschiedenen Orten sollten im Rahmen der relativitätstheoretischen Vorstellungen auf den Fall zeitartiger Abstände beschränkt sein.

Somit stellt sich nun das Problem, wie dies mit der Beobachtung zu vereinbaren sein soll, dass die Ergebnisse von Messungen an verschiedenen Orten anscheinend ohne Zeitverzug miteinander korreliert sind, ohne dass eine Ursache für die konkreten Messergebnisse im Einzelfall im bereits gegebenen Zustand vor der Messung auszumachen wäre (wie das im Gegensatz dazu bei dem in einem anderen Leserbrief erwähnten Beispiel mit dem roten und dem blauen Ball in einer „Blackbox“ der Fall ist).

Wenn nämlich prinipiell ein Zustand vorläge, wo von vornherein feststeht, ob sich ein Teilchen am einen oder anderen Ort bzw. in diesem oder jenem Zustand einer Messgrößenverteilung befindet, wären diverse Interferenzerscheinungen schwer zu erklären, die sich daraus ergeben, dass eben keine Bestimmung der fraglichen Parameter vorgenommen wird und sich die offengebliebenen Möglichkeiten alle gleichermaßen zur Statistik der im weiteren Verlauf beobachtbaren Ereignisse überlagern.

Wenn also, wie die Befunde nahelegen, nicht davon ausgegangen werden kann, dass beispielsweise vor einer Spinmessung verschränkter Teilchen schon ein Zustand vorliegt, der auf eine bestimmte Messachse hin ausgerichtet oder gar auf ein bestimmtes Messergebnis festgelegt wäre, stellt sich neben der Frage, was nun als erste oder als zweite Messung zu nehmen wäre, insbesondere auch die, wie das eine Teilchen so schnell davon erfahren sollte, was nun am anderen gemessen wurde, um sein eigenes Messverhalten im Rahmen der quantenmechanischen Erwartung mit dem des Verschränkungspartners zu korrelieren, ohne dazu eine überlichtschnelle Informationsübertragung zu erfordern. Wobei aber unser Bild des Einzelfalls auf der Beobachtung vieler Einzelfälle basiert, in deren Ergebnissen insgesamt sich die statistischen Zusammenhänge offenbaren, deren logische Strukturen schwierig mit der Annahme relativistischer Lokalität des physikalischen Geschehens vereinbar scheinen.

Vorausgesetzt wird allerdings, dass dabei unabhängig von den jeweils vorgenommenen Messungen gleichartige Ausgangszustände oder zumindest gleichartige statistische Verteilungen möglicher Ausgangszustände angenommen werden dürfen, die Rückschlüsse aus den Beobachtungen vieler Versuchsdurchläufe auf die Gegebenheiten im Einzelfall erlauben. Die Annahme findet ihre solide Stütze erstens in der unmittelbaren Plausibilität des Grundsatzes, daß das zu messende System nicht vorher wissen wird, welche Messvorgänge später an ihm durchgeführt werden, und zweitens in den Vorhersagen der bewährten Quantentheorie, wonach die Übergangswahrscheinlichkeiten direkt mit der Zahl der möglichen Zustände verknüpft sind, in welche überhaupt übergegangen werden kann. Wenn also mehr als die theoriegemäßen Festlegungsparameter gegeben wären, sollten mehr Zustandsvariationsmöglichkeiten bestehen und man somit eine andere als die beobachtbare Statistik des Übergangsverhaltens erwarten.

Nun mögen in der Argumentation jedoch die üblichen Fallstricke eines geschlossenen Denksystems lauern, das sich im Wesentlichen selbst erklärt und so die Sicht auf andersartige Möglichkeiten zu verbauen neigt. Da wir ja nur die eine Wirklichkeit als Studienobjekt haben und keine identischen Zustände des gesamten Universums und seiner potentiellen Ursächlichkeiten reproduzieren können, können wir unter erkenntnistheoretischen Aspekten natürlich auch niemals wirklich sicher wissen, ob denn tatsächlich andere Möglichkeiten als die eingetroffenen bestanden hätten und ob die Muster, die nach statistischen Korrelationsprinzipien aussehen, nun wirklich auf statistichen Gesetzlichkeiten beruhen oder auf anderer funktionaler Basis zu ihren beobachtbaren Formen kommen. Natürlich kann man sich auch Mechanismen vorstellen, die solche Formen in letztlich deterministischer Weise produzieren, und dazu braucht´s noch nichtmal unbedingt welche nichtlokalen oder über die Prinzipien der Quantentheorie hinausgehenden Charakters, etwa im Rahmen der Theorie der vielen Welten, wonach jede (lokale) Quantenmöglichkeit auch in ihrem eigenen Wirklichkeitszweig realisiert wird, wobei die Aufspaltung der umgebenden Realität sich nicht schneller als mit Lichtgeschwindigkeit ausbreitet und sich inkompatible Zweige, die von verschiedenen Orten ausgehen, bei Aufeinandertreffen negativ überlagern und wechselseitig auslöschen, so dass nur die mit den theoriegemäß korrelierten Ereignissen als in sich gegebene Wirklichkeiten verbleiben.

Da dies das Vorstellungsvermögen strapaziert und ohnehin aus prinzipiellen Gründen eine Frage des persönlichen Glaubens bleiben muss, wäre es natürlich befriedigender, Vorstellungen zu entwickeln, die sich auf die beobachtbare Wirklichkeit und deren konkretes Funktionieren beschränken, ohne unnötig über nicht Verifizierbares zu spekulieren. Zu dem Zweck würde die Annahme einer absoluten globalen Zeit als physikalisch wirksamer Parameter mancherlei Komplikationen von etwaigen zeitlichen Rückwirkungen über mehrere Stufen und nachträglicher Verengung von vorangegangenen Realitätszuständen vermeiden, die einige Zweifel an der Vorstellung einer grundsätzlichen Wohlbestimmtheit der Gegebenheiten unserer Realität in Vergangenheit & Gegenwart aufwerfen würden. Das physikalische Opfer, das dafür zu bringen wäre, wäre eine Relativierung der Relativitätstheorie, dass nämlich unterhalb der Ebene des Manifesten und direkt Beobachtbaren durchaus Informationsflüsse mit Überlichtgeschwindigkeit erfolgen können sollten.

Zur Veranschaulichung stellen wir uns zwei verschränkte Teilchen mit Ruhemasse vor, die sich nach ihrer Erzeugung langsamer als mit Lichtgeschwindigkeit voneinander entfernen. Wird nun zum Beispiel eine Spinmessung an einem davon vorgenommen, legt dies „zugleich“ den Spinzustand des anderen fest, was logischerweise auch mit einer entsprechenden Änderung der Zustandsparameter am Ort des zweiten Teilchens verbunden sein sollte. Die Frage ist, ab welchem Zeitpunkt von einer erfolgten Änderung des Zustandes am zweiten Ort auszugehen wäre. Im relativitätstheoretischen Bild von Raum & Zeit wäre der Schnittpunkt der Weltlinie des zweiten Teilchens mit der Wand des vom Punkt der Messung am ersten Teilchen ausgehenden Rückwärtslichtkegels der einzig sinnvolle Kandidat, da aus Sicht des ersten Teilchens für jeden früheren Zeitpunkt bereits feststeht, dass am zweiten noch keine zustandsverändernde Messung vorgenommen wurde, und für jeden späteren bereits festgeschrieben ist, in welchem konkreten Spin-Eigenzustand sich das andere Teilchen zu befinden hat, um im Fall einer Messung daran ein mit der ersten Messung verträgliches Ergebnis zu produzieren. Wenn wir die Situation nun aber aus der Perspektive des zweiten Teilchens betrachten, das an besagtem Punkt eine korrelative Änderung seiner lokalen Zustandsparameter erfährt, und wir für dieses analog argumentieren, müsste demgemäß wiederum der Zustand des ersten Teilchens auf zweiter Stufe des „Kollapses“ schon an der Schnittstelle von dessen Weltlinie mit dem Rückwärtslichtkegel, der vom Punkt der Änderung des Zustandes des zweiten Teilchens ausgeht, auf den später gemessenen Eigenzustand reduziert werden, und somit im absoluten Sinne eines invariant zeitartigen Abstands zum Punkt der nachfolgenden kollapsauslösenden Messung. Wenn wir das Spielchen weitertreiben, müsste sich der Zustand der beiden Teilchen letztlich bereits bei deren Erzeugung auf die später erfolgenden Messungen einstellen, was unter kausalen Aspekten einer zeitlichen Rückwirkung bzw. einer Abtastung der Zukunft gleichkäme. Solche Abstrusitäten im Modell wären indes zu vermeiden, wenn man eine absolute globale Gleichzeitigkeit postuliert, auf deren Ebene die korrelativen Zustandsänderungen des fernen Verschränkungspartners erfolgen.

Ob es mit weniger gewagten Vorstellungen geht, die Formen des Beobachtbaren zu erklären, weiß ich nicht, was wesentlich Eingängigeres ist mir bislang nicht untergekommen an logisch konsistenten Interpretationsmodellen. Wie´s ausschaut, hat man wohl im Wesentlichen die Wahl zwischen Pest & Cholera im Philosophischen. Wenn wir von einer einzigen und unteilbaren Wirklichkeit ausgehen, scheint mir die Annahme nichtlokaler Funktionsprinzipien unvermeidlich, will heißen, weniger absurd als alternative Modellierungsmöglichkeiten. Nun ist zwar Raum nicht dasselbe wie Zeit, sonst könnten wir´s nicht unterscheiden, doch strukturell so eng damit verbunden, dass in dem Falle zu erwarten wäre, dass solche Prinzipien dann auch über die zeitliche Kausalitätsordnung der Relativitätstheorie hinausgehen sollten - woraus ich allerdings kein sinnvoll oder vielversprechend erscheinendes Bild des Funktionierens von Wirklichkeit zu ziehen wüsste. Mit Spekulationen über kausale Rückwirkungen oder zusätzliche Dimensionen der Zeit habe ich mich selber lange genug gespielt, um dies nunmehr für fruchtlose Ansätze zu halten, die nichts als Widersinn gebären.

Ich persönlich habe mich daran gewöhnt, in meiner Anschauung mit dem Modell der vielen Welten unter Wahrung der Lichtgeschwindigkeitsgrenze zu operieren und die Frage offenzulassen, ob da nun durch ein unbekanntes Ordnungsprinzip eine Auswahl unter den theoretischen Möglichkeiten (des globalen Realitätszusammenhangs) getroffen und nur eine verwirklicht wird oder ob tatsächlich alle nebeneinander. Konsequenzen fürs Beobachtbare hätte dies ohnehin nicht, aber die letztere Vorstellung ist eben die einfachste mit einem Minimum an fragwürdigem Hypotheseninput. Obgleich mich die Idee erschauern lässt, dass mir dann zwangsläufig auch nichts an möglichen Gräueln zu erleben erspart bliebe und alles, was mir überhaupt nur passieren kann, auch tatsächlich auf irgendeinem Wirklichkeitszweig widerfahren würde. Ja nun, das wäre wohl der Preis dafür, dass ich auf einem anderen Zweige König würde, obgleich mir das in unerfreulicheren Wirklichkeiten nun auch keinen nennenswerten Trost vermitteln könnte.

Doch könnte ich mir schon vorstellen, dass die Schwierigkeiten, fundamentale Prinzipien von Quanten- und allgemeiner Relativitätstheorie in logisch konsistenter Weise zu vereinen, letztlich darauf zurückzuführen sein mögen, dass eine korrekte quantenmechanische Repräsentation der Gravitationsvorgänge infolge der rückkoppelnden Wirkungen auf die Geometrie der Raumzeit, die wiederum die Quantenzustände trägt, eine grundsätzlich andere algebraische Struktur als andere Wechselwirkungen erfordern würde und womöglich auch mit nichtlinearen Beiträgen zum Hamilton-Operator verbunden wäre, worauf ggf. Auswahlmechanismen bzw. Kausalitätsprinzipien basieren könnten, die die Entwicklungsmuster unserer einen sichtbaren Wirklichkeit befriedigend zu begründen vermögen, ohne ursachenlose Zufallsentscheidungen, überlichtschnelle Informationsflüsse, zeitlich rückwärts laufende Kausalitäten oder hypothetische Parallelwelten ins Spiel bringen zu müssen.

Bleibt bis auf weiteres eine spannende Frage, ob es gelingt, ein solches Modell zu entwickeln, und eine harte Nuss für helle Köpfe. Und wie gesagt, würde ich mich dabei nicht an die Vorstellung einer direkten Realität der Zustandsfunktionen als konkret gegebene Gebilde in Raum & Zeit klammern, sondern die lediglich als formales Hilfsmittel zu einer einfach handhabbaren Repräsentation von Informationen über die zu erwartende Messwertsverteilung bei gegebener Systemzustandspräparation auffassen.

Zur Frage eines Leserbriefs über die Sicht aufs Universum aus dem Bezugssystem eines Photons sei noch bemerkt, dass ein Photon in seinem eigenen Bezugssystem gar nicht existieren würde, weil´s darin keine Energie mehr hätte. Es hängt im übrigen auch nicht vom Stillstand der Eigenzeit lichtschneller Teilchen ab, dass deren Verhalten in nichtlokaler Weise korreliert sein kann, das funktioniert bei weniger schnellen ganz genauso.

In der Hoffnung, nunmehr auch die letzten vermeintlichen Klarheiten zufriedenstellend ausgeräumt und zur Belebung der Debatte beigetragen zu haben, verbleibe ich mit philosophischen Bauchschmerzen,

Könnte man nicht statt des kostbaren Grundwassers Meerwasser nehmen?

Stellungnahme der Redaktion

Ja und nein. Wasser kommt in solarthermischen Kraftwerken an verschiedenen Stellen zum Einsatz. Zum einen im Dampfkreislauf selbst. Hier kommt Meerwasser wegen der darin gelösten Stoffe nicht in Frage, allerdings sind die benötigten Wassermengen gering. Deutlich mehr Wasser benötigen die Verfahren zur Reinigung der Spiegel (an Trockenreinigungsverfahren wird noch geforscht), auch hier lässt sich kein Meerwasser einsetzen. Und schließlich wird sehr viel Wasser für die Kühlung am Ende des Dampfkreislaufs benötigt. Hier könnte tatsächlich Meerwasser genutzt werden. Alternativ existiert die Möglichkeit der Trockenkühlung.

Würde man nun allerdings Meerwasser per Pipeline in die Sahara transportieren? Eher nicht, auch die Desertec-Planer rechnen mit spitzem Bleistift, obwohl der Rohstoff Sonne kostenlos ist. Nahe der Küste wäre dies allerdings möglich (hier wäre dafür wieder auf Bewölkungsgrad etc. zu achten). Also bleibt in der Regel die Trockenkühlung, die mit einem Wirkungsgradverlust von bis zu zehn Prozent behaftet ist, und höhere Investitionen verursacht. Wasser braucht sie allerdings auch. In der WRI-Studie "Juice from Concentrate" heißt es zum Beispiel: "Dry cooling systems—where exhaust steam is cooled using ambient air rather than water—reduce water usage by 90 percent, but can add 2–10 percent to levelized costs and reduce the plant’s efficiency by up to 5 percent. A variety of wet/dry hybrid cooling systems offer up to an 80 percent reduction in water usage with more modest cost and efficiency penalties."

Ich unterrichte an einer Sprachschule Englisch - vor allem Business Englisch - und nutze bereits seit Jahren Filme im Original mit Untertitel.

Leider gab es bisher nicht viel geeignetes Material. Seit ein paar Monaten nutze ich nun die untertitelten Online-Videos von LinguaTV, die speziell für den Fremdsprachenunterricht produziert werden. Es handelt sich um kurze und authentische Situationen aus dem privaten und beruflichen Alltag, die von Muttersprachlern gespielt und teilweise sehr unterhaltsam sind. Meine Kursteilnehmer lernen dadurch praxisrelevantes Vokabular und natürlich die Aussprache. Im Anschluss diskutieren und vertiefen wir einzelne Themen.

Ich kann also den Lernerfolg, der in Ihrem Artikel beschrieben wird, nur bestätigen: Bei uns funktioniert es auch in der Praxis sehr gut. Die Fähigkeit der Kursteilnehmer, sich in Gesprächssituationen zu artikulieren, hat sich erheblich gesteigert.

03.11.2009, Prof. Dr. Fritz-Dieter Doenitz, 92718 Schirmitz

"Wüste Beschimpfungen" wäre wohl der angemessenere Tittel für diesen Beitrag gewesen. Da dem Autor offensichtlich die Sachkenntnis und damit die sachlichen Argumente fehlen, hat er einen Schreckenskatalog aus Fehlschlägen und gigantismen der Vergangenheit zusammengestellt, um das Desertec-Projekt und mit ihm die Solarthermische Kraftwerkstechnik (STKT) zu diskreditieren. Was hat sie mit Atomenergie, "Rohstofffluch" und dem Scheitern technischer Großprojekte im vergangenen Jahrhundert zu tun? Es sind die sattsam bekannten Argumente der Ewiggestrigen, die sie auf ihren Rückugsgefechten seit Jahren wie eine Monstranz vor sich her tragen und eines nach dem anderen beerdigen müssen. Die Zeit wird über diesen Artikel hinweggehen, doch es tut weh zu sehen, wie die Meinungsfreiheit durch eine derartige (gezielte?) Desinformation missbraucht wird.

Weiß der Autor nicht oder will er es nicht wissen, dass die STKT seit zwanzig Jahren höchst erfolgreich in Kalifornien läuft und darüber hinaus mittlerweile 50 Kraftwerke in Spanien mit einem Investitionsvolumen von rund 15 Milliarden Euro am Netz, im Bau oder in der Planung sind? Wo bleibt da das "unkalkulierbare Novum"? Weiß er wirklich nicht, dass es in der Kraftwerkstechnik anstelle der Wasserkühlung auch eine Trockenkühlung gibt, die selbstverständlich dort eingesetzt wird, wo das verfügbare Wasser nicht ausreicht? Die Effizienz der Stromproduktion wird dadurch zwar um circa 8 Prozent vermindert, doch durch die gegenüber Spanien um 30 Prozent stärkere Einstrahlung in der Sahara überkompensiert. Glaubt der Autor ernsthaft, wir könnten mit dezentraler Stromproduktion, vornehmlich über Photovoltaik, unseren Elektrizitätsbedarf decken, der sich in den kommenden Dekaden durch das Aufkommen des Elektroautos verdoppeln wird? Eine einfache Abschätzung zeigt, dass man durch Belegen der einigermaßen geeigneten Dächer in Deutschland bestenfalls einen einstelligen prozentbeitrag zu unserer Stromversorgung leisten kann. Oder will er etwa unsere Grünflächen zupflastern? Eine Schreckensvision!

Woher schließlich nimmt dieser technisch Uninformierte die Behauptung, die STKT könne "in 40 Jahren technisch längst marginalisiert sein"? Im Gegenteil: die STKT wird 2050 dank ihrer Zuverlässigkeit, ihrer Fähigkeit zur Stromproduktion rund um die Uhr und der ihr zur Verfügung stehenden, unerschöpflichen Ressourcen das Rückgrat einer europäischen Stromversorgung bilden, die durch Hochspannungsgleichstromleitungen sämtliche erneuerbaren Stromquellen in Europa vernetzt und die konventionellen Kraftwerkstechniken abgelöst haben wird. Das ist die Wahrheit, und es wäre einer wissenschaftlichen Zeitschrift wie der Ihren angemessen, statt einer untragbaren, "wüsten" Polemik der sachlichen Information Raum zu geben.

Vergeblich suche ich im Spektrum der Wissenschaft einen sachlich fundierten Bericht über die STKT, von dem bemerkenswerten Interview mit Herrn Müller-Steinhagen in Heft 9/09 einmal abgesehen. Dann würde vielleicht Ihr Autor wenigstens die Grundprinzipien dieser Technik verstanden haben.

Es wird immer abstruser: Wenn es stimmt dass wir nicht mehr als ein Jahrzehnt in die Zukunft blicken können, wieso hat man dann für die letzten zehn Jahre apokalyptische Vorhersagen gemacht? Die Klimatologen haben sich ja gegenseitig übertroffen mit Vorhersagen wie "schneller, stärker, dramatischer als erwartet".

Dieses Zurückrudern könnte man als Anpassung an die Realität ansehen, würde Herr Latif nicht schon wieder skandieren: "Danach wird sie (die Erwärmung) dafür wohl umso schneller weitergehen."

Bevor man solche Vorhersagen macht, sollte man sich da nicht zuerst einmal fragen, wieso die letzten Vorhersagen nicht eingetroffen sind? Es gibt ja sogar Klimatologen, die behaupten, das Klima könnte erst einmal 25 Jahre lang "Pause machen", um das Versäumte dann wieder aufzuholen.

Man fragt sich was mit den Prognosen geschehen ist, die man vor 10 oder 20 Jahren machte beziehungsweise mit den das Netz füllenden Untergangsprophezeiungen der letzten drei Jahre. Immerhin hat Sven Titz in seinem Artikel " Kalt Erwischt" https://www.spektrum.de/artikel/979390&_z=798888 deutlich auf diesen Sachverhalt hingewiesen.

Wenn das Klima sich auf natürliche Weise so verändern kann wie die letzten 60 Jahre, wie kann man dann in den letzten 100 Jahren mit 99,999-prozentiger Wahrscheinlichkeit den Einfluss des Menschen herauslesen? Wer bei den hin- und zurückrudernden Aussagen der Klimatologen nicht skeptisch wird, ist selbst schuld, mit Verlaub.

02.11.2009, Dr. med. Stephan Zschocke, 25469 Halstenbek

In Ihrem ausgezeichneten Artikel vermisse ich eine Diskussion des möglichen Effektes der Gravitationswirkung der Erde auf den Mond. Da die gebundene Rotation des Mondes, wie in dem Aufsatz erwähnt, schon sehr früh begann und anfangs der Mond der Erde auch noch viel näher war, könnte die - bei gebundener Mondrotation - gleichförmig auf den Mond einwirkende erhebliche Gravitationskraft der Erde doch ebenfalls einen differenzierenden Einfluß auf die Magmabewegungen und die Krustenbildung von Vorder- und Rückseite des Mondes gehabt haben.

Nie gesehenes Naturphänomen

18.11.2009, Dipl.-Ing. Lutz-Michael WeißDa auch wissenschaftlich beschlagene Leute in meinem Bekanntenkreis so etwas noch nie gesehen haben bzw. dieses Phänomen auch nicht erklären können, wende ich mich an Sie bzw. bitte ich Sie um eine Möglichkeit, eine Antwort zu finden, z.B. durch Prof. H. J. Schlichting?

Ich habe das Objekt (siehe Bilder) einmal gegen Licht und einmal gegen einen dunklen Hintergrund fotografiert.

Fotos: Lutz-Michael WeißHandelt es sich um einen Monokristall? Kommt so etwas oft vor bzw. ist das leicht in einer solchen Größe reproduzierbar? Sind die blattähnlichen ausgerichteten Adern oder Bläschen Lufteinschlüsse (in der dunklen Scheibe)?

Oder ist das alles kein Thema, sind beobachtete Größe und Form hinreichend bekannt, und kann ein solches Objekt auch schon mal einen Meter im Durchmesser haben?

Wir haben Herrn Prof. Schlichting um eine Antwort gebeten. Hier ist sie:

Vermutlich ist der Kristall von der Mitte her zum Rand gewachsen. Denn es wäre unwahrscheinlich, dass gerade sechs Eisbäumchen vom Rande her symmetrisch zur Mitte wachsen und sich dort treffen. Aufgrund der Struktur des Wassermoleküls bildet sich beim Gefrieren an einem Keim zunächst eine winzige hexagonale Platte, die dann von diesem Startpunkt ausgehend weiter wächst.

Da beim Gefrieren Kristallisationswärme entsteht, wird das weitere Wachstum besonders in der Nähe des bereits erstarrten und gerade erstarrenden Wassers gebremst. Dies gilt weniger für die in den kalten Bereich des Wassers hineinragenden Stellen des Kristalls, also den sechs Ecken.

Wenn keine Störungen vorliegen entwickeln sich daher der hexagonalen Symmetrie folgend Eisnadeln von der bereits bestehenden Eisstruktur weg in Richtung Gefäßrand. An den Seiten dieser Nadeln entstehen (im vorliegenden Fall offenbar weniger durch die hexagonale Grundstruktur bedingt als vielmehr durch Zufall) einzelne Ausstülpungen von Eis, von denen die größten und damit von der Nadel am weitesten entfernten (wieder wegen der anfallenden Kristallisationswärme) bevorzugt sind und als Eiszweige sowohl vom Zentrum als auch von der Eisnadel weg schräg nach außen treiben. Nach dem gleichen Prinzip verzweigen sich diese Zweige und so weiter. Insgesamt entstehen daher zwischen den sechs Eisnadeln baumartige Gebilde.

Bei den Verzweigungen hat sich (durch Verunreinigungen und andere Störungen bedingt) eine exakt hexagonale Struktur gegen die stets vorhandenen zufälligen Tendenzen nicht durchsetzen können. Es sind Fraktale entstanden, wie man sie von vielen Wachstumsprozessen kennt (von elektrolytischer Anlagerung über Einzugsbereiche von Flüssen bis zu realen Bäumen).

Sie sind in ihren Teilen nicht gleich sondern selbstähnlich und daher haben wir es hier nicht mit einem Monokristall zu tun. Denn dieser besteht per definitionem aus einem fehlerfreien Kristallgitter. Das schränkt aber die Schönheit und wohl auch Seltenheit des vorliegenden Exemplars in keiner Weise ein. Denn hier werden Zufall (ähnliche, aber nicht identische Zweige) und Notwendigkeit (die hexagonale Grundstruktur) in ästhetisch ansprechender Weise miteinander verknüpft.

Die blattartigen Strukturen sind demnach nicht auf Lufteinschlüsse zurückzuführen (auch wenn solche vorhanden sein mögen).

Ich selbst habe zwar Eisnadeln von bis zu einem Meter Länge auf einem Teich beobachten können, auch mehrere von einem Zentrum ausgehende, aber bislang keine, die eine so strenge hexagonale Grundstruktur aufwiesen.

H. Joachim Schlichting

Falscher Fokus

18.11.2009, Erik Geibel1) Das Argument des Tierleids steht an erster Stelle. Dabei ist es schwer zu erfassen und eine Anwendung emotionaler menschlicher Kategorien ist nicht sachlich. Leidet ein Tier wirklich unter der zur Fleischproduktion dienenden Haltung, wenn vermeidbares Leid wie lange Transporte, zu große Individuendichte etc. unterlassen werden? Das Argument der Sicherung der Welternährung scheint mir dabei das deutlich belastbarere: Die Zahl von einer Milliarde hungernder Menschen und die schwindende Weltanbaufläche sprechen viel klarer und eindeutiger für die Reduktion des Fleischkonsums.

2) Die Haltung der vegetarischen Bevölkerungsminderheit ist lobenswert (ungeachtet der Sachlichkeit ihrer Begründung), doch ihre Zahl wird sich so schnell nicht vervielfachen. Der Fokus sollte mehr der Reduktion des Fleischkonsums im Großteil der Bevölkerung liegen. Dies wäre deutlich effektiver als die Zuspitzung auf die Alternative "Vegetarier oder nicht". Es wird ja auch nicht mehr gefordert, das Auto abzuschaffen, sondern in erster Linie weniger zu fahren.

Inhaltlicher Fehler

17.11.2009, Dr. Wilhelm Richard Baier, Graz"Die Fotosynthese wandelt CO2 in Sauerstoff um, während der aerobe Stoffwechsel das Gegenteil bewirkt." Das stimmt so nicht. Bei der Fotosynthese wird Wasser in Sauerstoff und Wasserstoff gespalten, wobei der Wasserstoff auf das Kohlendioxid übertragen wird (es entsteht Zucker) und der Sauerstoff als giftiges Abfallprodukt übrig bleibt. Bei der Atmung passiert genau das Gegenteil: Dem Zucker wird Wasserstoff entzogen und auf den Sauerstoff übertragen - es entsteht Wasser (kontrollierte Knallgasreaktion). Das Abfallprodukt ist hier neben dem Wasser natürlich Kohlendioxid.

Offensichtlich kann man ein und denselben Prozess – der seinerseits wieder eine komplizierte Abfolge chemischer Einzelreaktionen ist – sehr verschieden interpretieren, je nachdem, was man für das erwünschte Ziel der Reaktion und was man für Abfall hält. Peter Wards Interpretation konzentriert sich auf die atmosphärischen Gase Sauerstoff und Kohlendioxid und schweigt daher über die übrigen Beteiligten Glukose und Wasser. Unsereinen (wie alle Tiere) interessiert an dem ganzen aeroben Stoffwechsel vorrangig die Energie, die man daraus gewinnen kann; deswegen fällt es uns ja auch schwer, den Sauerstoff als Abfallprodukt (gar als giftiges) aufzufassen.

Christoph Pöppe, Redaktion

Replik von Wilhelm Richard Baier:

Es geht darum, dass der Sauerstoff eben nicht vom Kohlendioxid kommt, sondern aus der Zerlegung von Wasser. Außerdem ist Sauerstoff ein Zellgift. Daher hat die Anreicherung der Atmosphäre mit Sauerstoff durch Blaualgen die erste ökologische Katastrophe ausgelöst: ein globales Massensterben. Einige Bakterien (vermutlich ähnlich funktionierende Schwefelbakterien) haben es dann gelernt, den Sauerstoff zur Energiegewinnung zu nutzen. Eukaryonten (modernen Zellen) gelang dies nur durch Symbiose mit solchen Bakterien (das sind die heutigen "semiautonomen" Mitochondrien). Der Stoffwechsel der Eukaryonten ist so komplex, dass Sauerstoff jedenfalls ein Problem darstellt. Nur einigen einfacher gestrickten Bakterien ist es gelungen, mit dem Sauerstoff zurecht zu kommen. Daher waren die modernen Zellen auf diese Bakterien angewiesen, um in der neuen Umwelt überleben zu können.

Alibi-Schaukampf

16.11.2009, J. Krieger, MünchenWir können jedenfalls weit genug in die Zukunft blicken, um zu wissen, dass unsere Energie- und sonstige Resourcenverschwendung zwangsläufig in einen irgendwann nicht mehr funktionsfähigen Zustand führt: Stetig wachsender "Bedarf" kann irgendwann nicht mehr bedient werden, das ist mit allem so (über den Zeitpunkt mögen sich Prognostiker streiten - am Sachverhalt ändert sich nichts).

Um hier wenigstens ein bisschen gegensteuern zu können, ohne den auf die "bad-word-list" gesetzten Begriff "Ökologie" zu benutzen, hat man sich den "Klimaschutz" einfallen lassen.

Natürlich muss man auch CO2-Emissionen herunterfahren, wenn der Verdacht besteht, dass CO2 das Klima beeinflusst - aber letzten Endes ist das nicht das größte ökologische Problem.

Medea Gaias alter ego

16.11.2009, Dr. Anton Vogel, MünchenWäre das Leben auf Selbsttötung angelegt, hätte es in der Tat schon mehrere Gelegenheiten dazu gehabt. Wollte „Medea“ das traurige „You can never win“-Spiel lediglich verlängern und das Leben sadistisch von einer Katastrophe zur nächsten treiben? Können wir aus Computer-Abstürzen schließen, dass die Entwickler ihr System auf Selbstsabotage programmiert haben? Die Umstände auf der Erde waren, wie sie waren, und das Leben hat in verschiedenartiger Form seine Chancen genutzt. Freilich wurden die Karten mehrfach gewaltsam neu gemischt. Doch blieb die langfristige Balance trotz oder vielleicht gerade wegen solcher Einbrüche aufrecht erhalten.

Dass die Pflanzen CO2 verbrauchen müssen, ist ihnen ebenso wenig vorzuwerfen wie der Sonne, dass sie mit zunehmendem Alter mehr Wasserstoff verbrauchen muss und dadurch heißer wird.

Auch ist fraglich, wieweit der Umfang der Biomasse in Milliarden Tonnen Kohlenstoff tatsächlich Ausschlag gebend ist für ein grundsätzliches, stabiles Funktionieren der Biosphäre zu einem bestimmten Zeitpunkt, so, wie es Peter Ward in seinem Buch „Medea Hypothesis“ auf einer gedanklichen Zeitreise auch für die nächsten 500 Millionen Jahre einräumt (s. Chapter 8, "Predicted Future Trends of Biomass"). Wir Menschen haben uns nun einmal nicht auf den blühenden Mikrobenmatten des Präkambriums entwickelt, die eine sehr viel höhere Biomasse enthielten als alle heutigen Reiche des Lebens (Prokaryoten, Eukaryoten, höhere Organismen). Trotz rückläufiger Biomasse und stagnierender Artenentwicklung hält unser Planet eine Vielzahl an Möglichkeiten, aber auch Gefahren und Handlungsnotwendigkeiten für uns bereit. Die Aufforderung, diese Möglichkeiten zu nutzen, ist der positive Schluss von Wards Buch. Ab hier stimme ich mit dem Autor überein. Gaia alias Medea würde es sicher auch tun.

Erst einmal freiwillig!

15.11.2009, Alfred Hermann, HohensteinIch denke auch, dass die meisten Schüler überhaupt keine Lust auf Astronomie haben, da dies zwei weitere Stunden in der Woche bedeuten würde. Bei G8 haben die Schüler in Klasse 9 schon 34 oder 35 Wochenstunden, und wenn dann noch zwei Stunden dazu kommen würden, müssten die Schüler, die teilweise erst 14 Jahre alt sind, vier mal Nachmittags in der Schule bleiben. Allerdings würden Astronomielehrer auch noch ein weiteres Fach lehren müssen, da man zur Lehrerausbildung zwei Fächer studieren muss.

Schwierigeres & Einfacheres - Antwort auf Dr. Gehlhaar

13.11.2009, Walter Pfohl, MünchenAnzuführen wäre zunächst der rein logische Kausalitätsbegriff, der darauf zielt, dass aus Beobachtungen bzw. wahren Aussagen über einen Teil der Wirklichkeitsstrukturen weitergehende Schlüsse über nicht direkt beobachtete Gegebenheiten gezogen werden können. Diese Ebene von Kausalität ist nicht an die physikalische Zeitordnung gebunden - aus Kenntnis von Gegebenheiten der Gegenwart lassen sich solche der Vergangenheit ebenso wie welche der Zukunft entsprechend einschränken und näher bestimmen. Voraussetzung dafür ist, dass den separierbaren Ereignissen der Wirklichkeit eine implizite Ordnung systematischer wechselseitiger Korrelationsprinzipien zugrundeliegt, die einschlägige Deduktionen ermöglicht.

Davon zu unterscheiden wäre der physikalische Kausalitätsbegriff, der eng mit dem der Zeitordnung verbunden ist und darauf zielt, mit welchen Auswirkungen reale physikalische Veränderungen eines Teils der Wirklichkeit an anderen Stellen verbunden wären, und dieser allgemeinen Auffassung gemäß auch auf den Fall ungerichteter Korrelationsprinzipien ohne absolute Kriterien zur Unterscheidung von Ursache & Wirkung anwendbar wäre. Genauer zu spezifizieren wäre dabei der relativitätstheoretische Kausalitätsbegriff, der auf die strukturelle Einbettung der physikalischen Kausalitätszusammenhänge in Raum & Zeit zielt.

Was den betrifft, scheinen mir unterschiedliche Auffassungen darüber zu bestehen, was nun zu den unveräußerlichen axiomatischen Fundamenten der Relativitätstheorie oder unter die diskutablen Ergänzungsannahmen zu zählen wäre. Aus dem Formalismus der Quantenfeldtheorie ist so wenig wie aus dem der nichtrelativistischen Quantenmechanik zu ersehen, auf welchen Wegen der physikalischen Kausalitätsflüsse durch Raum & Zeit die zu beobachtenden nichtlokalen Korrelationsprinzipien verschränkter Quantensysteme zustandekommen sollten.

Allgemeiner Konsens dürfte darüber bestehen, dass die Relativitätstheorie verlangt, dass sich kein Quantum positiver Energie schneller als mit Lichtgeschwindigkeit ausbreiten kann. Was Informationsflussmöglichkeiten anbelangt, scheint gleichermaßen Einigkeit darüber zu bestehen, dass zumindest auf der Ebene des manifest Beobachtbaren überlichtschnelle Übertragungsvorgänge, die sich etwa für Kommunikationsanwendungen nutzen ließen, auszuschließen wären, aber im Hinblick auf etwaige darunterliegende und aus prinzipiellen Gründen nicht direkt beobachtbare Wirklichkeitsebenen scheiden sich offenbar die Geister, was die Relativitätstheorie nun wirklich zwingend fordert. Dem einen gilt diese bereits als befriedigend erfüllt, wenn nur die Transformationsregeln der Systembeschreibungsparameter das algebraische Kriterium einer gruppentheoretischen Darstellung der Lorentz-Transformationen erfüllen, andere verbinden damit höhere Ansprüche hinsichtlich der Einschränkungen möglicher Wirkungswege.

Wie immerhin durch Anwendung von Logik festzustellen ist, wären im relativistischen Modell überlichtschnell wirkende Kausalitätsvernetzungen zwangsläufig mit Paradoxien der zeitlichen Kausalitätsordnung verbunden, die heikle Fragen nach dem feststehend als Realität Gegebenen aufwerfen würden (vgl. dazu die Ausführungen in meinem vorangegangenen Leserbriefbeitrag zum selben Artikel).

Bei den komplexen Wahrscheinlichkeitsamplituden der Zustandsfunktionen und deren linearen Überlagerungsprinzipien sehe ich indes weit weniger Veranschaulichungs- und Nachvollziehbarkeitsprobleme: Ist es doch schon bei jeder einfachen mechanischen Schwingung so, dass die Energie dabei zwischen zwei Freiheitsgraden pendelt, welche der Auslenkungsamplitude bzw. der zeitlichen Änderung derselben entsprechen (etwas allgemeiner ausgedrückt, meine ich kanonisch verallgemeinerte Orts- und Impulsparameter). Sofern die Schwingung harmonisch ist, ist die Energie von den kanonischen Parametern in quadratischer Form abhängig. Und dass sich bei Überlagerung zweier Schwingungen diese Parameter jeweils separat addieren (Auslenkung zu Auslenkung & Bewegung zu Bewegung, und nicht etwa Geschwindigkeits- zur Positionskoordinate) und diese Summenwerte zu quadrieren sind, um die Gesamtenergiemenge des Vorgangs zu bestimmen, ist logisch einfach nachvollziehbar.

Nun ließe sich die quantenmechanische Beschreibung genausogut in Real- und Imaginärteile aufspalten, um beispielsweise den Realteil einer Zustandsfunktion als verallgemeinerten Ortsparameter und den Imaginärteil als Impulsparameter anzusetzen. Insofern ist es doch völlig natürlich und naheliegend, dass sich schwingende Systeme, als welche die Quantenzustandsfunktionen angesetzt sind, nach dem Muster zweidimensionaler Vektoren addieren und sich das formal elegant durch einen komplexen Phasendrehfaktor repräsentieren läßt. Und wenn die Quantenmechanik mit der klassischen kompatibel sein soll, kann´s gar nicht anders gehen, als dass der Beitrag zur Energie quadratisch von den zuvor separat addierten Beschreibungsparametern abhängt. Der einzige Unterschied zur klassischen Mechanik liegt darin, dass der Energiebeitrag in der Quantentheorie mit einem statistischen Gewichtsfaktor verbunden ist, diesen im Falle einer Messung tatsächlich beobachten zu können. Und dass der statistische Gewichtsfaktor eines Energiebeitrags gleich der Wahrscheinlichkeit des fraglichen energetischen Eigenzustandes sein sollte, ist ebenso unschwer einzusehen - und in umgekehter Richtung somit genauso.

Größere Schwierigkeiten habe ich wiederum damit, mir vorzustellen, wie sich die häufig postulierten physikalischen Feinauflösungsgrenzen von Raum & Zeit mit den fundamentalen Symmetrie- und Transformationsprinzipien der Relativitätstheorie oder mit einer unbegrenzten Extrapolation der Schrödinger-Gleichung auf Systeme größeren Energieinhalts vertragen sollen, geschweige denn mit einer auf ein unendliches Universum. Denn solche Grenzen sollten dadurch leicht zu unterschreiten sein, und universale Eigenzustände für Energiewerte scheint es nicht nur in Fällen von Unendlichkeit ohnehin gar nicht erst zu geben - die sollten nämlich stationär und bis auf einen globalen Phasenfaktor (mit welcher Frequenz im Falle von Unendlichkeit?) zeitlich unveränderlich sein, was aber gemäß allgemeiner Relativitätstheorie für ein Universum mit räumlicher Ausdehnung und Energiedichte nicht drin ist, außer vielleicht im Zustand einer kollabierten Singularität. Auch ein Indiz dafür, dass ein etwaiger universaler Hamilton-Operator unter Einbeziehung der Gravitation wohl wesentlich anders konzipiert sein müsste als einer für kleinere Systeme. Vielleicht kommt man mit der Vereinigung der großen Theorien nicht voran, weil man zu sehr darauf fixiert ist, unbedingt einen Operator konstruieren zu wollen, der eine Spektralzerlegung in energetische Eigenzustände ermöglicht, weil dies die mathematische Handhabung so schön vereinfacht.

Sprachlich unsensibel

13.11.2009, Werner Kirsch, KölnIch habe mich noch bemüht, eine weitere Bedeutung des Wortes Lebensborn zu finden, bin aber in allen Nachschlagewerken immer nur auf die NS-Einrichtung gestoßen. Ich unterstelle demjenigen, der die Überschrift getextet hat, nicht, absichtlich Nazijargon verwendet zu haben. Trotzdem vermisse ich sprachliche Sensibilität. Da „Born“ ein altes deutsches Wort für „Quelle“ ist, liegt die unverfängliche und sogar noch verständlichere sprachliche Alternative doch so nahe: „Lebensquell statt Todesbote“.

Eisverlust mal nachgerechnet

13.11.2009, Josef RaddyQuantenverschränkung - eine Vertiefung

13.11.2009, Walter Pfohl, MünchenGrundsätzlich geht es um Probleme eines konsistenten Vorstellungsbildes dessen, was an der funktionalen Basis an Wirklichkeitsstrukturen gegeben ist, das mit der Logik der formalen Prinzipien sowohl der Quantentheorie als auch der Relativitätstheorie zu vereinbaren wäre. Der Formalismus suggeriert, die quantenmechanischen Zustandsfunktionen wären direkte Repräsentationen konkreter Realitätsgegebenheiten. Im Sinne der Information (über Erwartungswerte und korrelative Vernetzungen der möglichen Messwerte), die in Form der Funktion kodiert ist, bedeuten diese auch tatsächlich Beschreibungen gegebener Strukturen der Realität, doch wäre es naiv, die formale Darstellung mit einer in allen Aspekten orignalgetreuen Abbildung der Wirklichkeit gleichzusetzen. Zwar ist diese unter informationstheoretischen Aspekten zweifellos originalgetreu genug, um damit korrekte Berechnungen anstellen und Vorhersagen treffen zu können, doch speziell der Ansatz einer Funktion mit prinzipiell wohlbestimmten Werten an ebenso wohlbestimmten Punkten in Raum & Zeit mag vielleicht mehr durch die Bedürfnisse des menschlichen Vorstellungsvermögens begründet sein als durch die eigentliche Natur der Sache. Ich würde davon ausgehen, dass die Natur ihre strukturellen Informationen nicht notwendig nach solchen Formprinzipien verkörpert, die sich mit den Mitteln menschlicher Vorstellungsmöglichkeiten, formaler Sprachen und Mathematik einfach beschreiben ließen, und die Zustandsfunktion für nicht mehr nehmen als eine konstruierte formale Kodierung von Information, die für die Statistik des Beobachtbaren von Relevanz ist.

Insbesondere betrifft die fragliche Information die Muster der Korrelation in den möglichen Ergebnissen von Messungen an verschiedenen Punkten in Raum & Zeit. Bereits bei der Repräsentation eines unverschränkten einzelnen Teilchens stellt sich das Problem der Interpretation des Umstandes, dass diesem eine beliebig großräumig ausgedehnte Zustandsfunktion entsprechen kann, die die Wahrscheinlichkeit beschreibt, das Teilchen an verschiedenen Orten vorzufinden, sofern man dort eine einschlägige Messung vornimmt, aber bei gleichzeitigen Messungen an auseinanderliegenden Orten ausgeschlossen ist, das Teilchen mehrfach nachweisen zu können. Im direkt genommenen Bild der formalen Repräsentation würde dies einen instantanen „Kollaps“ der Funktion ohne Beschränkung durch die Lichtgeschwindigkeitsgrenze erfordern, sobald für einen Ort ein positiver Nachweis vorliegt.

Der relativitätstheoretische Begriff von „Gleichzeitigkeit“ beruht auf der vorausgesetzten Konstanz der Lichtgeschwindigkeit in allen Inertialsystemen und demzufolge auch einer gleichen Laufzeit eines Lichtpulses für hin und zurück zwischen zwei kräftefrei treibenden Beobachtern mit ihren jeweiligen Bezugssystemen. Daraus leiten sich die bekannten Lorentz-Transformationen für die Raum- und Zeitkoordinaten ab, welche verschiedene Beobachter den gleichen Ereignissen zuzuordnen haben. Dies hat insbesondere zur Konsequenz, dass nicht für jeden Beobachter dasselbe „gleichzeitig“ ist, sondern dass sich die Ebene der Gleichzeitigkeit im Raum-Zeit-Diagramm für einen zweiten Beobachter, der sich gegenüber einem ersten Ruhesystem bewegt, entsprechend einer Spiegelung von dessen Weltlinie an der 45°-Linie (welche die Lichtgeschwindigkeit repräsentiert) verkippt, so dass das Vorher oder Nachher von Ereignissen im Bereich außerhalb des jeweiligen Lichtkegels eine relative Frage des Bezugssystems bedeutet, aus welchem man die Ereignisse betrachtet.

Unabhängig vom jeweiligen Bezugssystem und unter Lorentztransformationen invariant ist jedoch das Raum-Zeit-Abstandsmaß t2-x2, dessen Vorzeichen angibt, ob der Abstand zwischen zwei Punkten in Raum & Zeit ein raumartiger oder zeitartiger ist, d.h., ob sich die Punkte innerhalb des Lichtkegels des jeweils anderen befinden oder nicht. Kausale Abhängigkeiten zwischen den Ereignissen an den verschiedenen Orten sollten im Rahmen der relativitätstheoretischen Vorstellungen auf den Fall zeitartiger Abstände beschränkt sein.

Somit stellt sich nun das Problem, wie dies mit der Beobachtung zu vereinbaren sein soll, dass die Ergebnisse von Messungen an verschiedenen Orten anscheinend ohne Zeitverzug miteinander korreliert sind, ohne dass eine Ursache für die konkreten Messergebnisse im Einzelfall im bereits gegebenen Zustand vor der Messung auszumachen wäre (wie das im Gegensatz dazu bei dem in einem anderen Leserbrief erwähnten Beispiel mit dem roten und dem blauen Ball in einer „Blackbox“ der Fall ist).

Wenn nämlich prinipiell ein Zustand vorläge, wo von vornherein feststeht, ob sich ein Teilchen am einen oder anderen Ort bzw. in diesem oder jenem Zustand einer Messgrößenverteilung befindet, wären diverse Interferenzerscheinungen schwer zu erklären, die sich daraus ergeben, dass eben keine Bestimmung der fraglichen Parameter vorgenommen wird und sich die offengebliebenen Möglichkeiten alle gleichermaßen zur Statistik der im weiteren Verlauf beobachtbaren Ereignisse überlagern.

Wenn also, wie die Befunde nahelegen, nicht davon ausgegangen werden kann, dass beispielsweise vor einer Spinmessung verschränkter Teilchen schon ein Zustand vorliegt, der auf eine bestimmte Messachse hin ausgerichtet oder gar auf ein bestimmtes Messergebnis festgelegt wäre, stellt sich neben der Frage, was nun als erste oder als zweite Messung zu nehmen wäre, insbesondere auch die, wie das eine Teilchen so schnell davon erfahren sollte, was nun am anderen gemessen wurde, um sein eigenes Messverhalten im Rahmen der quantenmechanischen Erwartung mit dem des Verschränkungspartners zu korrelieren, ohne dazu eine überlichtschnelle Informationsübertragung zu erfordern. Wobei aber unser Bild des Einzelfalls auf der Beobachtung vieler Einzelfälle basiert, in deren Ergebnissen insgesamt sich die statistischen Zusammenhänge offenbaren, deren logische Strukturen schwierig mit der Annahme relativistischer Lokalität des physikalischen Geschehens vereinbar scheinen.

Vorausgesetzt wird allerdings, dass dabei unabhängig von den jeweils vorgenommenen Messungen gleichartige Ausgangszustände oder zumindest gleichartige statistische Verteilungen möglicher Ausgangszustände angenommen werden dürfen, die Rückschlüsse aus den Beobachtungen vieler Versuchsdurchläufe auf die Gegebenheiten im Einzelfall erlauben. Die Annahme findet ihre solide Stütze erstens in der unmittelbaren Plausibilität des Grundsatzes, daß das zu messende System nicht vorher wissen wird, welche Messvorgänge später an ihm durchgeführt werden, und zweitens in den Vorhersagen der bewährten Quantentheorie, wonach die Übergangswahrscheinlichkeiten direkt mit der Zahl der möglichen Zustände verknüpft sind, in welche überhaupt übergegangen werden kann. Wenn also mehr als die theoriegemäßen Festlegungsparameter gegeben wären, sollten mehr Zustandsvariationsmöglichkeiten bestehen und man somit eine andere als die beobachtbare Statistik des Übergangsverhaltens erwarten.

Nun mögen in der Argumentation jedoch die üblichen Fallstricke eines geschlossenen Denksystems lauern, das sich im Wesentlichen selbst erklärt und so die Sicht auf andersartige Möglichkeiten zu verbauen neigt. Da wir ja nur die eine Wirklichkeit als Studienobjekt haben und keine identischen Zustände des gesamten Universums und seiner potentiellen Ursächlichkeiten reproduzieren können, können wir unter erkenntnistheoretischen Aspekten natürlich auch niemals wirklich sicher wissen, ob denn tatsächlich andere Möglichkeiten als die eingetroffenen bestanden hätten und ob die Muster, die nach statistischen Korrelationsprinzipien aussehen, nun wirklich auf statistichen Gesetzlichkeiten beruhen oder auf anderer funktionaler Basis zu ihren beobachtbaren Formen kommen. Natürlich kann man sich auch Mechanismen vorstellen, die solche Formen in letztlich deterministischer Weise produzieren, und dazu braucht´s noch nichtmal unbedingt welche nichtlokalen oder über die Prinzipien der Quantentheorie hinausgehenden Charakters, etwa im Rahmen der Theorie der vielen Welten, wonach jede (lokale) Quantenmöglichkeit auch in ihrem eigenen Wirklichkeitszweig realisiert wird, wobei die Aufspaltung der umgebenden Realität sich nicht schneller als mit Lichtgeschwindigkeit ausbreitet und sich inkompatible Zweige, die von verschiedenen Orten ausgehen, bei Aufeinandertreffen negativ überlagern und wechselseitig auslöschen, so dass nur die mit den theoriegemäß korrelierten Ereignissen als in sich gegebene Wirklichkeiten verbleiben.

Da dies das Vorstellungsvermögen strapaziert und ohnehin aus prinzipiellen Gründen eine Frage des persönlichen Glaubens bleiben muss, wäre es natürlich befriedigender, Vorstellungen zu entwickeln, die sich auf die beobachtbare Wirklichkeit und deren konkretes Funktionieren beschränken, ohne unnötig über nicht Verifizierbares zu spekulieren. Zu dem Zweck würde die Annahme einer absoluten globalen Zeit als physikalisch wirksamer Parameter mancherlei Komplikationen von etwaigen zeitlichen Rückwirkungen über mehrere Stufen und nachträglicher Verengung von vorangegangenen Realitätszuständen vermeiden, die einige Zweifel an der Vorstellung einer grundsätzlichen Wohlbestimmtheit der Gegebenheiten unserer Realität in Vergangenheit & Gegenwart aufwerfen würden. Das physikalische Opfer, das dafür zu bringen wäre, wäre eine Relativierung der Relativitätstheorie, dass nämlich unterhalb der Ebene des Manifesten und direkt Beobachtbaren durchaus Informationsflüsse mit Überlichtgeschwindigkeit erfolgen können sollten.

Zur Veranschaulichung stellen wir uns zwei verschränkte Teilchen mit Ruhemasse vor, die sich nach ihrer Erzeugung langsamer als mit Lichtgeschwindigkeit voneinander entfernen. Wird nun zum Beispiel eine Spinmessung an einem davon vorgenommen, legt dies „zugleich“ den Spinzustand des anderen fest, was logischerweise auch mit einer entsprechenden Änderung der Zustandsparameter am Ort des zweiten Teilchens verbunden sein sollte. Die Frage ist, ab welchem Zeitpunkt von einer erfolgten Änderung des Zustandes am zweiten Ort auszugehen wäre. Im relativitätstheoretischen Bild von Raum & Zeit wäre der Schnittpunkt der Weltlinie des zweiten Teilchens mit der Wand des vom Punkt der Messung am ersten Teilchen ausgehenden Rückwärtslichtkegels der einzig sinnvolle Kandidat, da aus Sicht des ersten Teilchens für jeden früheren Zeitpunkt bereits feststeht, dass am zweiten noch keine zustandsverändernde Messung vorgenommen wurde, und für jeden späteren bereits festgeschrieben ist, in welchem konkreten Spin-Eigenzustand sich das andere Teilchen zu befinden hat, um im Fall einer Messung daran ein mit der ersten Messung verträgliches Ergebnis zu produzieren. Wenn wir die Situation nun aber aus der Perspektive des zweiten Teilchens betrachten, das an besagtem Punkt eine korrelative Änderung seiner lokalen Zustandsparameter erfährt, und wir für dieses analog argumentieren, müsste demgemäß wiederum der Zustand des ersten Teilchens auf zweiter Stufe des „Kollapses“ schon an der Schnittstelle von dessen Weltlinie mit dem Rückwärtslichtkegel, der vom Punkt der Änderung des Zustandes des zweiten Teilchens ausgeht, auf den später gemessenen Eigenzustand reduziert werden, und somit im absoluten Sinne eines invariant zeitartigen Abstands zum Punkt der nachfolgenden kollapsauslösenden Messung. Wenn wir das Spielchen weitertreiben, müsste sich der Zustand der beiden Teilchen letztlich bereits bei deren Erzeugung auf die später erfolgenden Messungen einstellen, was unter kausalen Aspekten einer zeitlichen Rückwirkung bzw. einer Abtastung der Zukunft gleichkäme. Solche Abstrusitäten im Modell wären indes zu vermeiden, wenn man eine absolute globale Gleichzeitigkeit postuliert, auf deren Ebene die korrelativen Zustandsänderungen des fernen Verschränkungspartners erfolgen.

Ob es mit weniger gewagten Vorstellungen geht, die Formen des Beobachtbaren zu erklären, weiß ich nicht, was wesentlich Eingängigeres ist mir bislang nicht untergekommen an logisch konsistenten Interpretationsmodellen. Wie´s ausschaut, hat man wohl im Wesentlichen die Wahl zwischen Pest & Cholera im Philosophischen. Wenn wir von einer einzigen und unteilbaren Wirklichkeit ausgehen, scheint mir die Annahme nichtlokaler Funktionsprinzipien unvermeidlich, will heißen, weniger absurd als alternative Modellierungsmöglichkeiten. Nun ist zwar Raum nicht dasselbe wie Zeit, sonst könnten wir´s nicht unterscheiden, doch strukturell so eng damit verbunden, dass in dem Falle zu erwarten wäre, dass solche Prinzipien dann auch über die zeitliche Kausalitätsordnung der Relativitätstheorie hinausgehen sollten - woraus ich allerdings kein sinnvoll oder vielversprechend erscheinendes Bild des Funktionierens von Wirklichkeit zu ziehen wüsste. Mit Spekulationen über kausale Rückwirkungen oder zusätzliche Dimensionen der Zeit habe ich mich selber lange genug gespielt, um dies nunmehr für fruchtlose Ansätze zu halten, die nichts als Widersinn gebären.

Ich persönlich habe mich daran gewöhnt, in meiner Anschauung mit dem Modell der vielen Welten unter Wahrung der Lichtgeschwindigkeitsgrenze zu operieren und die Frage offenzulassen, ob da nun durch ein unbekanntes Ordnungsprinzip eine Auswahl unter den theoretischen Möglichkeiten (des globalen Realitätszusammenhangs) getroffen und nur eine verwirklicht wird oder ob tatsächlich alle nebeneinander. Konsequenzen fürs Beobachtbare hätte dies ohnehin nicht, aber die letztere Vorstellung ist eben die einfachste mit einem Minimum an fragwürdigem Hypotheseninput. Obgleich mich die Idee erschauern lässt, dass mir dann zwangsläufig auch nichts an möglichen Gräueln zu erleben erspart bliebe und alles, was mir überhaupt nur passieren kann, auch tatsächlich auf irgendeinem Wirklichkeitszweig widerfahren würde. Ja nun, das wäre wohl der Preis dafür, dass ich auf einem anderen Zweige König würde, obgleich mir das in unerfreulicheren Wirklichkeiten nun auch keinen nennenswerten Trost vermitteln könnte.

Doch könnte ich mir schon vorstellen, dass die Schwierigkeiten, fundamentale Prinzipien von Quanten- und allgemeiner Relativitätstheorie in logisch konsistenter Weise zu vereinen, letztlich darauf zurückzuführen sein mögen, dass eine korrekte quantenmechanische Repräsentation der Gravitationsvorgänge infolge der rückkoppelnden Wirkungen auf die Geometrie der Raumzeit, die wiederum die Quantenzustände trägt, eine grundsätzlich andere algebraische Struktur als andere Wechselwirkungen erfordern würde und womöglich auch mit nichtlinearen Beiträgen zum Hamilton-Operator verbunden wäre, worauf ggf. Auswahlmechanismen bzw. Kausalitätsprinzipien basieren könnten, die die Entwicklungsmuster unserer einen sichtbaren Wirklichkeit befriedigend zu begründen vermögen, ohne ursachenlose Zufallsentscheidungen, überlichtschnelle Informationsflüsse, zeitlich rückwärts laufende Kausalitäten oder hypothetische Parallelwelten ins Spiel bringen zu müssen.

Bleibt bis auf weiteres eine spannende Frage, ob es gelingt, ein solches Modell zu entwickeln, und eine harte Nuss für helle Köpfe. Und wie gesagt, würde ich mich dabei nicht an die Vorstellung einer direkten Realität der Zustandsfunktionen als konkret gegebene Gebilde in Raum & Zeit klammern, sondern die lediglich als formales Hilfsmittel zu einer einfach handhabbaren Repräsentation von Informationen über die zu erwartende Messwertsverteilung bei gegebener Systemzustandspräparation auffassen.

Zur Frage eines Leserbriefs über die Sicht aufs Universum aus dem Bezugssystem eines Photons sei noch bemerkt, dass ein Photon in seinem eigenen Bezugssystem gar nicht existieren würde, weil´s darin keine Energie mehr hätte. Es hängt im übrigen auch nicht vom Stillstand der Eigenzeit lichtschneller Teilchen ab, dass deren Verhalten in nichtlokaler Weise korreliert sein kann, das funktioniert bei weniger schnellen ganz genauso.

In der Hoffnung, nunmehr auch die letzten vermeintlichen Klarheiten zufriedenstellend ausgeräumt und zur Belebung der Debatte beigetragen zu haben, verbleibe ich mit philosophischen Bauchschmerzen,

Walter Pfohl,

technischer Übersetzer,

München

Meerwasser statt Trinkwasser?

13.11.2009, Gerhard ZetzscheJa und nein. Wasser kommt in solarthermischen Kraftwerken an verschiedenen Stellen zum Einsatz. Zum einen im Dampfkreislauf selbst. Hier kommt Meerwasser wegen der darin gelösten Stoffe nicht in Frage, allerdings sind die benötigten Wassermengen gering. Deutlich mehr Wasser benötigen die Verfahren zur Reinigung der Spiegel (an Trockenreinigungsverfahren wird noch geforscht), auch hier lässt sich kein Meerwasser einsetzen. Und schließlich wird sehr viel Wasser für die Kühlung am Ende des Dampfkreislaufs benötigt. Hier könnte tatsächlich Meerwasser genutzt werden. Alternativ existiert die Möglichkeit der Trockenkühlung.