Statistik: Eine signifikante Geschichte

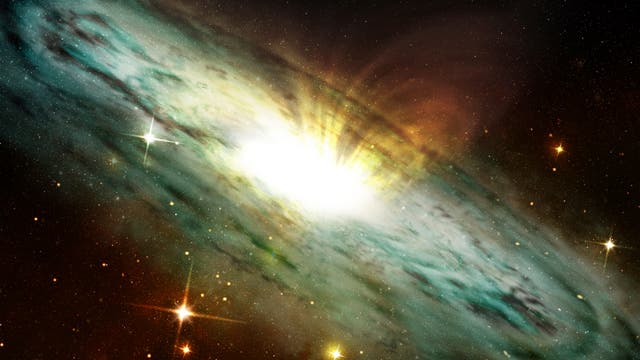

Am 11. Februar dieses Jahres verkündeten die Astrophysiker des LIGO-Experiments ihre große Entdeckung: Zum ersten Mal hatten sie ein Signal aus den Tiefen des Alls aufgefangen, das perfekt mit der rund 100 Jahre alten Vorhersage von Gravitationswellen aus Einsteins Relativitätstheorie übereinstimmte. 5,1 Sigma stark war das Signal, hieß es in der Meldung, die alle Medienberichte aufgriffen. Damit sei das Ergebnis "signifikant"; die Existenz der Gravitationswellen unzweifelhaft bewiesen.

Solche Signifikanzwerte, wie sie sich mit Mitteln der Statistik berechnen lassen, werden heute in den Medien und der Forschung wie Grenzen der Wahrheit behandelt. Wer sich aber die Geschichte der Signifikanz anschaut, erkennt: Die größten Entdeckungen der Naturwissenschaft kamen zu Stande, auch ohne dass jemand ihre Signifikanz berechnete. Wie sich zeigt, ist Signifikanz alles andere als die Schwelle der Wahrheit. Und ihre vermeintlich fixen Grenzen beruhen auf reiner Intuition.

Wissenschaft ohne Signifikanz

Wir schreiben den 20. Mai 1747. Das königlich britische Marineschiff Salisbury patrouilliert an der Biskaya, um eine Seeblockade gegen Frankreich durchzusetzen. In ihrem Bauch trägt sie 50 Kanonen, 300 Matrosen und hunderte Eichenfässer voller Proviant. In den "regulations" der königlichen Marine ist für jeden Seemann eine gigantische Ration vorgesehen: täglich 500 Gramm Schiffszwieback und 3,5 Liter Bier und jede Woche insgesamt 2 Kilogramm Rindfleisch, 1 Kilogramm Schweinefleisch, 1 Kilogramm Erbsen, 1,5 Liter Hafermehl für Brei, 170 Gramm Butter und 340 Gramm Käse.

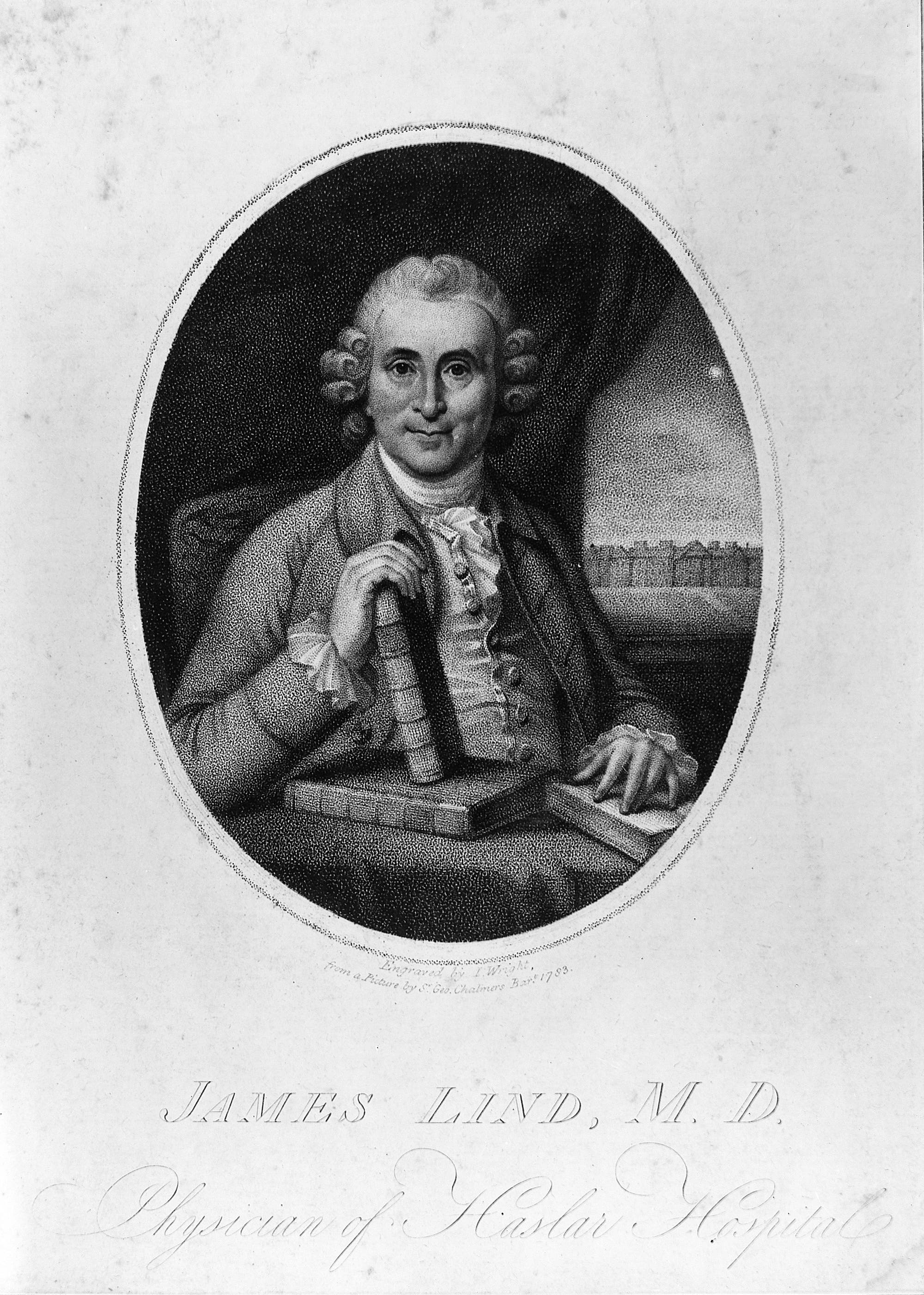

Doch nach mehr als acht Wochen ohne Landgang helfen auch diese 5000 Kalorien pro Tag und Mann nicht. "Zwölf kranke Männer hatte ich ins Vorschiff verlegt", berichtet der Schiffsarzt James Lind. "Ihre Fälle hätten ähnlicher nicht sein können. Alle hatten verdorbenes Zahnfleisch, waren mit Flecken übersät, matt und schwach in den Knien."

Für Lind war dies ein vorzüglicher Anblick, denn er wollte die Ursache des Skorbuts finden. Je ähnlicher der Zustand der Matrosen war, desto besser sollte sich an ihnen der Einfluss verschiedener Behandlungen zeigen. Allen zwölf Versuchsmatrosen verschrieb der Forscher das exakt gleiche tägliche Menü, mit nur einer kleinen Variation: Je zwei der Männer bekamen zusätzlich entweder Apfelwein, Apfelessig, etwas Schwefelsäure, Seewasser, Muskatnussmehl oder zwei Orangen und eine Zitrone.

Die Folgen waren erstaunlich deutlich: "Die schnellsten und offensichtlichsten guten Effekte hatten die Früchte", schrieb er in seinem Bericht aus dem Jahr 1753. "Schon nach sechs Tagen war einer der beiden Männer wieder diensttauglich. Zurück in Plymouth, war auch der zweite genesen."

Linds Experimente trugen maßgeblich dazu bei, dass ab 1795 auf allen Schiffen der britischen Marine der Grog mit Zitronensaft angereichert wurde und seither kaum ein Seemann mehr dem Skorbut erlag. Heute gilt Lind als der erste Forscher, der ein derart streng kontrolliertes klinisches Experiment durchführte. Sein wesentliches Verdienst war es zu zeigen, dass es sich lohnt, störende Faktoren zu minimieren; bei den Matrosen also individuelle Unterschiede in Alter, Größe, Schwere der Symptome oder auch in anderen Erkrankungen.

Nach Tabellen, statistischen Größen wie Mittel- oder Signifikanzwerten sucht man in Linds Bericht aber vergebens. Und noch 170 Jahre lang galten Ergebnisse als überzeugend, wenn das Experiment gut aufgebaut und die Daten klare Effekte zeigten. 170 Jahre, in denen der Sauerstoff, die elektrochemischen Grundlagen der Batterie und der Elektromagnetismus, die Radioaktivität und die Röntgenstrahlung entdeckt wurden. 170 Jahre, in denen sich herausstellte, dass alle Pflanzen aus Zellen aufgebaut sind, diese Zellen sich teilen, dass Arten durch natürliche Auslese entstehen, es noch andere Galaxien als die Milchstraße gibt, das Universum expandiert und dass es deshalb wahrscheinlich einen Anfang hat.

"Sogar der erste empirische Nachweis der Krümmung des Lichts, eine Vorhersage aus Einsteins Relativitätstheorie durch Arthur Eddington im Jahr 1919, wurde ohne Signifikanzen geführt", sagt Steve Ziliak, Wirtschaftsprofessor an der University of Chicago. "Dafür fuhren Schiffe mit Teleskopen bestückt vor die Küsten Afrikas und Brasiliens, um die Position eines Sterns während einer Sonnenfinsternis zu vermessen. Die Daten waren so überzeugend, dass alle Experten sofort zustimmten: Newton liegt falsch, Einstein hat Recht." Ziliak ist einer der schärfsten Kritiker unreflektierter Signifikanztesterei: "Keine große Entdeckung in der Naturwissenschaft hat allein auf Grund kleiner Signifikanzwerte stattgefunden", sagt der Autor des Buchs "The Cult of Statistical Significance".

Wie kam es zur Signifikanz?

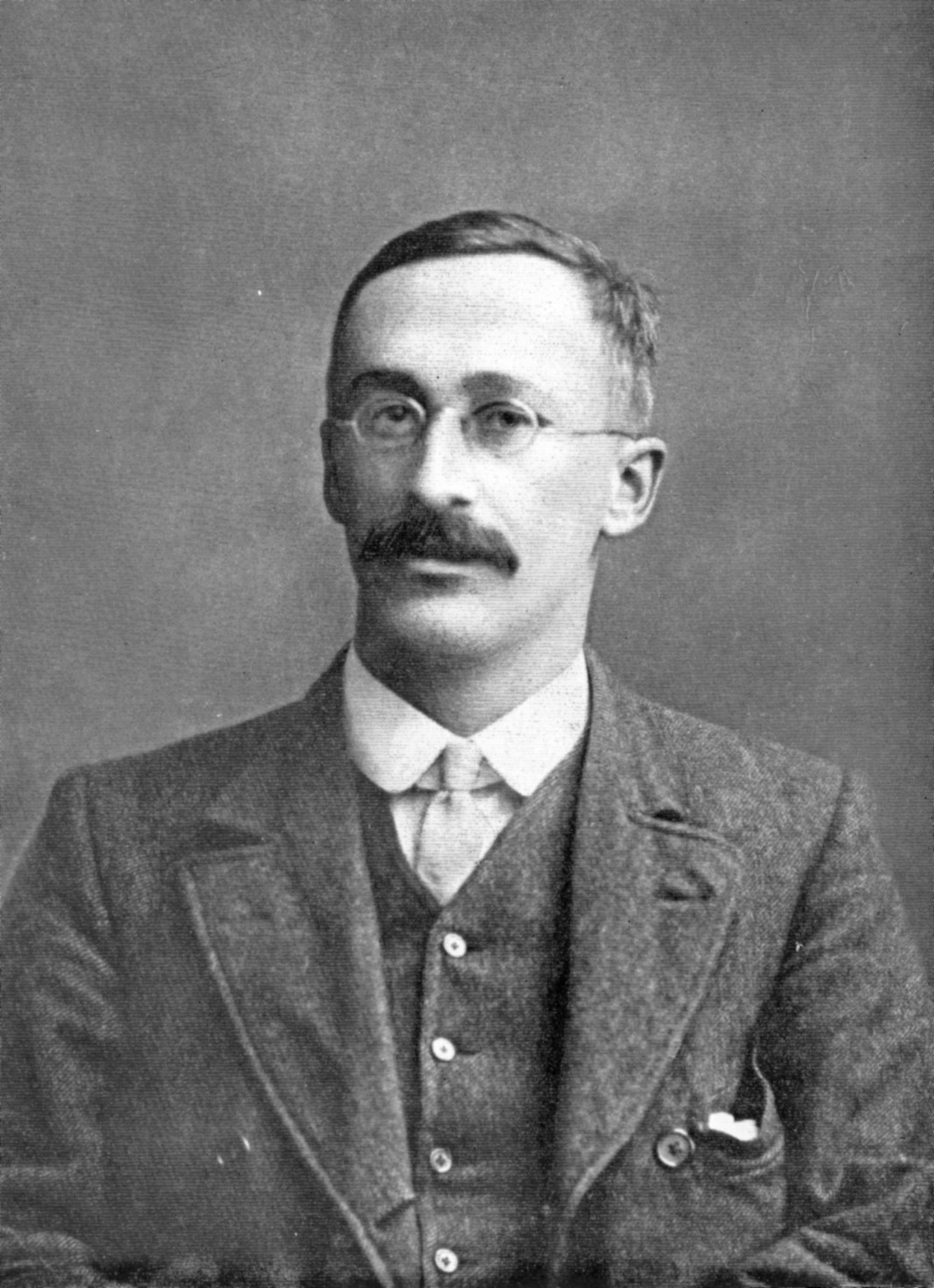

Der Bedarf, die Signifikanz – oder anders ausgedrückt: die Zuverlässigkeit – eines Resultats zu quantifizieren, kam erst zur Wende des 20. Jahrhunderts auf. Seit dem Jahr 1899 war der englische Chemiker William Sealy Gosset bei der Guinness-Brauerei in Dublin angestellt. Seine Hauptaufgabe war es, die besten Rohstoffe (Hopfen, Gerste, Hefe) für den schwarzen Sud zu finden. Bei der Gerste aber fiel der Vergleich der Malzausbeute schwer: Viele Bauern aus verschiedenen Regionen kamen als Hauptlieferanten in Frage.

Zudem konnte Gosset seine Experimente auf Grund hoher Kosten nur an kleinen Stichproben durchführen. Das aber könnte zur Folge haben, dass bei einem Vergleich zweier Lieferanten die mittlere Malzausbeute bei der ersten Stichprobe sehr unterschiedlich ausfiel, nur um bei der nächsten Stichprobe praktisch identisch zu sein. Welcher Lieferant war nun bessere? Wie sicher konnte man sich sein, dass ein beobachteter Unterschied in der Malzausbeute echt war und kein Kind von Zufallsschwankungen?

Gosset entwickelte ein mathematisches Verfahren, das den "wahrscheinlichen Fehler der Mittelwerte" bei kleinen Stichproben bestimmt. Je kleiner die Stichprobe, desto größer wird in seinem t-Test der wahrscheinliche Fehler und desto geringer die Signifikanz des Messwerts der Malzausbeute. Im Jahr 1908 veröffentlichte Gosset seinen Test – damals noch ein Geschäftsgeheimnis von Guinness – unter dem Pseudonym Student. Heute ist er als "Students t-Test" jedem Studenten empirischer Methoden bekannt.

"Der eigentliche Nachweis, welches Anbaugebiet und welche Gerstensorte den höchsten Ertrag an Malz lieferten, kam aber letztlich von Chemikern und Biologen", sagt Steve Ziliak. "Der t-Test war ein Hilfsmittel, um auf mögliche Unterschiede zwischen den Gebieten und Gerstensorten zu schließen."

Was eine Entdeckung letztlich möglich mache, sei, die Quellen der Streuung in den eigenen Stichproben zu identifizieren und zu kontrollieren. So wie es der Schiffsarzt Lind vorgemacht hatte. "Der größte Teil der Streuung in Daten kommt nicht von einem ungreifbaren Hintergrundrauschen, sondern von kontrollierbaren Einflüssen", sagt Ziliak. Erst wer diese systematischen Einflüsse auf die erhobenen Daten erkenne, in verbesserten Experimenten kontrolliere und damit die Streuung der Daten minimiere, könne mit einer Entdeckung rechnen. "Viele Leute in der Wissenschaft ignorieren heute diesen wichtigen Punkt."

p-Werte aus reiner Intuition

Gosset griff in seiner Arbeit auf das Konzept der p-Werte zurück, das sein Zeitgenosse Karl Pearson in London wenige Jahre zuvor eingeführt hatte. p-Werte beschreiben die Wahrscheinlichkeit, dass man eine Stichprobe erwischt hat, die aus reinem Zufall den beobachteten Effekt ergibt. Oder anders gefragt: Wie oft müsste man ein Experiment im Schnitt durchführen, damit einem der Zufall einmal diesen Effekt vorgaukelt? Sowohl Gosset als auch Pearson begnügten sich damit, diese Wahrscheinlichkeit zu quantifizieren. Eine Grenze, ab wann ein p-Wert akzeptabel sei oder nicht, gaben sie nicht an. Erst Gossets Kollege und Freund Ronald Fisher, Biologe und Statistiker an der University of Cambridge, schlug im Jahr 1925 eine Konvention für den p-Wert vor: Gemessene Effekte sollten nur dann als signifikant gelten, so Fisher, wenn sie sich im Schnitt höchstens einmal in 20 Wiederholungen durch Zufall ergeben würden, schreibt er in seinem berühmten Lehrbuch "Statistische Methoden für die Wissenschaft".

Eine mathematische Begründung für die spezifische Grenze von 1 in 20 (äquivalent zu 1,96 Sigma und p = 0,05) gab Fisher nicht. Wie sollte er auch? Es gibt keine mathematischen Beweis dafür, ab welcher Wahrscheinlichkeit einer irreführenden Stichprobe wir die daraus resultierende Aussage als wahr empfinden sollten. Kein Test entscheidet darüber, sondern unsere Intuition.

Worum es Gosset und Fisher mit dem Signifikanztest eigentlich ging, war, die finanziellen und zeitlichen Ressourcen des Forschers zu schonen. Beide verstanden Signifikanz (in Form von p-Werten) keineswegs als Beweismittel für die Entscheidung, ob eine Hypothese ("die Hopfenlieferungen haben unterschiedliche Qualität") wahr ist oder nicht. Stattdessen sahen beide in der Signifikanz ein Hilfsmittel, um zu entscheiden, ob ein erstes experimentelles Ergebnis weitere Experimente nahelegt.

Die Folgen missverstandener Signifikanz

Heute dagegen sprechen Forscher und Journalisten von der Signifikanzgrenze von p = 0,05 oft, als sei sie die Grenze der Wahrheit. Auf der einen Seite dieser Grenze steht die jeweilige Nullhypothese: Es gibt keine Gravitationswellen, alle Gerstensorten liefern den gleichen Ertrag, Zitrusfrüchte haben keinen Einfluss auf den Skorbut. Auf der anderen Seite steht die Alternativhypothese: Es gibt Gravitationswellen, die Gerste vom Bauern O'Leary ist besser als die der anderen, Zitrusfrüchte heilen Matrosen vom Skorbut. Liegt der p-Wert des verwendeten Signifikanztests unter der Grenze, dann ist die Nullhypothese falsch, die Alternativhypothese wahr und umgekehrt.

Doch dieses Verständnis der Signifikanz ist selbst falsch. Grundsätzlich liegt darin ein logisches Missverständnis: Signifikanzwerte beschreiben keine Grenze, ab der eine Hypothese wahr wird und die andere falsch, sondern die Wahrscheinlichkeit, dass ein gemessener Effekt aus einer ungünstigen Zufallsstichprobe rührt. Und dieses grundlegende Missverständnis von der Bedeutung eines Signifikanzwerts hat manchmal schlimme Konsequenzen.

Die Firma MSD Sharp & Dohme hatte im Jahr 2000 eine interne Studie zu ihrem Schmerzmittel Vioxx mit 8076 Teilnehmern durchgeführt. Darin ging es um die Frage, ob das Schmerzmittel eine negative Wirkung auf den Magen-Darm-Trakt hat. Doch in ihrem zwölfmonatigen Verlauf zeigte sich, dass die Teilnehmer, die Vioxx bekamen, ein vier- bis fünffach erhöhtes Herzinfarktrisiko hatten. Allerdings meldete MSD diese Beobachtung nicht an die amerikanische Gesundheitsbehörde, weil die p-Werte ihrer Tests über 0,05 lagen.

"Der p-Wert beim Vergleich der beiden Gruppen lag mit p = 0,2 deutlich über der Signifikanzgrenze von 0,05", sagt Ziliak, "p = 0,2 bedeutet aber auch eine Wahrscheinlichkeit von 0,8, dass vermehrte Herzinfarkte tatsächlich durch Vioxx ausgelöst wurden!" Nachdem die Studie an die Öffentlichkeit kam, nahm MSD das Medikament im Jahr 2004 vom Markt. Experten vermuten, dass das Medikament für bis zu 140 000 zusätzliche Herzinfarkte in den USA verantwortlich war. Im Jahr 2011 wurde das in Amerika unter dem Namen Merck & Co. firmierende Unternehmen deswegen zu Schadensersatzzahlungen von rund 630 Millionen Dollar verurteilt.

Auf der einen Seite also können statistisch nichtsignifikante Ergebnisse dennoch medizinisch extrem signifikant sein. Auf der anderen Seite provoziert das falsche Verständnis der Signifikanz immer wieder Fälle, in denen sich vermeintliche Wahrheiten verbreiten – manchmal steckt Betrug dahinter, manchmal einfach Naivität der Wissenschaftler.

Missbrauch der Signifikanz

Ein krasses Beispiel für Missbrauch statistischer Signifikanz beschreibt ein Artikel, der kürzlich im "Journal of Experimental Psychology" erschien. Die Autoren, Psychologen um David Shanks vom University College London, hatten insgesamt 43 Experimente in der Fachliteratur zusammengetragen, die einen signifikanten Zusammenhang zwischen sexuellen Gedanken und der Bereitschaft, Geld auszugeben oder Risiken einzugehen, gefunden haben. Shanks und seine Kollegen ermittelten für alle 43 Experimente die Stärke der gemessenen Effekte, die Streuung der Daten in den Stichproben sowie die resultierenden p-Werte. Dann wiederholten sie acht der 43 Experimente exakt, wie in den Studien beschrieben. Das Bild, das aus dieser Prüfung entstand, ist erstaunlich.

Bei keinem der acht Experimente konnten Shanks und seine Kollegen einen großen und signifikanten Effekt feststellen. Ihre eigenen p-Werte standen in krassem Kontrast zu den acht Originalstudien, weit von der Grenze von 0,05 entfernt und breit gestreut. Dagegen lagen alle p-Werte der ursprünglichen 43 Resultate unmittelbar unter der 0,05-Grenze, und zwar unabhängig davon, ob die Streuung der Daten groß oder klein war. Das jedoch, so die Autoren, mache keinen Sinn: Bei den Studien mit geringer Streuung in den Stichproben müssten die p-Werte eigentlich näher aneinanderliegen als bei stärker verrauschten Stichproben. Wenn die p-Werte sich aber unabhängig von der Streuung an die 0,05-Grenze schmiegen, dann drängt sich eine unangenehme Schlussfolgerung auf: "Dies ist entweder ein Hinweis auf p-Hacking oder auf selektives Publizieren von Ergebnissen oder beides", schreiben Shanks und seine Kollegen.

"p-Hacking" bedeutet, einzelne Datenpunkte aus der Stichprobe zu löschen, um so den resultierenden Effekt (den Mittelwert aus der Stichprobe) in Richtung über die Signifikanzschwelle zu schieben. Und selektives Publizieren heißt, ein Experiment so oft zu wiederholen, bis eine der Stichproben ein signifikantes Ergebnis produziert, die vielen negativen Resultate aber zu verschweigen.

Die fehlende Reproduzierbarkeit von Experimenten ist ein verbreitetes Problem in den Wissenschaften, die mit kleinen Stichproben und verrauschten oder unklaren Messgrößen arbeiten. Das zeigen gleich zwei Metaanalysen aus den vergangenen Jahren [1, 2]. Das Problem hat eine einfache Ursache: Experimente mit kleinen Stichproben, stark gestreuten Daten und kleinen Effekten werden trotz unzureichender Signifikanz nur ein einziges Mal durchgeführt und ohne nochmalige Prüfung veröffentlicht.

Heute befindet sich die Psychologie oder die Hirnforschung in einer ähnlichen Lage wie damals Gosset bei Guinness. Oft sind die Stichproben klein, die Effekte schwach und die Daten verrauscht. Wie bei der Suche nach der besten Gerste kann die Signifikanz auch hier ein hilfreiches Instrument sein. Allerdings nur, wenn man sie als das versteht, was sie ist: ein Mittel, um zu entscheiden, ob man eine Hypothese mit zusätzlichen und besseren Experimenten weiter verfolgen sollte.

Denn der Weg zu einem echten Ergebnis, das haben die großen Entdecker von James Lind bis zum LIGO-Experiment immer aufs Neue bewiesen, führt nicht über die Signifikanz, sondern über besser kontrollierte Experimente. Bis zu dem Punkt, an dem so etwas wie Wahrheit unabweisbar aus den Daten spricht.

Schreiben Sie uns!

6 Beiträge anzeigen