Quantencomputer: Quantenfehler lassen sich immer besser korrigieren

Im Rennen um den ersten nützlichen Quantencomputer hat Google wieder die Nase vorn. Das »Quantum AI«-Team des US-Konzerns um den deutschen Informatiker Hartmut Neven zeigt in der aktuellen Ausgabe des Fachmagazins »Nature«, dass sich die für den praktischen Einsatz von Quantencomputern nötige Fehlerkorrektur der Quantenbits auch auf größere Quantensysteme anwenden lässt. Ein solches Verfahren ist von großer Bedeutung, weil die in den Qubits gespeicherte Information sehr leicht durch Umwelteinflüsse beeinträchtigt wird und daraufhin verloren geht. In der neuen Veröffentlichung demonstrieren die Forschenden, dass die Fehlerraten bei einem größeren System tatsächlich geringer sind als bei einem kleineren. Damit habe man den nächsten Meilenstein erreicht und sei sehr optimistisch, noch in diesem Jahrzehnt einen Quantenchip zu bauen, der echte Probleme lösen kann, sagte Neven in einem Pressegespräch.

Dass sich solche Korrekturverfahren hochskalieren lassen, ist nicht selbstverständlich, da größere Systeme mit vielen Qubits anfälliger sind für Fehler als kleine. Qubits – die quantenphysikalischen Pendants der klassischen Computerbits – reagieren hochsensibel auf äußere Einflüsse und ändern oft während der Berechnung ungewollt ihren Zustand. Dadurch produzieren sie immer wieder falsche Ergebnisse. Dies zu bemerken und zu korrigieren, ohne dass der fragile Quantenzustand zerstört wird, ist Aufgabe der Fehlerkorrekturverfahren. Ohne solche Techniken können die Quantencomputer das ihnen zugeschriebene Potenzial nicht verwirklichen. Sie sollen eines Tages in der Materialforschung eingesetzt werden, bei der Entwicklung neuer Medikamente oder bei der Lösung komplexer Probleme etwa im Banken- und Versicherungsbereich.

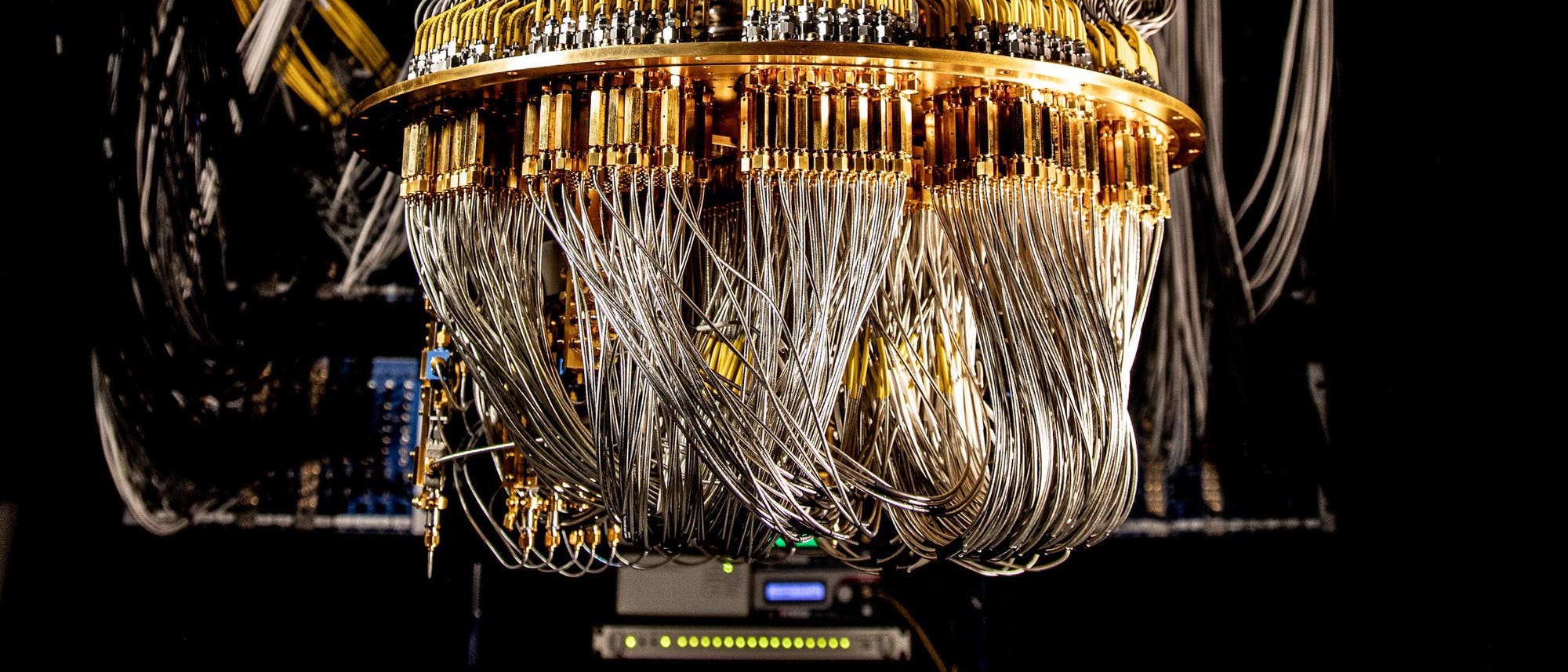

Für ihre Studie nutzten die Google-Forscherinnen und -Forscher einen Chip aus der Sycamore-Serie, womit sie im Jahr 2019 auch das viel beachtete Experiment zur Quantenüberlegenheit durchführten. In der Zwischenzeit haben sie die Zahl der Qubits von 54 auf 72 erhöht und konnten einige technische Details des Chips verbessern. Jedes der verwendeten Qubits besteht aus einem winzigen supraleitenden Schaltkreis. Die besondere Herausforderung im Unterschied zu den Fehlerkorrekturmechanismen bei klassischen Computern ist das No-Cloning-Theorem. Es besagt, dass man Quanteninformation nicht einfach kopieren kann. Somit gibt es kein »Backup«. Ebenso wenig lässt es die Quantenmechanik zu, den Zustand eines einzelnen Qubits auszulesen, ohne dass das gesamte System kollabiert.

Fehlerkorrektur funktioniert auch in Groß

Um dieses Problem zu umgehen, muss die gespeicherte Information von einem Qubit auf ein verschränktes System von mehreren weiteren Qubits übertragen werden. Die Idee dazu entwickelte der US-Informatiker Peter Shor bereits in den 1990er Jahren. Eine solche Funktionseinheit aus mehreren physischen Qubits bezeichnet man als logisches Qubit. Dieses System macht eine Fehlerkorrektur überhaupt erst möglich: Ist eins der physischen Qubits fehlerhaft oder fällt aus, verrät sich dies beim Vergleich mit den anderen. Es können nun auf Grund der quantenmechanischen Überlagerung (Superposition) der Zustände zwei verschiedene Arten von Fehlern auftreten: der Bit-Flip-Fehler und der Phase-Flip-Fehler.

Die Forschenden nutzten zur Fehlerkorrektur einen so genannten »surface code«, der es auf Basis einer zweidimensionalen Anordnung der Qubits erlaubt, beide Fehlertypen zu detektieren. Das Team testete den Quantenchip mit zwei verschiedenen surface codes: einem logischen Qubit mit 25 Daten- und 24 Mess-Qubits (ein so genanntes Distanz-5-Qubit) und einem kleineren logischen Qubit mit neun Daten- und acht Mess-Qubits (ein Distanz-3-Qubit). Es zeigte sich über eine Messreihe von 25 Zyklen, dass der größere surface code mit einer Fehlerrate von 2,9 Prozent pro Zyklus eine bessere Leistung des logischen Qubits ermöglichte als der kleinere. Letzterer zeigte eine Fehlerrate von drei Prozent pro Zyklus.

»Das Ziel, logische Qubits zu verbessern, wurde in der Studie erreicht – wenn auch knapp«, urteilt Andreas Wallraff, Professor für Festkörperphysik und Direktor des Quantum Centers an der ETH Zürich. »Der nächste Schritt muss nun sein, das Gleiche mit deutlich besseren physischen Qubits zu demonstrieren, so dass der Vorteil der Verwendung der logischen Qubits stärker sichtbar wird.« Im Moment sei nur gezeigt worden, dass es funktioniert, der praktische Vorteil sei aber noch sehr gering. Wallraff selbst hatte mit seinem Team erst im Mai 2022 selbst in einem »Nature«-Artikel eine substanzielle Verbesserung des surface codes auf einem Distanz-3-Qubit gezeigt. »Wir waren sehr stolz, es damit vor Google und IBM über die Ziellinie geschafft zu haben«, sagt er. Für ein Distanz-5-Qubit habe ihnen jedoch der ausreichend große Quantenchip gefehlt.

Um am Ende tatsächlich einen Vorteil durch den Einsatz von logischen Qubits zu erhalten, müssen die Fehlerraten jedoch noch deutlich kleiner werden, als Google es in der aktuellen Arbeit erreicht hat. Darin sind sich die vom Science Media Center zu der Studie befragten Quantenexperten einig. »Erst dann würden logische Qubits länger als die zu Grunde liegenden physikalischen Qubits ›leben‹, also eine längere Kohärenzzeit haben und somit die Durchführung von echten Quantenalgorithmen erlauben«, sagt etwa Stefan Filipp, Professor für Technische Physik an der TU München. Hier stehe die Forschung nun an einem entscheidenden Wendepunkt. »Insgesamt betrachtet gibt es kein fundamentales Limit, das der Entwicklung eines fehlertoleranten Quantencomputers entgegenstehen würde.« Die vorliegende Arbeit zeige, dass sich der Aufwand lohnt.

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.