Simulationen: Wie ein Klimamodell entsteht

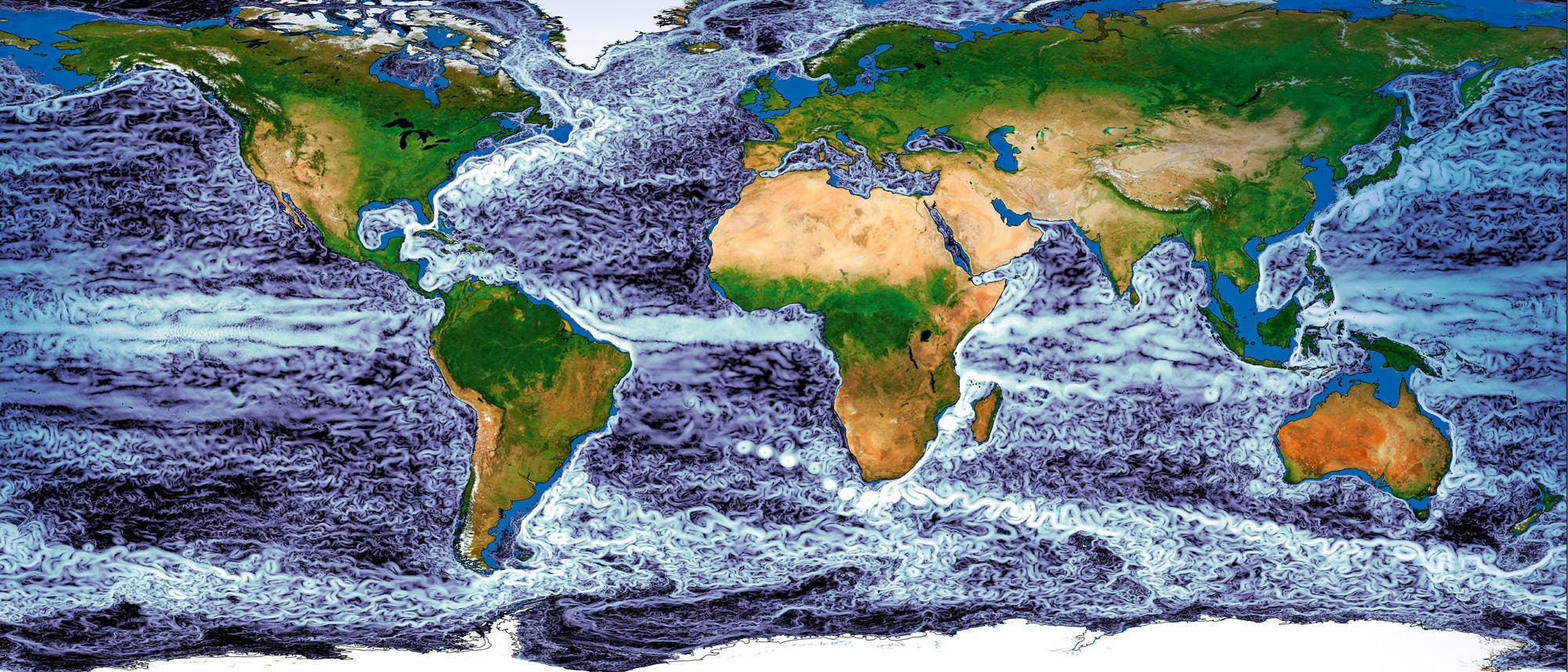

Zu den wichtigsten Werkzeugen in der Klimaforschung gehören mathematische Modelle und leistungsfähige Algorithmen für Computersimulationen. Mit diesen beschreiben die Wissenschaftler inzwischen seit Jahrzehnten, wie sich das Klima auf der Erde entwickelt – vereinfacht und dennoch möglichst genau. Sie nutzen die Berechnungen einerseits für Vorhersagen und andererseits wie künstliche Laboratorien. Damit untersuchen sie physikalische Phänomene und Zustände, die sich in der Realität kaum oder nur mit enormen Risiken darstellen ließen. Was könnte beispielsweise geschehen, wenn sich große Meeres- oder Luftströmungen verändern, Wälder verschwinden oder wir Partikel wie Staub in die Atmosphäre einbringen?

Eine solche Art der Forschung erscheint vielen abstrakt. Doch ganz ähnliche Modelle sind fest in unserem Alltag verankert: die Wettervorhersagen. Auch diese wissenschaftlichen Prognosen basieren auf Simulationen. Für den Wetterbericht laufen täglich Berechnungen auf riesigen Supercomputern. Wetter- und Klimamodelle sind im Detail nicht dasselbe und erfüllen andere Aufgaben. Die mathematischen Grundbausteine haben allerdings eine vergleichbare Struktur, die Unterschiede liegen in den Feinheiten. Um die Möglichkeiten und Grenzen von Klimamodellen besser zu verstehen, hilft es deshalb, sich zunächst das Wetter genauer anzuschauen.

Mathematiker sprechen beim Wetter von einem hochgradig nichtlinearen System. Ein lineares System reagiert auf eine kleine Störung, indem es seine Eigenschaften im gleichen Verhältnis dazu verändert. Bei einem etwas größeren Einfluss fällt die Reaktion proportional stärker aus – etwa wenn man beim Laufen bei doppeltem Kraftaufwand die zweifache Geschwindigkeit erreichen würde. Jeder weiß, dass bereits dieses vereinfachte Beispiel nicht stimmt: Wenn man schneller läuft, kostet es unverhältnismäßig mehr Kraft, auf ein noch höheres Tempo zu kommen. Schon das Laufen ist nichtlinear. Beim Wetter ist es noch viel komplizierter. Zum Beispiel kann ein leichter örtlicher Temperaturanstieg in einem Augenblick mehr Wind hervorrufen. Zu einem anderen Zeitpunkt und unter etwas geänderten atmosphärischen Bedingungen kann der gleiche Vorgang den Wind abflauen lassen. Die Reaktion verhält sich nicht mehr gleich bleibend zur Störung, und Vorhersagen fallen wesentlich schwerer.

Für nichtlineare Systeme sind mathematische Methoden und äußerst leistungsfähige Algorithmen nötig, die genau an das Problem angepasst sind. Ob die daraus resultierenden Computersimulationen überhaupt plausibel sind, prüfen Wissenschaftler kritisch in fachübergreifenden Kooperationen. Der Arbeitsschritt ist enorm wichtig und heißt Validierung. Dabei untersuchen die Experten, wie nah oder wie fern die Prognose von der Realität entfernt ist. Häufig müssen die Modellierer daraufhin ihre eingesetzten Algorithmen korrigieren. Reale Beobachtungen zum Beispiel mit Sensoren auf der Erde oder durch Satelliten liefern dafür wertvolle Informationen. Die Vorhersagen lassen sich an den Messdaten überprüfen und werden so ständig zuverlässiger.

Unmerkliche Unterschiede mit unvorhersehbaren Konsequenzen

Das Wetter ist nicht nur nichtlinear – es ist vielmehr ein chaotisches System! Man kann also schon nach relativ kurzer Zeit nicht mehr genau auf den Zustand zu Beginn zurückschließen. Kleine Störungen wie lokaler Regenfall können rapide anwachsen und sich schnell auf die Großwetterlage auswirken. Beim Klima verhält sich das genauso. Chaotische Systeme reagieren höchst sensibel auf Änderungen, solange man ihnen genug Zeit gibt. Das ist allgemein als Schmetterlingseffekt bekannt: Ob ein Tornado in Texas entsteht oder nicht, könnte an so einem kaum merklichen Unterschied in den Anfangsbedingungen wie dem Flügelschlag eines Schmetterlings in Brasilien einige Tage zuvor liegen. Die Analogie stammt vom US-Mathematiker und Meteorologen Edward N. Lorenz (1917–2008) und verdeutlicht das Prinzip, nach dem die Auswirkungen winziger Störungen auf lange Sicht nicht mehr vorauszusagen sind. Ein anderes Beispiel kommt aus der Sciencefiction, wo minimale Veränderungen bei Zeitreisen katastrophale Folgen haben – das Zertreten eines Baumsetzlings lässt einen ganzen Wald verschwinden. Die Konsequenz: Selbst mit den besten Modellen, Supercomputern und Messdaten ließe sich das stündliche Wetter in den meisten Fällen nur etwa zwei Wochen weit voraussagen. Tatsächlich können wir mit unseren momentanen Methoden derzeit im Schnitt etwa fünf bis sieben Tage recht verlässlich in die Zukunft schauen.

Wenn Wettervorhersagen schon nach einigen Tagen scheitern, welchen Sinn haben dann Klimamodelle, die viel größere Zeiträume überblicken sollen? Dort ist das Ziel jedoch nicht, das Wetter an einem bestimmten Tag und Ort in ferner Zukunft vorherzusagen. Vielmehr geht es um statistische Eigenschaften. Über mehrere Monate und Jahre soll in den Simulationen die gleiche Anzahl an regnerischen und sonnigen Tagen, Stürmen, Schneefällen und so weiter vorkommen wie in der Wirklichkeit. Das muss gerade auch dann der Fall sein, wenn sich das Klima durch äußere Einflüsse wie einen steigenden Gehalt von Kohlendioxid in der Atmosphäre oder wechselnde Sonneneinstrahlung verändert. Dabei ist nicht mehr wichtig, ob die Realität und das Modell synchron laufen, also zum gleichen Zeitpunkt das gleiche Ereignis geschieht. Beim Klima interessiert uns nicht, ob es am 23. August 2050 regnet. Vielmehr wollen wir wissen, wie stark sich beispielsweise der Niederschlag im Zeitraum zwischen 2040 und 2060 verglichen mit 1990 bis 2010 ändern wird. Der Unterschied zwischen Wetter- und Klimavorhersagen liegt also gerade im Betrachten der Ereignisse als Statistiken. Die Fragestellung ist eine andere, aber die Phänomene und das physikalische System, das wir beschreiben wollen, sind die gleichen.

Die Simulationen selbst gehen zurück auf grundlegende Gesetze der Physik. Die Bewegungen und die Temperatur in unserer Atmosphäre oder den Ozeanen, die Luftfeuchtigkeit oder der Salzgehalt des Wassers, all das lässt sich mit partiellen Differenzialgleichungen beschreiben. Diese geben nicht die tatsächliche Temperatur oder Windgeschwindigkeit an, sondern vielmehr, wie sich die einzelnen Eigenschaften ändern – mit der Zeit oder auch in Bezug auf eine andere physikalische Größe.

Solche Zusammenhänge werden mit Ableitungen beschrieben: Die zeitliche Ableitung des Orts eines fahrenden Autos ergibt beispielsweise seine Fahrgeschwindigkeit, eine Strecke pro Zeit. Fährt das Auto schneller, wird sie größer. Zur Geschwindigkeit gibt es wiederum eine zeitliche Ableitung, nämlich die Beschleunigung. Das ist also die Rate, mit der sich die Geschwindigkeit ändert. Solche Arten zeitlicher Ableitungen gibt es beim Klima für Windgeschwindigkeiten und für weitere wichtige Größen wie Luftfeuchtigkeit, ozeanischen Salzgehalt, Temperatur und atmosphärischen Druck. Die Gleichungen heißen partiell, weil darin neben den zeitlichen auch ortsabhängige Ableitungen vorkommen. Die Steigung einer Straße ist die Ortsableitung ihrer lokalen Höhe – pro zurückgelegtem Meter gelangt man der Steigung entsprechend einen gewissen Wert aufwärts.

In vielen mathematischen Modellen der Physik tauchen partielle Differenzialgleichungen auf. Deren Lösungen stellen näherungsweise die tatsächlichen Zustände zu einem bestimmten Zeitpunkt an einem bestimmten Ort dar. In die Modellierung fließen bekannte Gesetze der Physik ein, etwa das wichtige Prinzip der Masseerhaltung. Demnach geht Masse nicht einfach so verloren. Ändert sie sich an einem Ort, muss etwas von außen hinzugekommen oder weggenommen worden sein. So füllt sich eine Badewanne nicht von selbst. Erst wenn der Hahn aufgedreht ist, fließt Wasser hinein. Zieht man den Stöpsel, läuft es ab. Der Pegel steigt insgesamt, wenn weniger aus der Wanne heraus- als hineingelangt. Nach dem Gesetz der Masseerhaltung ändert sich der Wasserpegel also nur dann, wenn es Quellen oder Senken gibt. Derartige fundamentale Regeln beschreiben ebenso die Veränderungen in der Atmosphäre und den Ozeanen. Sie werden mit sehr komplizierten Systemen von partiellen Differenzialgleichungen modelliert.

Im Alltag sind wir nicht so sehr daran interessiert, wie sich das Wetter langsam wandelt, sondern wie es morgen tatsächlich aussieht. Dazu müssen die partiellen Differenzialgleichungen des zu Grunde liegenden Modells gelöst werden. Das bedeutet: Aus Gleichungssystemen mit zeitlichen und örtlichen Änderungen einer physikalischen Größe wird etwas berechnet, mit dem wir den Wert der Größe an einem beliebigen Ort und zu einem beliebigen Zeitpunkt näherungsweise ermitteln können. Die Lösung von partiellen Differenzialgleichungen birgt sehr häufig große mathematische Herausforderungen. Eine grundlegende Lösungsmethode ist die Integration. Dabei werden etwa zeitliche Änderungen über beliebig kleine Zeitabschnitte aufsummiert. Kennt man die Geschwindigkeit eines Fahrzeugs auf einem Streckenabschnitt, so kann man bereits beim Start den genauen Ort vorhersagen, den es nach einer bestimmten Zeit erreichen wird.

Ähnlich kann man sich das bei den atmosphärischen und ozeanischen Größen vorstellen. Dort beruhen die Differenzialgleichungen der Modelle zwar auf relativ einfach verständlichen physikalischen Grundgesetzen, allerdings sind die Gleichungen sehr kompliziert. Eine Lösung mit Papier und Bleistift ist unmöglich, vielmehr wird sie mit mathematischen Algorithmen auf leistungsfähigen Computern numerisch berechnet. Das liefert etwa für einen Zeitpunkt und einen Ort eine Näherung an die Temperatur, die Windgeschwindigkeit und andere wichtige Größen.

Eine Grundtechnik zu so einer numerischen Lösung heißt Diskretisierung. Die Differenzialgleichungen der jeweiligen Modelle beschreiben die Änderungen der physikalischen Zustandsgrößen kontinuierlich, zu jeder Zeit an jedem Ort. Die Diskretisierung macht daraus kleine Zeitintervalle beziehungsweise räumliche Teilstücke. Die Lösungen der Differenzialgleichungen werden nun an bestimmten Zeit- und Ortspunkten der Diskretisierung näherungsweise dargestellt. Beispielsweise ließe sich die zeitliche Änderung einer Strömung stundenweise beschreiben. Dann enthält die Diskretisierung bezüglich der Zeit pro Tag 24 Teile. Gleichermaßen lässt sich die ganze Erde in einzelne Zellen gliedern, die jeweils viele Kilometer Durchmesser haben. Das spannt ein Netz – wir sagen auch Gitter – über den gesamten Globus. An dessen Schnittpunkten, den Knoten, werden die Gleichungen numerisch gelöst. Dabei ist die Feinheit der Unterteilung wichtig: Sehr kleine Zeitschritte und eng gespannte Gitter der örtlichen Punkte benötigen unermesslich viel Rechenleistung, liefern aber auch genauere Ergebnisse.

Die Kunst der richtigen Auflösung

Die numerischen Algorithmen werden auf Supercomputern ausgeführt – auf dem diskreten Gitter, so als säße an jedem Knoten ein Mensch, der für seinen speziellen Ortspunkt die Berechnungen übernimmt. Dafür reicht es jedoch nicht, zu wissen, was an dem Knoten selbst gerade passiert. Zusätzlich muss klar sein, was kurz zuvor dort geschehen ist und was an den Orten in der Umgebung vorgeht. Schließlich beinhalten partielle Differenzialgleichungen sowohl zeitliche als auch örtliche Ableitungen, also Änderungen in Zeit und Ort. Ein Anstieg der Temperatur lässt sich nur berechnen, wenn der vorherige Wert bekannt ist. Zudem muss man das Geschehen an benachbarten Knoten kennen, um vorhersehen zu können, ob demnächst vielleicht ein Wolkenfeld heranzieht. Das tun wir ganz automatisch beim Blick auf Radaraufnahmen in der Wetter-App auf dem Smartphone: Wer daran interessiert ist, ob er demnächst nass wird oder nicht, extrapoliert, wohin die Wolken wohl getrieben werden, basierend auf dem, was zuvor und an anderer Stelle geschehen ist. Jeder von uns macht das ebenso bei fahrenden Autos vor dem Überqueren der Straße. In solchen Fällen integrieren wir im Kopf mit der abgeschätzten Geschwindigkeit über die Zeit.

Die numerischen Verfahren der Diskretisierung brechen nun die Ableitungen in den Differenzialgleichungen herunter – auf eben solche zeitlichen und örtlichen Nachbarschaftsverhältnisse auf dem diskreten Gitter und in diskreter Zeit. Mathematiker sagen, sie approximieren die Ableitungen, das heißt, sie nähern sie an. Je kleiner die Schritte werden und je feiner das Gitter ist, desto exakter löst der Computer die Gleichungen. Das ist in gewisser Hinsicht wie bei einem digitalen Foto, das immer schärfer wird, je mehr Pixel zur Verfügung stehen. Bei einer grob aufgelösten Aufnahme bilden sie den Mittelwert aus den Farbdetails, die eigentlich innerhalb des Bildpunkts liegen. Die feinen Strukturen gehen dann verloren, das Gesamtbild ist dennoch zu erkennen.

In der Klimamodellierung ist es leider noch etwas komplizierter. Während einem Foto unabhängig von der Auflösung ein und dasselbe Motiv zu Grunde liegt, wandeln sich bei Klimamodellen ständig die Details innerhalb einer Zelle des Gitters. Schließlich entwickelt sich das Wetter unentwegt fort. Die Einzelheiten, die zu klein sind, um gesehen zu werden, ändern sich aber nicht einfach nur mit der Zeit. Sie beeinflussen außerdem die größeren Prozesse. Wie bei der Metapher vom Schmetterlingseffekt können sich selbst unscheinbare Phänomene schließlich auf große oder weit entfernte Vorkommnisse auswirken. Das Aufteilen der Welt in ein diskretes Gitter jedoch ignoriert all die kleinen Prozesse, die gewissermaßen durch das Netz fallen.

Ein großer Teil der Arbeit in unserem Forschungsgebiet besteht darin, die Auswirkungen der winzigen Prozesse nachträglich in die Gleichungen einzubauen. Dabei bedienen sich Klimamodellierer verschiedener Methoden. Sie nutzen theoretisches Wissen aus der Physik und Mathematik und leiten daraus zum Beispiel die weiter reichenden Konsequenzen von kleineren Strömungen im Ozean oder in der Atmosphäre her. Messungen in der realen Welt helfen ihnen, die Prozesse und ihre Wechselwirkungen besser zu verstehen. Dann stellen sie neue Gleichungen auf, die den Effekt der kleinen Vorgänge imitieren.

Das Ergebnis sind »Parametrisierungen« – das heißt mathematische Zusammenhänge, die auf einstellbaren Parametern beruhen. Diese sind so etwas wie Regulierschrauben für den entsprechenden Prozess und bringen das Modell näher an die Beobachtungen heran. Je besser die zusätzlichen Gleichungen sind und je geschickter deren Parameter justiert sind, desto zuverlässiger bezieht das Modell die kleinen Prozesse mit ein, die sonst durch das Gitter gefallen wären. Und da unser Klimasystem so eng verwoben ist und sich Vorgänge auf allen Skalen aufeinander auswirken, ist es wichtig, selbst jene näherungsweise zu beschreiben, die eigentlich nicht mehr sichtbar sind.

Eine Frage der Balance aus Genauigkeit und Aufwand

Parametrisierungen sind allerdings immer eine mögliche Fehlerquelle. Wir haben also einerseits die Diskretisierung, die sich mit numerischen Verfahren der Wirklichkeit nur annähert, und andererseits die Parametrisierungen, die ebenso die realen Prozesse lediglich approximieren. Am Ende kommt es auf eine Balance an. Eine höhere Auflösung, also ein feineres Gitter für das Modell, verkleinert sowohl numerische Fehler als auch solche der Parametrisierung. Das bildet mehr Prozesse tatsächlich ab und teilt Zeit und Raum in genauere Intervalle auf. Aber das ist kostspielig. Die Berechnungen benötigen mehr Zeit und immer größere und stärkere Computer.

Darum wägen alle Beteiligten zwischen Genauigkeit und Aufwand ab. Derzeit nutzen Klimamodelle eine örtliche Auflösung von einigen Dutzend Kilometern. Da sie über mehrere Jahrzehnte in die Zukunft schauen sollen, wären feinere Gitter hier derzeit oftmals zu teuer. Wettermodelle hingegen, deren Prognosen nur wenige Tage weit reichen müssen, rechnen inzwischen auf Gittern, deren Knoten weniger als zehn Kilometer voneinander entfernt sind.

Ein aufwändiges Unterfangen

Klima- und Wettersimulationen laufen auf Großrechnern. Um sie durchführen zu können, müssen Forschungsinstitute meist Zeit auf den Supercomputern beantragen. Diese bestehen aus Zehntausenden oder Hunderttausenden von miteinander verbundenen Prozessorkernen. Sie führen die entsprechenden Berechnungen parallel durch.

Die Anzahl der Kerne und der benötigte Zeitraum, um zum Beispiel ein Jahr zu simulieren, hängen von Faktoren wie der Komplexität, der Anzahl an Klimakomponenten und der Auflösung ab. Klimasimulationen mittlerer Auflösung zwischen 25 und 100 Kilometern für Ozean und Atmosphäre benötigen einige tausend Prozessorkerne und schaffen zwischen einem und zehn Simulationsjahre pro realem Tag. Für die oftmals gewünschten virtuellen Jahrhunderte vergehen so in Wirklichkeit zum Teil Wochen – vorausgesetzt, der Supercomputer wird in der Zeit nicht außerdem intensiv von anderen Forschergruppen genutzt.

Für künftige Simulationen mit einem etwa ein Kilometer großen Gitter, das Wolken explizit auflöst, wären 15 Milliarden Gitterpunkte allein für die Atmosphäre nötig. Hinzu kämen andere grundlegende Komponenten wie der Ozean. Dafür bräuchten die Supercomputer eine Leistung im Bereich von Exaflops. Flops (englisch für floating point operations per second) bezeichnen eine Operation wie Multiplikation oder Addition zweier Dezimalzahlen pro Sekunde. Zum Vergleich: Optimierte Grafikkarten in kommerziellen Computern erreichen heute eine Leistung in der Größenordnung von zehn Teraflops, das sind zehn Millionen Millionen solcher Operationen pro Sekunde. Exaflops wiederum sind Millionen von Teraflops. Das übersteigt momentan die Kapazitäten selbst der schnellsten und größten Supercomputer der Welt.

Neu konzipierte Prozessorkerne und deren stetig anwachsende Parallelisierung sollten bald dorthin führen. Allerdings sind Supercomputer in der Anschaffung und im Unterhalt enorm kostspielig – allein die Stromrechnung kann sich auf Millionen Euro im Jahr belaufen, zudem ist die Kühlung zunehmend aufwändig. Nicht zuletzt muss die Unmenge an gelieferten Daten noch gespeichert, verwaltet und ausgewertet werden.

Außerdem werden je nach Blickwinkel andere Teile des Klimas interessant. Die Forschenden fragen sich: Spielt eine gewisse Komponente – der Ozean, die Biosphäre oder die großen polaren Eisschilde – eine Rolle für den Zeitraum, den wir betrachten wollen? Innerhalb von ein paar Tagen ändert sich kaum etwas an der Bewaldung oder den Gletschern; nach ein paar Monaten oder Jahren sieht das durchaus anders aus. Bei langfristigen Klimavorhersagen müssen Vorgänge mit in Betracht gezogen werden, die bei Wetterprognosen kaum von Bedeutung sind. Dazu gehört auch der von Menschen verursachte Anstieg der Kohlendioxidkonzentration in der Atmosphäre.

Aus der Sicht der angewandten Mathematik spielt die Weiterentwicklung der numerischen Algorithmen, mit denen die Modellgleichungen gelöst werden, eine zentrale Rolle. Bei der Bewertung steht vor allem die Leistungsfähigkeit der Algorithmen sehr kritisch auf dem Prüfstand. Sie sollen stabiler, effizienter und zuverlässiger werden.

Stabile Algorithmen machen die Berechnungen robuster, das heißt weniger empfindlich gegenüber Störungen durch ungenaue oder unsichere Daten, etwa durch Messfehler. Effiziente Algorithmen reduzieren die erforderliche Rechenzeit, während sich die Zuverlässigkeit daran bemisst, wie genau die Prognosen ausfallen.

Genauere Vorhersagen erfordern jedoch feinere Diskretisierungen, was wiederum die Rechenzeiten erhöht. Daher konkurrieren Effizienz und Genauigkeit – effizientere Algorithmen sollten eher weniger Gitterpunkte verwenden, genauere tendenziell mehr.

Um in diesem Dilemma zu vermitteln, verwenden problemangepasste Algorithmen unregelmäßig verteilte Gitterpunkte. Diese konzentrieren sich um Regionen, in denen höhere Auflösungen nötig sind, wie entlang von Küsten. Zugleich werden großflächige Bereiche, die für die Prognosen gegebenenfalls weniger interessant sind, gröber aufgelöst. Solche Algorithmen heißen adaptiv; leistungsfähige Versionen von ihnen zu konstruieren, ist oft eine schwierige Aufgabe.

Angesichts der rapide steigenden Komplexität in den numerischen Simulationen werden – neben immer größeren und teureren Rechenmaschinen – intelligente und lernbasierte Algorithmen zunehmend wichtig. Aktuelle Entwicklungen des maschinellen Lernens steigern bereits heute die Leistung bei verschiedensten Anwendungen enorm. In Zukunft wird die mathematische Datenanalyse eine entscheidende Rolle spielen, wenn es um bedeutsame Fragen der Plausibilität, der Kausalität und der Zuverlässigkeit von Vorhersagen geht – auch für bessere Klimaprognosen.

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.