Deep Learning: Wie Maschinen lernen lernen

Vor drei Jahren knöpften sich die Forscher des notorisch öffentlichkeitsscheuen Google X Labs die Datenbanken von Youtube vor und extrahierten gut zehn Millionen Standbilder. Die Aufnahmen fütterten sie anschließend in das "Google Brain" – ein Netzwerk aus 1000 Computern, das wie ein Kleinkind Informationen aller Art in sich aufsaugen soll. Drei Tage lang brütete es über den Bildern, suchte nach wiederkehrenden Mustern und entschied schließlich, dass sich die Bilderflut in eine Anzahl von Kategorien einteilen lässt: menschliche Gesichter, menschliche Körper und … Katzen [1].

Die Erkenntnis, dass das Internet voller Katzen ist, sorgte nicht nur für viel Heiterkeit unter Journalisten, sondern bewies auch eindeutig, dass das "Deep Learning" zurück ist. Dabei hat die Technik inzwischen gut drei Jahrzehnte auf dem Buckel. Doch mit Hilfe enormer Datenmengen und massiver Rechenpower soll sie nun schaffen, woran andere Ansätze scheitern – und was Menschen beinahe nebenher erledigen: Gesichter erkennen, Sprache verstehen und ganz allgemein unscharf definierte Probleme lösen.

Deep Learning war bereits selbst eine Wiederbelebung noch älterer Technik, nämlich der künstlichen neuronalen Netze. Diese Rechenverfahren orientieren sich grob an der Arbeitsweise des Gehirns und simulieren dazu ein dicht verwobenes Netz aus einfachen Nervenzellen. Wie ihr natürliches Vorbild lernen sie aus der Erfahrung, indem sie die Stärke der simulierten Neuronenverbindungen passgenau ändern.

Mit etwa einer Million simulierter Neurone und einer Milliarde simulierter Verbindungen übertraf das Google Brain im kalifornischen Mountain View jedes frühere Kunstnetzwerk um das Zehnfache. Inzwischen plant der Gründer des Projekts Andrew Ng, sogar noch einmal um den Faktor zehn aufzustocken.

Beim Deep Learning reiht sich bislang Erfolg an Erfolg

Es scheinen also spannende Zeiten anzubrechen in der künstlichen Intelligenz (KI). Nachdem der Versuch, Computer wie Menschen denken zu lassen, jahrzehntelang frustrierende Ergebnisse brachte, lassen Softwareriesen wie Google, Apple oder IBM zurzeit kaum eine Chance aus, sich Start-ups einzuverleiben oder Wissenschaftler an sich zu binden, die Expertise im Bereich Deep Learning mitbringen.

"In der Geschichte der KI reiht sich Misserfolg an Misserfolg, aber dazwischen gab es immer wieder entscheidende Fortschritte", meint einer der Pioniere des Deep Learning, Yann LeCun, derzeit Direktor des Center for Data Science der New York University, "mit einem solchen Sprung nach vorn können wir es hier zu tun haben."

"In den nächsten Jahren werden wir eine Art Rausch erleben", pflichtet ihm Jitendra Malik bei. "Eine Menge Leute werden auf den Deep-Learning-Zug aufspringen", so der Experte für computergestützte Bilderkennung an der University of California in Berkley. Doch auf lange Sicht sei Deep Learning womöglich nicht der Weisheit letzter Schluss. Andere Ansätze hätten ebenfalls Potenzial. "Ich bin da ganz undogmatisch", sagt Malik. "Mit der Zeit werden wir schon herausfinden, was in welcher Situation am besten funktioniert."

"Eine Menge Leute werden auf den Deep-Learning-Zug aufspringen"Jitendra Malik

In den 1950er Jahren, als Computer noch ganz neu waren, sah die erste Generation der KI-Forscher den denkenden Computer praktisch schon vor der Tür stehen. Doch der Optimismus verflüchtigte sich rasch, als sich zeigte, wie unerhört komplex es ist, das menschliche Alltagswissen abzubilden – insbesondere bei Wahrnehmungsaufgaben: Was macht ein menschliches Gesicht aus? Wie unterscheidet es sich von einer Maske oder dem Gesicht eines Affen? Hunderte von Entwicklern und Studenten verbrachten Jahrzehnte damit, per Hand all die Regeln einzutippen, die Computer brauchen könnten, um Gegenstände anhand ihrer Merkmale zu unterscheiden. "Sich Merkmalssätze auszudenken, ist schwierig, zeitaufwändig und verlangt nach viel Fachwissen", sagt Ng, der inzwischen das Artificial Intelligence Laboratory an der Stanford University leitet, "da muss man sich natürlich die Frage stellen: Gibt es keinen besseren Weg?"

Künstliche Neurone in vielen Ebenen

In den 1980er Jahren bestand dieser bessere Weg vor allem darin, das Lernen den künstlichen neuronalen Netzen zu überlassen. Diese hatten die viel versprechende Eigenschaft, ihre eigenen Regeln von Grund auf selbst zu lernen. Und als i-Tüpfelchen gab es die schöne Analogie zum Gehirn: ein biologisch inspiriertes Verfahren, das die Fähigkeiten des Gehirns nachbildet.

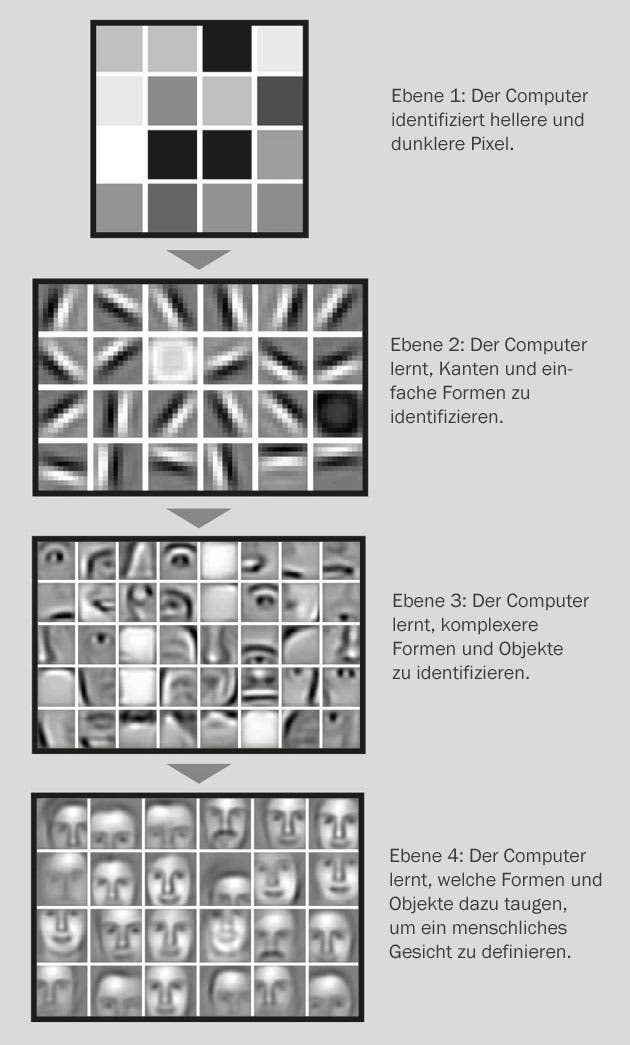

Im Wesentlichen sieht der Ansatz vor, künstliche Neurone in mehrere Ebenen einzuteilen. Gilt es beispielsweise ein Bild zu erkennen, registrierten etwa die Einheiten der ersten Ebene lediglich Helligkeitswerte der Pixel. Die nächste Ebene wiederum würde erkennen, dass einige der Pixel zu Kanten verbunden sind, woraufhin die darauffolgende zwischen horizontalen und vertikalen Linien unterscheidet – und so weiter, bis schließlich eine Ebene erreicht wird, in der die Neurone Augen auseinanderhalten können, und das System weiß, dass in einem Gesicht typischerweise zwei davon auftauchen.

Unglücklicherweise hätten die ersten Deep-Learning-Programme kaum besser abgeschnitten als simpler gestrickte Varianten neuronaler Netze, erklärt Malik. Und sie waren vertrackt in der Anwendung. "Mit neuronalen Netzen umzugehen, war schon immer eine Kunst für sich. Ohne hie und da ein bisschen schwarze Magie einzusetzen, geht es manchmal nicht", sagt der Forscher. Vor allem brauchen die Netze Unmengen von Daten, um zu lernen – genau wie ein Baby, das pausenlos Informationen aus der Umwelt aufnimmt. Nur gab es in den 1980er und 1990er Jahren nicht viel digitalisiertes Material, und selbst das Wenige, das verfügbar war, überforderte die Rechner von damals. Auch Anwendungsmöglichkeiten waren dünn gesät. Eine der wenigen mündete – dank der Arbeit von LeCun – in ein System, mit dem Banken auch heute noch handgeschriebene Schecks auswerten.

"Deep Learning war wie zehn Durchbrüche auf einmal"Geoffrey Hinton

Mit Beginn des neuen Jahrtausends sahen jedoch einige Verfechter des Netzwerkansatzes, darunter LeCun und sein ehemaliger Betreuer Geoffrey Hinton von der University of Toronto, die Zeit gekommen für einen neuen Anlauf. Steigende Rechenleistung und das dramatische Anwachsen digitaler Datenbestände sollten dem Deep Learning eine neue Chance geben. "Wir wollten der Welt zeigen, dass neuronale Netze doch zu etwas nütze sind", sagt George Dahl, ein Mitarbeiter aus Hintons aktueller Forschungsgruppe.

Zum Einstieg nahmen sich Hinton, Dahl und einige Kollegen das schwierige, aber kommerziell interessante Problem der Spracherkennung vor. Im Jahr 2009 meldeten sie Erfolg: Nachdem sie ihre Software anhand eines Standarddatensatzes – drei Stunden Tonaufnahmen mitsamt der zugehörigen Transkription – trainiert hatten, konnte ihr Programm genauer Sprache in geschriebenen Text übersetzen als sämtliche Vorgänger [2]. Diese waren auf regelbasierten Systemen aufgebaut und erreichten über zehn Jahre hinweg nur marginale Verbesserungen ihres eigenen Rekords.

Deep Learning in Android und Siri

Das Ergebnis habe die großen Namen in der Smartphonebranche aufhorchen lassen, erzählt Dahl, der mit der Technik im Rahmen eines Praktikums zu Microsoft ging. "Innerhalb von ein paar Jahren sind alle auf Deep Learning umgestiegen." So basiert beispielsweise das Spracherkennungsmodul von Siri, dem digitalen Assistenten auf dem iPhone, auf Deep-Learning-Verfahren.

Als Google die Spracherkennung für sein Android-Betriebssystem damit ausstattete, sank die Fehlerquote um 25 Prozent. "Für einen solchen Rückgang hätte man früher zehn Jahre Entwicklungszeit veranschlagen müssen", meint Hinton – eben weil es so schwer war, Fortschritte zu erzielen. "Deep Learning war wie zehn Durchbrüche auf einmal."

Währenddessen hatte Ng die Google-Entwickler dazu gebracht, ihm Daten und Computer zur Verfügung zu stellen, und ein Projekt ins Leben gerufen, aus dem schließlich Google Brain entstand. Dessen bemerkenswerte (wenn auch kommerziell kaum verwertbare) Fähigkeit, auf Bildern Katzen zu erkennen, belegte eindrucksvoll, dass ein solches System zum so genannten unüberwachten Lernen taugt – der schwierigsten Variante des Problems, bei der die Programme ohne jegliche Zusatzinformation in Form von Namen, Überschriften oder Kategorien auskommen müssen.

Wie Ng erzählt, begann er sich aber immer mehr daran zu stören, dass kaum jemand außerhalb von Google über die notwendigen Ressourcen verfügte, um das Feld voranzutreiben. "Nach Vorträgen kamen Studenten zu mir und sagten: 'Wir haben hier leider keine tausend Computer herumliegen. Können wir überhaupt irgendetwas damit anfangen?'" Zurück in Stanford machte sich Ng daher daran, größere und vor allem billigere Deep-Learning-Netzwerke zu bauen. Dazu griff er auf Prozessoren von Grafikkarten (GPUs) zurück – ultraschnelle Chips, die ursprünglich speziell für Computerspiele auf dem heimischen PC entwickelt wurden [3]. In die gleiche Richtung gingen auch andere Forschergruppen. "Inzwischen können wir für etwa 100 000 US-Dollar Hardwarekosten und mit 64 GPUs ein Netz aus elf Milliarden Verknüpfungen bauen", sagt Ng.

Das alles genügte jedoch nicht, um in den Augen derjenigen Kollegen zu bestehen, die herkömmliche Bildverarbeitungsverfahren favorisierten. Es fehlte der Vergleich in standardisierten Tests. Wie sich Jitendra Malik erinnert, habe ihn Hinton einmal gefragt: "Du als Skeptiker – was würde dich überzeugen?" Woraufhin Malik meinte, Hinton solle doch einfach den international renommierten ImageNet-Wettbewerb gewinnen. Dann würde er es sich überlegen.

Bei dieser Veranstaltung trainieren die einzelnen Teams ihre Programme anhand von Datenbanken mit rund einer Million Bildern, die alle per Hand in Kategorien eingeteilt wurden. Anschließend gilt es, ähnliche Bilder, die die Software allerdings nie zuvor gesehen hat, in die jeweils passende Kategorie zu schieben. Pro Testbild darf der Computer fünf Tipps abgeben, fehlt die richtige Antwort, zählt der Durchlauf als Fehler – rund 25 Prozent solcher Fehler machten die Gewinner der vergangenen Jahre im Schnitt.

Im Jahr 2012 nahm mit der Software aus Hintons Team erstmals ein Deep-Learning-Programm am Wettbewerb teil und erreichte prompt eine Fehlerquote von 15 Prozent [4]. "Deep Learning hat alle anderen buchstäblich plattgemacht", sagt LeCun, der nicht Mitglied des Gewinnerteams war. Der Erfolg bescherte Hinton eine Teilzeitstelle bei Google, und im Mai 2013 integrierte die Firma das Programm in ihre Bildersuche bei Google+.

Auch Malik erklärte sich für überzeugt: "In der Wissenschaft sollte man sich nur durch empirische Belege umstimmen lassen, und das war deutlich." Inzwischen hat er selbst die Technik eingesetzt und dadurch bei einem anderen Wettbewerb den Rekord gebrochen [5]. Andere taten es ihm gleich: Im Jahr nach Hintons Sieg nutzten sämtliche Teilnehmer beim ImageNet-Wettbewerb einen Deep-Learning-Ansatz.

Automatische Sprachverarbeitung mit Deep Learning

Der durchschlagende Erfolg legte nahe, die Technik auch auf das Verstehen von Sprache anzuwenden, also Software zu entwickeln, die Anfragen in natürlicher Sprache umformulieren oder sogar beantworten und von einer Sprache in die andere übersetzen kann. Auch hier bestand das altbewährte Konzept darin, Regeln per Hand zu kodieren und bekannte Texte statistisch zu analysieren. Von der Leistungsfähigkeit der derzeit besten Programme kann sich jeder überzeugen, der den Google-Übersetzer aufruft. Dessen Resultate sind – so komisch sie meist klingen – immerhin einigermaßen verständlich. Doch von den Ergebnissen eines geübten Übersetzers sind sie noch meilenweit entfernt.

"Mit Deep Learning besteht die Chance, etwas viel besseres auf die Beine zu stellen", sagt der Crowdsourcing-Experte Luis von Ahn. In seiner Firma Duolingo in Pittsburgh lässt er Übersetzungsaufgaben noch immer ganz konventionell von Menschen und nicht von Computern erledigen. "Schließlich gibt es eine Sache, bei der sind sich alle einig: Dass es Zeit ist, etwas grundlegend anderes auszuprobieren."

Inzwischen wurde Deep Learning auch für eine Anzahl wissenschaftlicher Aufgaben herangezogen. "Deep nets sind ziemlich gut darin, in Datenmengen Muster zu finden", sagt Hinton. 2012 lobte die Pharmafirma Merck einen Preis für denjenigen aus, dessen Software ihre eigenen Programme bei der Suche nach viel versprechenden Wirkstoffkandidaten übertrumpfen könne. Die Aufgabe bestand darin, Datenbanken mit mehr als 30 000 kleinen Molekülen zu durchforsten, zu denen jeweils einige tausend chemische Eigenschaften verfügbar waren, und auf dieser Grundlage vorherzusagen, wie eine Substanz mit 15 verschiedenen Zielmolekülen interagieren würde. Mit Hilfe ihres Deep-Learning-Systems gewannen Dahl und Kollegen die versprochenen 22 000 Dollar. "Wir übertrafen die zu Grunde gelegten Programme von Merck um etwa 15 Prozent", sagt der Forscher.

Wissenschaftler profitieren von Deep Learning

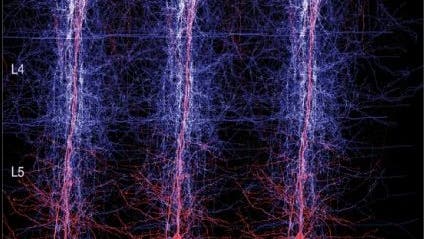

Biologen und Bioinformatiker wie Sebastian Seung vom Massachusetts Institute of Technology nutzen das Verfahren hingegen, um dreidimensionale Aufnahmen von Gehirnschnitten zu erstellen. Solche Bilder offenbaren ein extrem dichtes Gewirr von Nervenverbindungen, die nachverfolgt und kartiert werden müssen, eine Aufgabe, die in der Vergangenheit von Studenten erledigt wurde. Doch sollen eines Tages größere Ausschnitte des Gehirns aufbereitet werden, kommen die Forscher um eine Automatisierung nicht herum. Nur so lassen sich die Milliarden von Nervenzellauswüchsen bewältigen, aus denen das Gehirn besteht. Und wiederum erscheint Deep Learning am vielversprechendsten. So nutzt Seung zurzeit ein solches System, um die Neurone in einem Ausschnitt der Netzhaut zu kartieren. Ob das Programm die richtigen Antworten lieferte, wird der anschließende Vergleich mit den Ergebnissen von EyeWire zeigen, einem crowdsourcingbasierten Internetspiel, bei dem Teilnehmer die Verbindungen per Hand ermitteln.

Der Informatiker William Stafford Noble von der University of Washington in Seattle bringt mit Hilfe von Deep Learning seinem Computer bei, aus einer vorgegebenen Aminosäuresequenz auf die Struktur des daraus entstehenden Proteins zu schließen – ob beispielsweise bestimmte Abschnitte der Sequenz einen Ring oder eine Spirale bilden oder wie gut Lösungsmittel in die Zwischenräume der Struktur kriechen können. Bislang hat Noble sein Programm nur auf Basis einer kleinen Datenmenge trainiert, in den kommenden Monaten will er sich jedoch der Protein Data Bank zuwenden, einem internationalen Verzeichnis von derzeit rund 100 000 Strukturen.

Mit Deep Learning dürften sich überdies ganz erhebliche Profite machen lassen: Dahl beispielsweise denkt über die Möglichkeit einer Start-up-Gründung nach, und LeCun wurde kürzlich zum Leiter einer neuen KI-Abteilung bei Facebook ernannt. Deep Learning könnte die künstliche Intelligenz endlich praktikabel und kommerziell verwertbar machen. "Es hat die nützliche Eigenschaft, umso besser zu werden, je mehr Daten man ihm füttert", bemerkt Ng. "Das können zwar auch andere Verfahren, aber Deep Learning schafft das vermutlich am besten – und sicher am unkompliziertesten. Deshalb ist es so vielversprechend."

Ein KI-Verfahren unter vielen?

Nicht alle Kollegen stimmen jedoch vorbehaltlos zu. Oren Etzioni, der Leiter des kürzlich gegründeten Allen Institute for Artificial Learning in Seattle, hält nicht viel davon, sich am Gehirn als Vorbild zu orientieren. "Ähnlich war es bei der Erfindung des Flugzeugs", sagt er. Die erfolgreichsten Designs seien nicht die gewesen, die die Vögel nachahmten.

Ziel seiner Forschung ist ein Computer, dem stapelweise Lehrbücher zur Verfügung gestellt werden und der davon ausgehend standardisierte Tests auf Grundschulniveau besteht. Danach sollen seine Fähigkeiten schrittweise auf universitäre Eignungsprüfungen hochgeschraubt werden. Allerdings muss der Computer dazu Diagramme lesen und verstehen können – wie genau, sei noch zu entscheiden, sagt Etzioni, aber weder künstliche neuronale Netzwerke noch Deep-Learning-Algorithmen führten die Kandidatenliste an.

Bei einem konkurrierenden Ansatz soll der Computer beispielsweise Schlüsse aus eingegebenen Fakten ziehen, statt diese Fakten ohne Vorgaben selbst zu lernen. Man würde ihn etwa mit Aussagen wie "Alle Mädchen sind Menschen" programmieren. Begegnet ihm dann ein Text, in dem Mädchen erwähnt werden, könnte er auf dieser Grundlage ableiten, dass das fragliche Mädchen ein Mensch ist. Um selbst einfachstes Alltagswissen abzubilden, sind jedoch tausende, wenn nicht gar Millionen entsprechender Fakten vonnöten.

Nach diesem Prinzip funktioniert Watson, ein Computer von IBM, der 2011 beim Fernsehquiz "Jeopardy" seine menschlichen Gegner – allesamt Jeopardy-Experten – überraschend alt aussehen ließ. Trotz dieses Erfolgs experimentieren auch die Entwickler bei IBM Watson Solutions mit Deep Learning, erklärt Rob High, leitender Ingenieur der Firma aus dem texanischen Austin. Er hofft, so die Mustererkennung des Systems verbessern zu können.

Auch Google geht auf Nummer sicher. Obwohl die jüngsten Erfolge bei der Kategorisierung von Bildern auf Hintons Deep-Learning-Algorithmen zurückgehen, haben andere Abteilungen einen breiteren Fokus gewählt. So stellte das Unternehmen im Dezember 2012 den Futuristen Ray Kurzweil an. Er soll mit seinem Team verschiedene Möglichkeiten des Maschinenlernens ausloten, darunter auch Deep Learning. Doch das sei nur einer von vielen Ansätzen. Im vergangenen Mai erwarb Google sogar den Quantencomputer der kanadischen Firma D-Wave. Mit ihm dürften sich vor allem Aufgaben außerhalb der KI – wie etwa komplexe mathematische Berechnungen – leichter abarbeiten lassen. Theoretisch könnte er jedoch auch für Deep Learning eingesetzt werden.

So darf der Erfolg nicht darüber hinwegtäuschen, dass Deep Learning noch in den Kinderschuhen steckt. "Es ist eine Zukunftstechnologie", sagt Dahl, "erstaunlich eigentlich, dass wir bereits so viel mit so wenig erreicht haben." Und das, fügt er hinzu, "wo wir noch nicht einmal richtig angefangen haben."

Dieser Artikel erschien unter dem Titel "The learning machines" in Nature 505, S. 146-148, 2014.

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.