Lexikon der Biologie: Statistik

Statistikw [von griech. statikos = wägend; Adj. statistisch], Wissenschaft, die über Zusammenhänge bei Massenerscheinungen Aussagen macht, angewandt z.B. auf Probleme insbesondere in Gesellschaft, Wirtschaft, Naturwissenschaften und Technik. Viele Vorgänge in unserer Umwelt unterliegen dem Zufall, d.h., es ist nicht möglich vorherzusagen, welchen Ausgang ein einzelnes Ereignis nimmt. Es zeigt sich jedoch, daß man auch über zufällige Ereignisse quantitative Aussagen machen kann, wenn eine hinreichende Anzahl von Zufalls-Experimenten unter gleichbleibenden Bedingungen beobachtet wird. Unter einem Zufallsexperiment wird ein Vorgang verstanden, bei dem verschiedene Ausgänge möglich sind, ohne daß mit Sicherheit angegeben werden kann, welcher Ausgang tatsächlich eintritt (z.B. beim Werfen einer Münze). Die mathematische Statistik ist die Disziplin, die Gesetzmäßigkeiten von Zufallsexperimenten untersucht. – Der Wahrheitsgehalt einer statistischen Aussage ist um so höher, je größer die Zahl der betrachteten Ausgänge eines Zufallsexperiments ist. Eine Größe, die je nach Ausgang eines Zufallsexperiments verschiedene Werte annehmen kann, heißt Zufallsgröße. So ist z.B. ein Vorgang zur Messung der Körpergröße ein Zufallsexperiment, die Körpergröße selbst eine Zufallsgröße. Für die Praxis sind 2 Typen von Zufallsgrößen von besonderer Bedeutung: die diskreten und die stetigen Zufallsgrößen. Wenn eine Zufallsgröße nur endlich viele Werte annehmen kann, ist sie diskret. Bei den meisten diskreten Zufallsgrößen handelt es sich um Anzahlen (Anzahl Erythrocyten/mm3, Anzahl Blütenblätter usw.). Eine Zufallsgröße heißt stetig, wenn sie prinzipiell unendlich viele Werte annehmen kann, die nicht abzählbar sind. Ein Beispiel für eine stetige Zufallsgröße ist die menschliche Körpergröße. Prinzipiell kann die Körpergröße innerhalb gewisser natürlicher Grenzen jeden beliebigen Wert annehmen. Die hier etwas willkürlich erscheinende Einteilung in diskrete und stetige Zufallsgrößen erhält ihre Berechtigung bei der Benutzung statistischer Testverfahren, die in aller Regel nur für stetige Zufallsgrößen anwendbar sind. Auf der Suche nach statistischen Gesetzmäßigkeiten wird immer eine begrenzte Anzahl von Objekten experimentell untersucht. Das Hauptproblem der mathematischen Statistik besteht nun darin, aufgrund von Kenntnissen über eine Teilmenge von Objekten etwas über die entsprechenden Eigenschaften der Gesamtmenge auszusagen. Diese Gesamtmenge wird in der Statistik auch Grundgesamtheit genannt. Wählt man aus dieser Grundgesamtheit eine Anzahl von n Objekten zufällig aus, spricht man von einer Stichprobe vom Umfang n. Äußerst wichtig bei der Auswahl einer Stichprobe ist, daß die Wahl der Objekte unabhängig voneinander zu geschehen hat. – In der deskriptiven (= beschreibenden) Statistik wird das Ergebnis eines Zufallsexperiments durch gewisse Maßzahlen einer Stichprobe gekennzeichnet. Die induktive (= schließende) Statistik behandelt schließlich die Schätzung der tatsächlichen Werte der Grundgesamtheit durch die Stichprobenwerte. Eine Stichprobennahme geht immer einher mit einer „Messung“. Bei jeder Messung werden zwangsläufig Fehler (Meßfehler) gemacht. In der Statistik werden die Fehler, die bei der Datengewinnung gemacht werden, üblicherweise vor allem in 2 Klassen eingeteilt: systematische Fehler und zufällige Fehler ( vgl. Abb. 1 ). Außerdem können bei Messungen grobe Fehler auftreten (dieser Fehlertyp beeinflußt das arithmetische Mittel sehr stark). Systematische Fehler verzerren das Meßergebnis immer in eine bestimmte Richtung; alle Meßwerte werden entweder prinzipiell zu groß oder zu klein gemessen. Ursachen solcher systematischer Fehler sind z.B. falsch geeichte Meßinstrumente (objektiver Fehler) oder falsches Ablesen des Experimentators (subjektiver Fehler) ( vgl. Abb. 2 ). Diese Fehler können durch geeignete Eichung sowie Verwendung unterschiedlicher Meßgeräte und Meßpersonen vermieden werden. Zufällige Fehler können sowohl vergrößernd als auch verkleinernd auf das Meßergebnis wirken und kompensieren sich bei nicht zu kleinem Stichprobenumfang mehr oder weniger. Ein Beispiel: Bei der Bestimmung einer Zufallsgröße ergibt die Messung nicht wie erwartet einen einzigen Wert, sondern die Werte x1, x2,...,xn. Die Problematik besteht nun darin, den „echten“ Wert der Größe aus dieser Stichprobe herauszufinden. Deshalb wird als sog. Schätzer des tatsächlichen Werts das arithmetische Mittel gewählt ( vgl. Tab. und vgl. Infobox ). Diese Wahl eines Mittelwerts zur Schätzung des wahren Werts ist zunächst eine rein empirische Festsetzung. Mit gleichem Recht hätte einer der anderen in der Mathematik typischen Mittelwerte verwendet werden können (geometrisches Mittel, harmonisches Mittel). Desgleichen wäre auch der am häufigsten auftretende Meßwert (Modus) oder schließlich der Wert, der bei einer linearen Anordnung aller Meßwerte nach steigender Größe (Rangfolge) auf dem mittleren Platz steht (Zentralwert oder Median), als Schätzer für den wahren Wert der Zufallsgröße denkbar. Die Entscheidung zugunsten des arithmetischen Mittels beruht zum einen auf der einfachen Berechenbarkeit, zum anderen auf theoretischen Gründen. Wurde mit dem arithmetischen Mittel eine wichtige Kenngröße einer Stichprobe berechnet, dann fallen die tatsächlichen Meßwerte der Stichprobe teils größer, teils kleiner als das arithmetische Mittel aus. Ein Maß für die Güte der Messung sind die Abweichungen der einzelnen Meßwerte vom arithmetischen Mittel. Geringe Abweichungen (große Trefferquote) sprechen eher für eine genaue Messung, große Abweichungen (geringe Trefferquote) eher für eine ungenaue Messung. Würden die Abweichungen in positiver wie in negativer Richtung (größer oder kleiner als das arithmetische Mittel) einfach zusammengezählt, so würden sich die positiven mit den negativen Abweichungen gerade aufheben. Dies liegt an der Natur des arithmetischen Mittels. Um Abweichungen als Gütemerkmal einsetzen zu können, wählt man – einem Vorschlag des deutschen Mathematikers C.F. Gauß folgend – als Streuungsmaß die sog. Standardabweichung ( vgl. Tab . und vgl. Infobox ). Die Standardabweichung ist nicht das einzige, wohl aber das wichtigste Streuungsmaß. Ähnlich der Vielfalt an Möglichkeiten bei der Bildung von mathematischen Mittelwerten, gibt es auch mehrere Möglichkeiten der Festlegung von Streuungsmaßen. So stellt der Abstand zwischen dem kleinsten und dem größten Wert einer Zufallsgröße (Spannweite) ein sehr einfaches Streuungsmaß dar. Ein weiteres Streuungsmaß ist die mittlere (absolute) Abweichung. Ein weiteres, sehr häufig benutztes Streuungsmaß ist das Quadrat der Standardabweichung, die Varianz. Sie kommt als eigene Größe in vielen statistischen Formeln vor und hat gegenüber der Standardabweichung den Vorteil einfacherer Berechenbarkeit ( vgl. Tab .). Neben den oben genannten Kenngrößen zur Charakterisierung der Werteverteilung einer Stichprobe existieren noch weitere Maße, wie z.B. die Kurtosis („Breitgipfligkeit der Verteilung“), die Schiefe („Rechts-/Links-Symmetrie“), Minimum, Maximum, usw. Die Standardabweichung ist als mittlere Abweichung eines Meßwerts vom Mittelwert zu verstehen. Werden die gemessenen Werte einer Zufallsgröße auf mehrere kleinere Gruppen von Stichproben verteilt, so hat jede Stichprobengruppe einen eigenen Mittelwert. Man kann zeigen, daß die Mittelwerte der Stichprobengruppen einer Normalverteilung (s.u.) genügen. Alle Gruppenmittelwerte streuen um einen gemeinsamen Mittelwert. Das Maß, mit dem die einzelnen Gruppenmittelwerte mi um den gemeinsamen Mittelwert M streuen, nennt man den Standardfehler des Mittelwerts ( vgl. Infobox ). Während der tatsächliche Wert der Zufallsgröße M durch das Stichprobenmittel geschätzt wird, schätzt man den Standardfehler dieses Mittels durch sM = sx/√N. Die Größe sx entspricht dabei der Standardabweichung der gesamten Messung (= mittlere Abweichung der Meßpunkte vom Mittelwert) und √N der Quadratwurzel aus der Anzahl N von Meßpunkten. Diese Schätzung der Streuung des Mittelwerts ergibt einen um den Faktor √N genaueren Meßwert als bei Verwendung der Standardabweichung. Die graphische Darstellung der Häufigkeitsverteilung einer diskreten Zufallsgröße heißt Häufigkeitspolygon. Die Werte einer Zufallsgröße können auch in Klassen eingeteilt werden. Dazu werden in einer Häufigkeitsverteilung nicht die Häufigkeiten der einzelnen Werte einer Zufallsgröße betrachtet, sondern die Häufigkeiten ganzer Wertebereiche (z.B. 1. Klasse: alle Werte zwischen 0 und 10, 2. Klasse: alle Werte zwischen 11 und 20, usw.). Wird die Häufigkeitsverteilung einzelner Klassen betrachtet, spricht man von einem Histogramm oder einem Säulenpolygon. Bei stetiger Zufallsgröße heißt die Häufigkeitsverteilung Häufigkeitskurve ( vgl. Abb. 3 ). Wird die Angabe der Häufigkeit, mit der die einzelnen Werte einer Zufallsgröße angenommen werden, durch die relative Häufigkeit (Häufigkeit des Einzelwerts/Gesamtzahl Werte) ersetzt, so hat die Gesamtfläche zwischen Kurve bzw. Polygon und der horizontalen Achse des Häufigkeitsdiagramms stets den Wert 1. Man spricht dann davon, daß die Fläche unter einer Häufigkeitskurve auf 1 normiert ist. Die relative Häufigkeit, mit der ein Ereignis eines Zufallsexperiments eintritt, hängt von der Zahl der Durchführungen des Experiments, also vom Stichprobenumfang n, ab. Sie ist weiterhin abhängig von der Versuchsreihe. Dies bedeutet, daß sich in einer anderen Stichprobe des gleichen Umfangs durchaus eine andere relative Häufigkeit ergeben kann. Nach vielen Durchführungen des Zufallsexperiments, auch in verschiedenen Serien, beobachtet man eine Stabilisierung der relativen Häufigkeiten in Richtung eines festen Grenzwerts. In diesem Zusammenhang wird vom Gesetz der großen Zahlen gesprochen. Bei vielen Stichproben und großem Stichprobenumfang strebt also der Wert der relativen Häufigkeit eines Ereignisses h(xi) gegen die Wahrscheinlichkeit des Ereignisses. Nach der Normierung und bei Betrachtung großer Stichproben hat die Kurvenfläche die mathematische Bedeutung einer Wahrscheinlichkeit ( vgl. Abb. 4 ). Die Erfahrung lehrt, daß bestimmte Typen von Häufigkeitskurven in unserer Umwelt häufiger vorkommen als andere. Zufallsgrößen, die nur 2 mögliche Werte annehmen können, nehmen als Häufigkeitsverteilung die Binomialverteilung an ( vgl. Abb. 5 ). Eine weitere praxisrelevante Verteilung einer Zufallsgröße ist die Poissonverteilung ( vgl. Infobox ). Sie wird oft als Näherung für die Binomialverteilung eingesetzt. Es kann gezeigt werden, daß sich die Binomialverteilung dann stark an die Poissonverteilung annähert, wenn ein Ereignis zwar selten auftritt (Wahrscheinlichkeit p klein), der Stichprobenumfang n jedoch so groß wird, daß das arithmetische Mittel n·p nicht mehr vernachlässigt werden kann. Zufallsgrößen, die näherungsweise einer Poissonverteilung gehorchen, kommen insbesondere in der Biologie (z.B. Genetik) häufig vor. Eine der bedeutungsvollsten Verteilungen der mathematischen Statistik ist die Normalverteilung ( vgl. Abb. 6 und ( vgl. Infobox ). Ihre Rolle in der Statistik gleicht der Rolle der Geraden in der Geometrie, und ihre Bedeutung kann nicht stark genug unterstrichen werden. Obwohl die bisherigen Darstellungen auf die Binomial-, Poisson- und Normalverteilung beschränkt wurden, sollte nicht unerwähnt bleiben, daß es noch viele weitere Verteilungsfunktionen von Zufallsgrößen gibt. Bei Meßvorgängen haben wir es immer mit einer endlichen Auswahl von Meßpunkten zu tun (Stichprobe), die je nach Umfang mehr oder weniger präzise Aussagen über die zugrundeliegende Grundgesamtheit macht. Neben der Beschreibung der charakteristischen Größen einer Stichprobenverteilung behandelt die induktive Statistik die Schätzung der tatsächlichen Werte der zugrundeliegenden Grundgesamtheit. Aus dem Mittelwert m und dem Standardfehler des Mittelwerts sm der Stichprobenverteilung sollen die Kennwerte der Grundgesamtheit geschätzt werden. Die Schätzung der wahren Werte wird um so präziser, je größer der Stichprobenumfang ist. Man schätzt z.B. den Mittelwert μ der Grundgesamtheit mit Hilfe der Stichprobenwerte m, sm und dem sog. Sicherheitsfaktor k ( vgl. Infobox ) durch folgende Ungleichung:

m – ksm< μ< m + ksm

Da statistisch auch Werte für μ vorkommen können, die außerhalb des Konfidenzintervalls (m – ksm, m + ksm) liegen, kann für den geschätzten Wert μ nur eine gewisse Wahrscheinlichkeit angegeben werden, mit der er im angegebenen Intervall auftritt. Die Wahrscheinlichkeit dafür, daß μ außerhalb des angegebenen Intervalls liegt, bezeichnet man als Irrtumswahrscheinlichkeit ( vgl. Abb. 7 ) oder auch als Signifikanzniveau α. Je größer der Sicherheitsfaktor k ist, desto geringer ist das Signifikanzniveau α. – Zur Prüfung statistischer Hypothesen steht eine ganze Reihe verschiedener Tests zur Verfügung ( vgl. Infobox ). Jeder Test stellt andere Voraussetzungen an die Grundgesamtheit oder untersucht eine andere Hypothese. Der t-Test dient zum Vergleich zweier Mittelwerte aus normalverteilten Grundgesamtheiten, wenn die Standardabweichungen sx und sy zwar nicht bekannt sind, aber begründet angenommen werden kann, daß sie gleich sind. Dieser Test wird überwiegend bei kleinen Stichproben (N <200) angewendet. Der Sicherheitsfaktor k wird für das Konfidenzintervall durch die Größe tδ;α dargestellt, die einer Studentschen t-Verteilung genügt. Diese Verteilung geht für einen großen Stichprobenumfang in die Normalverteilung über. Der F-Test dient zur Prüfung der Hypothese, daß die Standardabweichungen sx und sy zweier Stichproben gleich sind unter der Voraussetzung einer Normalverteilung der Zufallsgrößen X und Y. Tests, die als Voraussetzung gewisse Annahmen über die Verteilung der Grundgesamtheit machen, nennt man parametrische Tests. Als statistischer Test, der keine Annahmen über die Grundgesamtheit macht, kann der Wilcoxon-Test als Vertreter sog. nicht-parametrischer Tests herangezogen werden. Er prüft die Hypothese, ob 2 Stichproben aus derselben Grundgesamtheit stammen. Als Beispiel einer weiteren Klasse von Tests dient der χ2-Anpassungstest (Chi-Quadrat-Anpassungstest). Er prüft, inwieweit eine beobachtete Zufallsgröße einem vorgegebenen Verteilungsgesetz genügt. Eine weitere nutzbringende Anwendung statistischer Verfahren ist die Beschreibung einer Menge experimenteller Daten durch eine theoretische Formel oder eine Kurve. Ersteres wird z.B. durch den χ2-Anpassungstest geleistet. Wenn kein Anhaltspunkt für die Gültigkeit einer allgemeinen Gesetzmäßigkeit vorliegt, wird eine Kurve gesucht, welche die gemessenen Daten am besten wiedergibt. Ein solches Verfahren nennt man Regressionsanalyse (Regression). Man bedient sich dabei der Methode der kleinsten Quadrate, die durch den franz. Mathematiker A.M. Legendre zuerst beschrieben wurde. Nach dem Prinzip der kleinsten Quadrate ( vgl. Infobox ) werden für einen vermuteten Zusammenhang zwischen gemessenen Größen die Koeffizienten einer Funktion gesucht, für die die Summe der quadratischen Abweichungen minimal wird. Werden die Koeffizienten a und b einer linearen Funktion der Größen x und y mittels der Beziehung y = ax + b gesucht, dann spricht man von linearer Regression, bei quadratischen Funktionen von quadratischer Regression usw. Tatsächlich findet man immer irgendeine Funktion, die besser als andere Funktionsverläufe zu den gemessenen Werten paßt. Wenn eine solche Funktion gefunden wird, sagt dies noch nichts über die Güte der Anpassung aus ( vgl. Abb. 8 ). Aus diesem Grund wurde als Gütefaktor der Korrelationskoeffizient eingeführt. Unter der Voraussetzung annähernd linearer Korrelation ist der Korrelationskoeffizient ein Maß für die Stärke des Zusammenhangs zwischen den Größen x und y. Altern, Biometrie, Fisher (R.A.), F-Statistik, Johannsen (W.L.), statistische Geometrie.

R.Kü.

Statistik

Abb.1: Objektive Fehler bei der Datengewinnung:

aoptimale Messung: der Mittelwert der Meßwerte weicht nur geringfügig vom zu erwartenden Wert (Kreiszentrum) ab. Die Abweichung des empirischen Mittelwerts (Mittel der Meßwerte) vom zu erwartenden Wert wird oft als Richtigkeit der Messung bezeichnet. Im Fall minimaler Abweichung, gegeben durch natürliche Schwankungsbreiten, ist die Messung von optimaler Richtigkeit. Der mittlere Abstand der Meßwerte untereinander wird Präzision genannt. Falls für eine Messung dieser Wert minimal wird, ist die Präzision optimal. bzufälliger Fehler: die Meßwerte verteilen sich gleichförmig um den zu erwartenden Wert. Die Präzision der Messung ist schlecht, die Richtigkeit hingegen gut. csystematischer Fehler: die Meßwerte zeigen untereinander nur eine geringe Streuung, weichen aber von dem zu erwartenden Wert stark ab. Die Präzision der Messung ist gut, die Richtigkeit hingegen schlecht. dgrobe Fehler: die meisten Meßwerte weichen nur geringfügig vom zu erwartenden Wert ab. Einzelne Werte hingegen zeigen extreme Abweichung. Das arithmetische Mittel reagiert von den sonst in der Mathematik bekannten Mittelwerten am empfindlichsten auf grobe Abweichung einzelner Meßwerte.

Statistik

Abb.2: Subjektive Fehler bei der Datengewinnung: Parallaxenfehler beim Ablesen eines Zeigerinstruments

Statistik

Abb.3:Häufigkeitsverteilung von Meßwerten:

a Häufigkeitspolygon, b Histogramm oder Säulenpolygon, c Häufigkeitskurve

Statistik

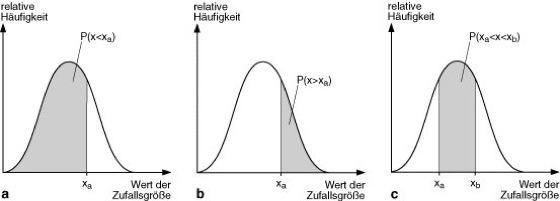

Abb.4:Wahrscheinlichkeiten bei Zufallsexperimenten:

a Wahrscheinlichkeit P, daß bei einem Zufallsexperiment ein Wert x kleiner als der Wert xa angenommen wird (graue Fläche). b Wahrscheinlichkeit P, bei einem Zufallsexperiment einen Wert x zu messen, der größer ist als der Wert xa (graue Fläche). c Wahrscheinlichkeit, einen Wert x zwischen den Werten xa und xb zu finden (graue Fläche).

Statistik

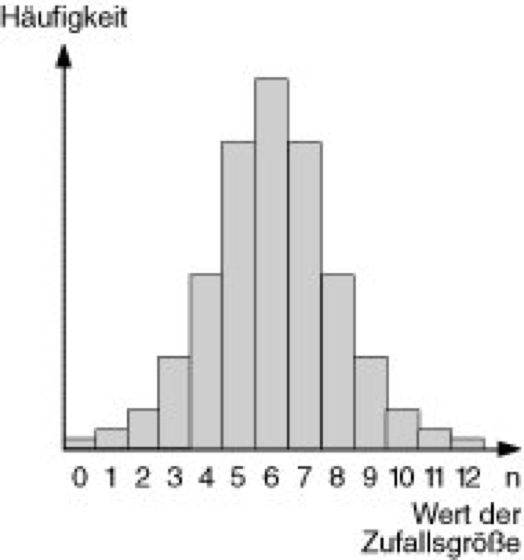

Abb.5:Binomialverteilung: Die Binomialverteilung bezeichnet die einzelnen Häufigkeiten (bzw. Wahrscheinlichkeiten) für eine Anzahl von Versuchen (= n). Die Anzahl ist immer eine natürliche Zahl und damit immer ganzzahlig. Man betrachtet immer eine Klasse der Breite = 1 (diskrete Verteilung). Der Interpolationsübergang zu einer Häufigkeitskurve (stetige Verteilung) ist bei einer Binomialverteilung/Poissonverteilung nicht möglich.

Statistik

Abb.6:Normalverteilung:a Darstellung als Säulenpolygon und als Häufigkeitskurve. ![]()

bezeichnet den Mittelwert der Messung, ± s ist die Standardabweichung. Der Bereich ![]()

± s umfaßt 68,27%, ![]()

±2s enthält 95,45%, ![]()

±3s umfaßt 99,73% aller Meßwerte. b Normalverteilung von Messungen mit optimaler Richtigkeit und Präzision (durchgezogene Linie) bzw. optimaler Richtigkeit und geringer Präzision (gestrichelte bzw. gepunktete Linie, Einfluß des zufälligen Fehlers). c Normalverteilung von Messungen mit guter Richtigkeit und Präzision (durchgezogene Linie) bzw. geringer Richtigkeit, aber guter Präzision (gestrichelte Linie, Einfluß des systematischen Fehlers), ![]()

1 Sollwert der Messung, ![]()

2, ![]()

3 Mittelwerte der Messungen mit geringer Richtigkeit.

Statistik

Abb.7:Irrtumswahrscheinlichkeit:a Wahrscheinlichkeit (α), mit der bei der Bestimmung der Anzahl weißer Blutkörperchen (Leukocyten) angenommen wird, daß ein eigentlich gesunder Mensch krank sei. b Wahrscheinlichkeit (β), daß ein kranker Mensch aufgrund der Meßergebnisse als gesund betrachtet wird.

Statistik

Abb.8:Korrelation:a geringe lineare Korrelation, b große lineare Korrelation

Statistik

Beispiel zur Berechnung des Standardfehlers

Eine Stichprobe von 250 Beobachtungen hat eine Standardabweichung von 3. Der Standardfehler des Mittelwerts SE (= Standard Error) berechnet sich zu:![]()

Eine weitere Stichprobe von 400 Beobachtungen derselben Zufallsgröße hat eine Standardabweichung von 5. Der Standardfehler des Mittelwerts berechnet sich zu:![]()

Zur Berechnung des Standardfehlers der Summe bzw. der Differenz der beiden Mittelwerte wird das Gaußsche Fehlerfortpflanzungsgesetz verwendet. Bei Summen bzw. Differenzen hat es eine besonders einfache Darstellung:![]()

ist also von der Form:![]()

Binomialverteilung

Der schweizerische Mathematiker Jakob Bernoulli (1655–1705) führte die Binomialverteilung folgendermaßen ein:

Ein bestimmtes Ereignis tritt mit einer Wahrscheinlichkeit p ein. Die Wahrscheinlichkeit für das Nichteintreten des Ereignisses ist q. Die Summe p + q beträgt dann 1 (sicherer Eintritt) und stellt das Ereignis p oder q dar.

Bernoullis Betrachtungen zeigen: die Wahrscheinlichkeit dafür, daß bei einer Anzahl von n Versuchen ein bestimmtes Ereignis eintritt, ergibt sich aus den einzelnen Summanden der Binomialentwicklung von (p + q)n, also durch die einzelnen Summanden der Summe

qn + nqn–1p + 1/2·n(n–1)qn–2p2 + ... + pn

oder allgemein als ![]()

mit den Binomialkoeffizienten![]()

Es kann gezeigt werden, daß das arithmetische Mittel der Binomialverteilung durch das Produkt np und die Standardabweichung durch ![]()

gegeben ist.

Anwendungsbeispiel: Die Wahrscheinlichkeit, an Tuberkulose (Tbc) zu erkranken, sei 0,001 (0,1%), d.h., daß von 100.000 Testpersonen durchschnittlich 100 Personen von dieser Krankheit betroffen sind. Die Erkrankungswahrscheinlichkeit ist q = 0,001. Das Gegenereignis zur Erkrankung ist der Fall, daß keine Tbc-Erkrankung vorliegt. Die Wahrscheinlichkeit für das Eintreten des Gegenereignisses sei p. Der Fall „krank“ oder „gesund“ tritt immer mit 100%iger Sicherheit ein. Deshalb gilt p + q = 1. Da q bereits vorgegeben ist, läßt sich durch Formelumstellung die Eintrittswahrscheinlichkeit des Gegenereignisses zu p = 0,999 bestimmen. Angenommen, es werden 4 Testpersonen willkürlich ausgewählt. Um die Wahrscheinlichkeit dafür zu berechnen, daß 0, 1, 2, 3 oder alle 4 Testpersonen erkrankt sind, wird wie folgt verfahren.

Die Binomialentwicklung von (p + q)4lautet:

q4 + 4q3p1 + 6q2p2 + 4q1p3 + p4

1. Summand 2. Summand 3. Summand 4. Summand 5. Summand

Der erste Summand steht für die Wahrscheinlichkeit, daß alle 4 Personen erkrankt sind. Der zweite Summand steht für den Fall, daß 3 Personen krank und 1 Person gesund sind, usw. Die Exponenten an den entsprechenden Wahrscheinlichkeiten geben immer die betreffende Personenzahl wieder.

Poissonverteilung

Der französische Mathematiker Siméon Denis Poisson (1781–1840) entwickelte im Jahre 1837 die Theorie der Poissonverteilung. Die Binomialverteilung kann durch eine Poissonverteilung ersetzt werden, wenn folgende Voraussetzungen erfüllt sind:

1. Die Eintrittswahrscheinlichkeit p eines Ereignisses ist sehr klein.

2. Der Stichprobenumfang n ist sehr groß.

3. Das Produkt np (Mittelwert der Binomialverteilung) kann nicht vernachlässigt werden.

Die Vorteile der Poissonverteilung gegenüber der Binomialverteilung liegen in ihrer einfacheren Berechenbarkeit. Setzt man den Mittelwert der Binomialverteilung np = m, so kann unter oben genannten Voraussetzungen die Reihe (p + q)n ersetzt werden durch die Poissonreihe:

e–m(1 + m/1 + m2/2! + m3/3! + ... + mn/n!)

wobei der Buchstabe e für die Eulersche Zahl e = 2,71828 steht (Exponentialfunktion).

Normalverteilung

Diese Verteilung wurde im Jahre 1733 zum ersten Mal von dem französischen Mathematiker Abraham de Moivre (1667–1754) hergeleitet. Unabhängig davon wurde sie später auch von Laplace und Gauß gefunden. Sie wird aus diesem Grund manchmal Gaußverteilung und wegen ihrer frühen Anwendung auf die Verteilung astronomischer Daten Gaußsche Fehlerkurve genannt. Die Normalverteilung beschreibt nicht wie die Binomial- und die Poissonverteilung eine diskrete, sondern eine stetige Zufallsgröße. Die Gleichung, welche die Normalverteilung einer stetigen Zufallsgröße beschreibt, hat die Form![]()

wobei m den Mittelwert und gleichzeitig das Maximum der Normalverteilung darstellt. Die Größe s entspricht der Standardabweichung, s2der Varianz dieser Verteilungsfunktion. Die Normalverteilung wird allein durch die Werte m und s bestimmt ( vgl. Abb. 6 ). Da die Fläche unter einer Verteilungskurve immer einer Wahrscheinlichkeit entspricht, kann gezeigt werden, daß bei einer normalverteilten Zufallsgröße die beobachteten Werte (bei hinreichender Anzahl)

– zu rund 68% im Intervall (m – s; m + s)

– zu rund 95% im Intervall (m – 2s; m +2s)

– und zu mehr als 99% im Intervall (m –3s; m +3s) liegen.

Berechnung des Sicherheitsfaktors k

Für beliebige Verteilungen der Grundgesamtheit kann für den Sicherheitsfaktor lediglich eine untere Grenze angegeben werden: ![]()

. Dies bedeutet, daß z.B. bei einer vorgegebenen Irrtumswahrscheinlichkeit von α = 1% (also α = 0,01) der Sicherheitsfaktor ![]()

, d.h. k ≥10 gewählt werden muß. Wählt man nur einen Sicherheitsfaktor von k = 2, so wird der tatsächliche Mittelwert der Grundgesamtheit statistisch in mindestens 25% der Fälle außerhalb des Intervalls [m –2sm, m +2sm] liegen.

Statistischer Hypothesentest (Anwendungsbeispiel)

Gegeben seien 2 menschliche Populationen A und B. X sei die Körpergröße der Population A, Y die Körpergröße der Population B. X und Y unterliegen als Zufallsgrößen einer gewissen Verteilungsfunktion (z.B. Normalverteilung). Aufgrund langjähriger Beobachtungen seien die Standardabweichungen sx und sy bekannt. Es wird nun aus jeder Population eine gewisse Anzahl von Individuen ausgewählt und deren Körpergröße gemessen. Dabei ergeben sich die beiden Mittelwerte mx und my, die voneinander abweichen (|mx – my| ≥0) sollen. Wenn die Populationen aus derselben Grundgesamtheit stammen, müßte bei genügend großem Stichprobenumfang |mx– my| = 0 gelten. Die Annahme |mx– my| = 0 heißt Nullhypothese. Ob die auftretende Differenz zwischen den beiden Mittelwerten statistisch bedingt ist, oder ob die beiden Mittelwerte aus 2 verschiedenen Grundgesamtheiten stammen, kann so nicht festgestellt werden. Wird eine Abweichung |mx – my| ≥0 innerhalb eines Konfidenzintervalls gemessen, und entscheidet man sich aufgrund dieser Abweichung dafür, die Populationen unterschiedlichen Grundgesamtheiten zuzuordnen, obwohl sie möglicherweise aus derselben Grundgesamtheit stammen, dann begeht man einen Fehler einer maximalen Größe von < α (Fehler 1. Art). Ein ganz anderer Fehler wird gemacht, wenn sehr geringe Abweichungen der beiden Mittelwerte den Schluß nahelegen, daß die Populationen aus derselben Grundgesamtheit stammen, obwohl sie tatsächlich zu unterschiedlichen Grundgesamtheiten gehören (Fehler 2. Art). Zwischen den beiden Fehlerarten besteht im allgemeinen kein einfacher Zusammenhang. Da bei einem Test prinzipiell diese beiden Fehler möglich sind, kann nicht gesagt werden, die Irrtumswahrscheinlichkeit α sei die Wahrscheinlichkeit, mit der man sich bei einem statistischen Test irrt. Sie ist vielmehr die Wahrscheinlichkeit, mit der eine richtige Hypothese (|mx – my| = 0) irrtümlicherweise abgelehnt wird ( vgl. Abb. 7 ).

Prinzip der kleinsten Quadrate

Der wahrscheinlichste Wert einer beobachteten Größe hat die Eigenschaft, daß die Summe der quadratischen Abweichungen der gemessenen Werte von diesem Wert in ihm ihr Minimum findet.

Wenn x1, x2, ... xn Beobachtungswerte einer beliebigen gegebenen Größe sind, so ist Φ nach dem Prinzip der kleinsten Quadrate der wahrscheinlichste Wert für diese Größe, falls es so gewählt wird, daß

(x1 – Φ)2 + (x2 – Φ)2 + ... + (xn – ≤Φ)2

minimal wird.

Mit diesem Prinzip läßt sich auch zeigen, daß der wahrscheinlichste Wert für eine gemessene Größe das arithmetische Mittel der Beobachtungswerte ist.

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.